宇树开源UnifoLM-VLA-0:让机器人真正“看懂”并“动手”

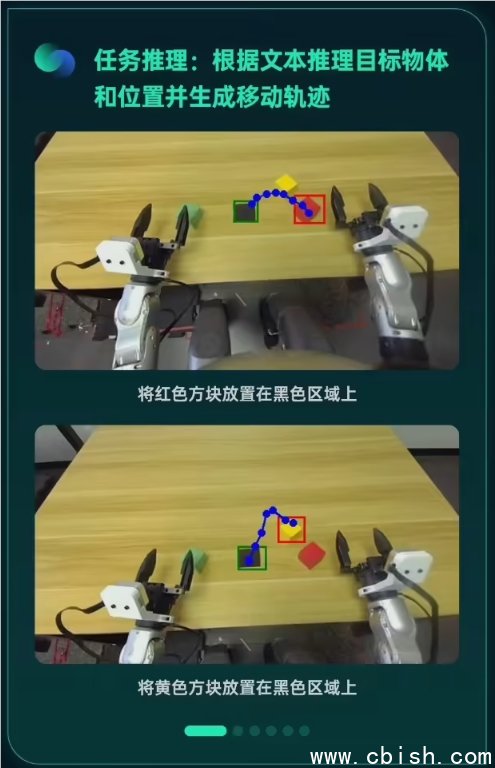

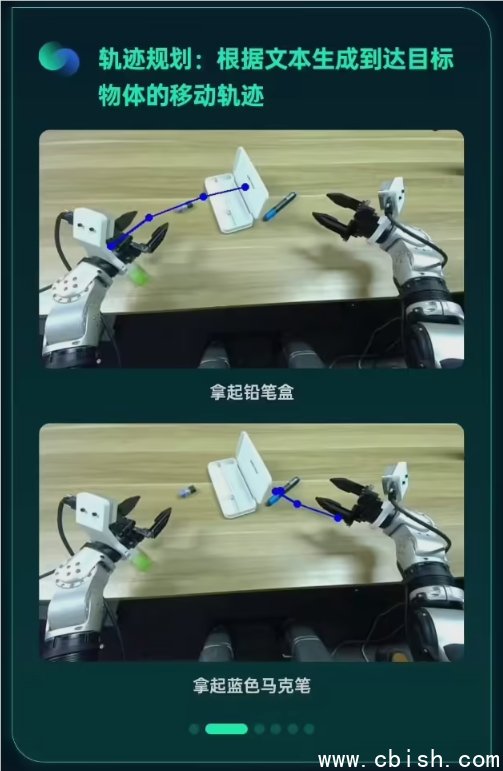

今天,宇树科技正式开源了UnifoLM-VLA-0——一个专为人形机器人打造的视觉-语言-动作大模型。这不是又一个能聊天、能识图的AI模型,而是一个能看、能想、能动的“机器人大脑”。它不再只是回答“这是什么”,而是能听懂“把桌上的水杯递给我”,然后准确伸手、抓取、转身、递出,一气呵成。

不是“理解图片”,是“理解物理世界”

过去很多视觉语言模型,看到“杯子”就知道是杯子,但不知道它有多重、会不会倒、手抓哪里才不会滑。UnifoLM-VLA-0不一样——它是在真实机器人身上“练”出来的。

训练数据来自宇树G1机器人在实验室和家庭场景中实际操作的340小时视频与动作记录。不是合成数据,不是模拟器里的理想环境,是真机在灯光变化、地面不平、物体摆放杂乱的情况下,一次次尝试、失败、调整后积累的实战数据。

模型学会了: - 手指该用多大劲捏住马克杯,才不会捏碎或滑落; - 把书从书架上拿下来时,要先挪开旁边的台灯; - 递东西时,得转个身,让对方容易接住。 这些不是规则写进去的,是模型从数据里自己“悟”出来的物理常识。

架构扎实,不靠堆参数

UnifoLM-VLA-0的底子是Qwen2.5-VL-7B,但宇树团队没简单“加点功能”,而是重新打磨了整个训练流程。

他们清洗了海量机器人操作数据,剔除模糊画面、无效指令、动作断续的片段,只保留真正能教会机器人“做事”的片段。训练时,模型不是预测下一个词,而是预测下一步该动哪个关节、用多大扭矩、持续多久。

结果惊人:仅用70亿参数,就在多个空间推理和动作预测测试中,超越了基座模型,甚至在某些任务上接近谷歌Gemini-Robotics-ER1.5——后者背后是Google DeepMind数年投入和海量算力。

一个模型,干12件事,还能抗干扰

最让人眼前一亮的,是它在G1机器人上的实测表现。

同一个模型、同一个权重文件,不用换程序、不用重新训练,就能完成:

- 从抽屉里取出袜子并叠好

- 把水壶从灶台端到餐桌

- 捡起地上的玩具,放进收纳箱

- 打开带锁的柜门(需要先识别锁扣位置)

- 在有人走过时,临时避让并重新规划路径

- 识别并拿起不同形状的工具(螺丝刀、剪刀、钳子)

- ……共12项真实家庭任务

更关键的是,测试时有人故意推机器人手臂、移动物体位置、关灯,它都能靠视觉和记忆重新判断,继续完成任务。不是靠预设的避障算法,是模型自己“看出来不对了,得改”。

开源,不是噱头,是真开放

宇树没有把模型藏起来当“黑盒”。今天起,UnifoLM-VLA-0的完整代码、训练数据说明、模型权重、部署文档,全部公开在GitHub。

你可以在自家电脑上跑推理,用自己家的摄像头和机械臂做测试;开发者可以基于它训练机器人做厨房清洁、老人陪护、仓库分拣;高校团队能拿它做人机交互研究。

我们见过太多“开源”只是贴个链接,代码跑不起来,文档全是AI生成的。这次不一样——宇树团队提供了清晰的安装指南、真实视频演示、甚至包括了如何在ROS系统中集成的步骤。

这不是为了刷热度,而是希望更多人能一起,让机器人真正走进生活。毕竟,一个能自己叠衣服、递水杯的机器人,比任何宣传语都更有说服力。

项目地址:https://github.com/UnitreeAI/UnifoLM-VLA-0