蚂蚁开源LingBot-World:一个能“记事”、能“互动”的真实数字世界

1月29日,蚂蚁灵波科技正式开源LingBot-World——一个可以长时间稳定运行、支持实时操控、还能“记住”你之前做过什么的高保真虚拟世界引擎。这不是又一个生成视频的AI工具,而是一个能让你像在游戏里一样自由走动、改变天气、操控车辆,甚至让一栋楼在你离开60秒后依然原样存在的“数字演练场”。

它不靠堆参数,而是靠扎实的工程设计:连续生成近10分钟的视频,画面不会变形、不会消失、不会突然崩坏。这在业内是罕见的——大多数模型撑过30秒就容易“失忆”,物体跑偏、背景塌陷,而LingBot-World能让你的镜头从一条街的这头拍到那头,再绕回来,车还在原地停着,房子没塌,树也没长歪。

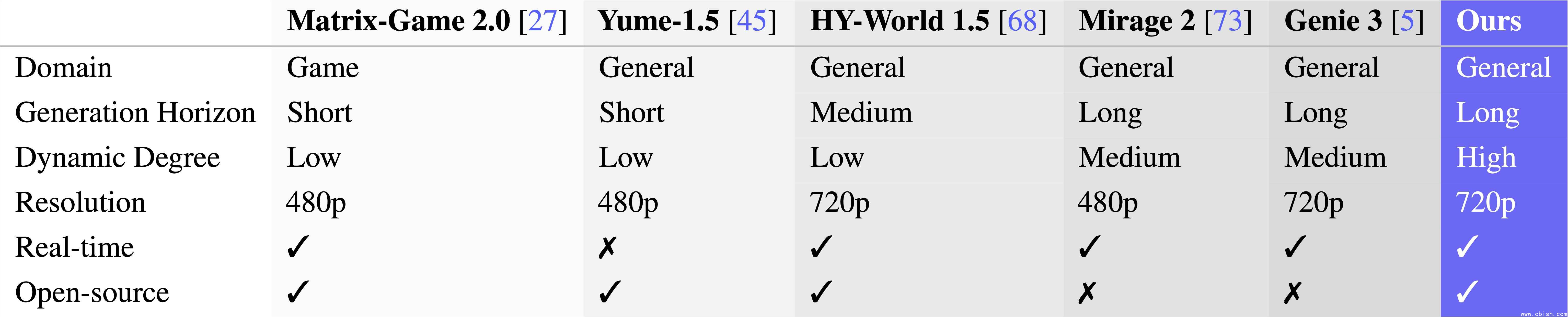

(图说:LingBot-World在适用场景、生成时长、动态程度、分辨率等方面均处于业界顶尖水平)

你不是观众,是导演

你不用等它生成完才能看。打开LingBot-World,用键盘控制角色移动,鼠标调整视角,画面立刻响应,延迟低于1秒,流畅度接近16帧/秒——这已经接近主流游戏的实时渲染水平。你可以说:“下雪”“改成黄昏”“让那辆车开走”,它就能在不破坏场景结构的前提下,把天气、光影、物体状态全改了,而且改得自然,不会突兀跳帧。

你甚至不用从头开始造世界。拍一张现实中的街景照片,或者截一张游戏画面,扔进去,它就能自动生成一个可交互的动态版本。不需要你标注、不需要你训练,也不需要你买昂贵的UE5引擎。这对独立开发者、游戏工作室、自动驾驶团队来说,意味着省下数月的建模和数据采集时间。

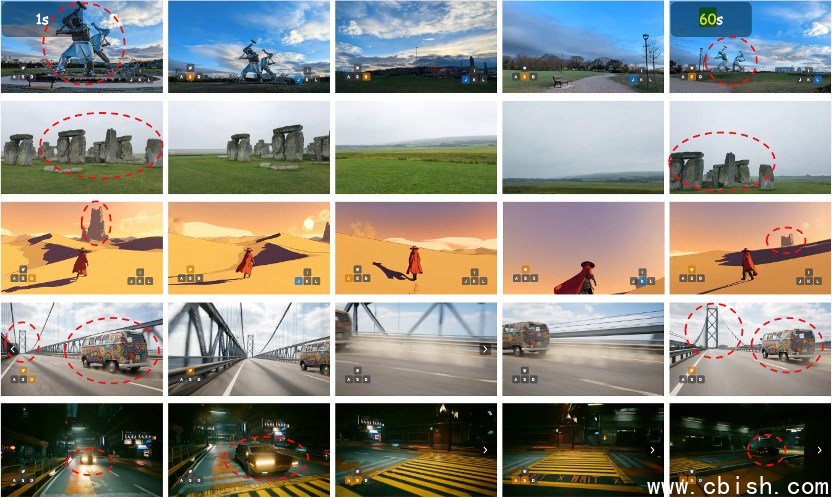

(图说:一致性压力测试,镜头最长移开60秒后返回,目标物体仍存在且结构一致)

(图说:高动态环境下,镜头长时间移开后返回,车辆形态外观仍保持一致)

(图说:镜头长时间移开后返回,房屋仍存在且结构一致)

怎么做到的?不是靠魔法,是靠数据

LingBot-World不是凭空训练出来的。团队花了大量时间清洗真实网络视频,覆盖城市、乡村、高速路、商场等不同环境。但光靠视频不够——真实世界里没人会告诉你“我按了W键,车就往前走了1.2米”。

于是他们自己造数据:用虚幻引擎(Unreal Engine)搭建虚拟场景,直接从渲染层抓取无UI干扰的画面,同步记录每一个按键、每一帧相机位姿。换句话说,他们让AI“看”了成千上万次“我动一下,世界怎么变”,而不是让它猜。

这种“动作-反馈”对齐的数据,比单纯让AI看100万条短视频有用得多。这也是为什么它能理解:你推了一辆车,它不会原地打转,而是会沿着你推的方向滑出去;你关了灯,阴影会跟着变,而不是整个画面突然变灰。

谁在用?开发者、研究员、游戏团队

自动驾驶公司不再需要花几个月在真实路口采集数据。他们可以在LingBot-World里生成1000种下雨天的交叉路口,测试算法在不同车流密度下的反应。

游戏工作室能快速搭建测试关卡:把一张实拍的森林照片丢进去,几分钟内就能生成一个能跑能跳、有物理碰撞、能改变天气的3D世界,省下美术团队数月的建模工作。

高校机器人实验室能用它训练AI“记忆”任务:比如“去厨房拿杯子,再送到客厅”,中间穿插开门、避障、绕行等复杂动作,而不必每次真机跑一遍,浪费电池和时间。

开源,不藏私

这次,蚂蚁没有把LingBot-World锁在实验室里。模型权重、推理代码、使用文档,全部公开在InclusionAI社区。你不需要申请权限,不需要签NDA,直接下载就能跑。

这不是“秀肌肉”,而是一次明确的站队:他们相信,AGI的未来不是靠一家公司闭门造车,而是靠开放生态,让真正需要它的人,用它去解决问题。

从空间感知模型,到VLA基座,再到LingBot-World,蚂蚁灵波的三步棋,不是在追AI热点,而是在构建一个从“看懂世界”到“互动世界”再到“创造世界”的完整路径。现在,这条路,向所有人开放。

你可以在GitHub上找到它,用你的笔记本电脑跑起来,试试看:

- 能不能让一只猫从你镜头前跑过,5分钟后它还在原地打盹?

- 能不能在暴雨中让一辆车打滑,然后手动把它扶正?

- 能不能用一张街拍照片,生成一个能自由探索的3D城市?

答案是:能。而且,免费。