蚂蚁灵波开源LingBot-VA:让机器人“边想边做”,真机表现惊艳

1月30日,蚂蚁灵波科技正式开源其最新成果——具身世界模型 LingBot-VA。这是继空间感知模型LingBot-Depth、具身大模型LingBot-VLA和模拟环境LingBot-World之后,团队推出的第四款开源工具。不同于以往“先仿真、再实机”的传统路径,LingBot-VA直接打通了“视觉感知—世界推演—动作生成”全链路,让机器人能像人一样,在看到场景的瞬间,就同步想好下一步该怎么做、怎么动。

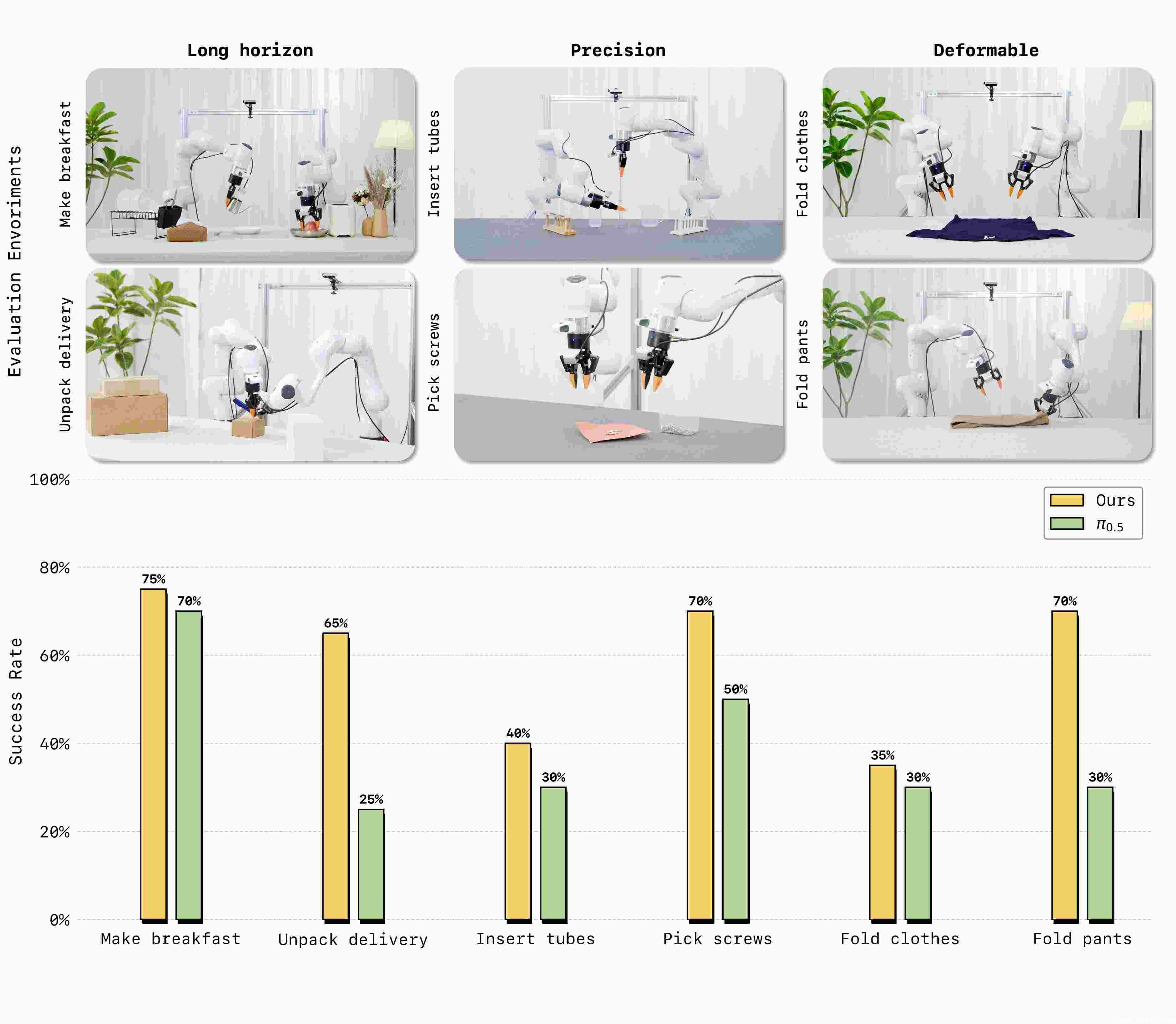

在真实机器人测试中,LingBot-VA仅用30到50条人工演示视频,就学会了完成一系列高难度操作:把早餐食材按顺序摆上桌、从快递盒里精准取出螺丝、把试管插入试管架、叠裤子、拆快递包装……这些任务对传统机器人来说,要么需要大量标注数据,要么一遇到轻微扰动就失败。而LingBot-VA在这些场景中的成功率,平均比目前业界最强的基线模型Pi0.5高出20%以上。最让人意外的是,它连“叠裤子”这种需要柔性形变判断的任务,也能稳定完成,没有出现“扯破”或“堆成一团”的情况。

(图说:真机评测中,LingBot-VA在多项高难操作任务上性能超越业界标杆 Pi0.5)

仿真测试破纪录:双臂协作成功率超90%

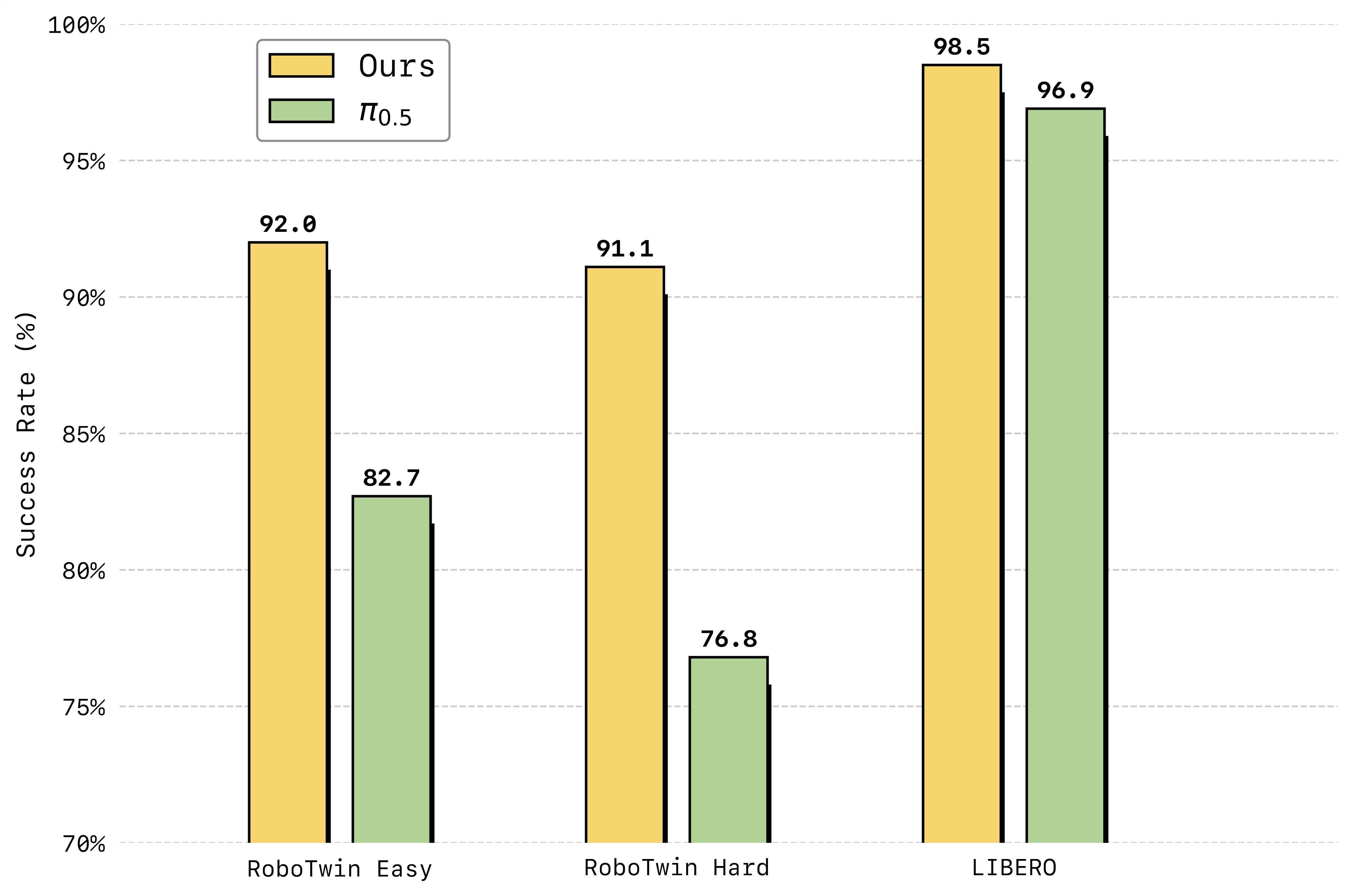

在仿真环境中,LingBot-VA的表现更让人惊讶。在业内公认的高难度双臂协同操作基准RoboTwin2.0上,它首次将任务成功率突破90%,远超此前所有模型。而在长时序任务基准LIBERO上,它达到了98.5%的平均成功率——这意味着,机器人连续执行20步以上、中间不能出错的复杂任务,几乎不会“翻车”。

这些成绩不是靠“刷数据”得来的。LingBot-VA的核心是首创的“自回归视频-动作联合建模”框架:它不是先看一眼画面,再单独算动作,而是每生成一帧画面的同时,就同步预测出接下来机器人该动哪个关节、用多大扭矩。这种“所见即所动”的方式,让模型对物理规律的把握更自然,也更贴近人类的直觉反应。

(图说:LingBot-VA在LIBERO与RoboTwin2.0仿真基准测试中刷新现有SOTA)

不靠算力堆,靠设计省:真机也能跑得快

很多人担心,这么强的模型,是不是得用上几十张A100才能跑?LingBot-VA偏偏反其道而行。它用了一种叫“Mixture-of-Transformers(MoT)”的结构,让视频理解模块和动作控制模块像两个默契的搭档,各司其职又实时对话。更重要的是,它设计了一套“异步推理”机制:画面生成和电机指令输出不是“等一拍、走一步”,而是并行处理。你看到它在“想”,其实它已经在动了。

为了减少延迟,团队还加了“记忆缓存”和“噪声历史增强”技术。简单说,就是让机器人“记得刚才干了啥”,哪怕摄像头偶尔被遮挡、画面有点抖,它也能靠记忆补全信息,不需要每次都从头重新推演。这使得在真实机器人上,它的响应速度能控制在200毫秒以内——比人眨一次眼还快。

开源,不为炫技,为落地

蚂蚁灵波这次没藏私。LingBot-VA的模型权重、推理代码、训练脚本,全部开放在GitHub上,任何人都可以下载、复现、改造。他们不只想做一家“技术领先”的公司,更想推动整个行业往前走。此前开源的LingBot-World(模拟器)、LingBot-VLA(智能基座)、LingBot-Depth(空间感知),加上这次的LingBot-VA,已经形成了一套完整的“具身智能工具链”——从环境搭建,到感知理解,再到动作控制,一应俱全。

这不是实验室里的玩具。团队透露,部分技术已在物流分拣、家庭服务机器人等真实场景中试点,比如帮老人拿药、在仓库里自动识别并抓取不同形状的包裹。他们希望,未来三年内,能让更多中小团队、高校实验室,用上这套“开箱即用”的系统,不再从零开始造轮子。

现在,你可以在GitHub上搜索“LingBot-VA”,直接下载模型,用你手头的机器人试试看——它可能不是最炫的,但可能是第一个,真正能让你的机器人“活过来”的模型。