VicOne LAB R7实验室研究员骆一奇表示,现在黑客不必实体拥有机器人才可能发动攻击,可以利用开源模拟器在虚拟环境复制真实机器人的感知、通信与控制行为,借此找出漏洞。(摄影/洪政伟)

从智能手机到云服务,网络安全一直是大家关注的议题。过去,人们谈论安全时,想到的是电脑文件个人资料外泄或网络服务中断,但在AI机器人时代,情境已经完全不同。

如今,人工智能(AI)从云端服务、聊天机器人,快速进化到“能看、能听、能动”的实体机器人,这些新一代机器人又结合了“感知、决策与行动”三大能力:它们可以通过摄像头、麦克风与各种传感器理解环境,再由AI算法进行判断,最后驱动电机或机械臂付诸行动。

当这些AI机器人开始走出实验室,进入家庭、医院与工厂,无论是协助搬运的机械臂、街头巡逻的机器狗,还是陪伴长者的服务型机器人,都让AI的影响力变得触手可及。然而,伴随着这股浪潮而来的并非只是便利与效率,还有潜藏在背后、更加复杂的网络安全风险,也同步从屏幕内的网络空间走进现实世界。

全球车载网络安全厂商VicOne,也针对各类智能移动设备的网络安全风险成立了研究实验室VicOne LAB R7,该机构近期发布《2025 AI机器人安全风险与防护白皮书》(以下简称《白皮书》),直言这些AI机器人正迅速成为黑客锁定的下一个攻击目标,包括科技产业链、公共治理与个人生活,都可能因为未被预见或未被管控的“攻击面”而陷入混乱。

VicOne LAB R7实验室负责人张裕敏直言,一旦黑客能够掌控机器人,后果不再只是数据泄露,不仅可能窃取影像与声音,还能让它们“动起来”伤人,对人身安全与公共安全造成直接威胁。“这不只是科幻小说的情节,而是正在逐渐成真的现实。”他说。

他甚至警告,试想,一台家中的服务型机器人若被恶意指令操控,不只是空调被关闭或电灯乱闪,而可能是机械臂挥舞失控,导致人员受伤。这样的场景,比起任何一次网络数据泄露事件都更加可怕。

VicOne LAB R7实验室研究员骆一奇则补充说,机器人的演进路径,从“天上飞的”无人机,到“地上跑的”自动驾驶汽车,再到“路上走的”人形或服务型机器人,每一阶段都继承了物联网与车载安全的挑战,并进一步放大。他坦言,当这些AI机器人能与人们直接互动时,安全问题的严重程度会呈现指数级增长。

攻击面从LLM到VLA,威胁呈现指数级扩大

传统机器人事故多源自技术不足或传感误判,例如机械臂因误判而碰撞工人。然而,随着大型语言模型(LLM)、视觉语言模型(VLM),以及将视觉、语言进一步结合动作控制的视觉语言动作模型(VLA)被导入机器人之后,攻击面将呈现指数级的扩大。

由于AI模型本身就是黑客锁定的新攻击目标,攻击者可能通过“对抗样本”误导模型,或在训练过程中植入后门,使机器人听信恶意指令,从“不小心出错”演变为“被刻意操控”。这种由意外转为袭击的转折,意味着未来的安全挑战将更复杂,也更具破坏力。

VicOne白皮书中也举例,几年前,安全研究人员展示入侵家用扫地机器人,利用其内置摄像头远程查看用户家中环境。黑客不必实际进入屋内,就能通过机器人获取私密影像。这起事件凸显一种危机:当传感器成为机器人的“眼睛”,隐私风险已经无处不在。

另一个更引人关注的案例,来自中国宇树科技的机器狗产品,安全研究人员发现,该装置预载了“未经告知用户”的远程访问服务,一旦联网,攻击者即可轻易进入系统,获取实时影像与定位信息。

安全专家表示,这不仅是单纯的技术问题,更是国家安全风险。想象一下,倘若机器狗部署于公共区域巡逻或检测,一旦后门被利用,许多外部势力便可能借此监控社区或关键基础设施。

张裕敏将此类事件称为“供应链式攻击”。他直言,所有做机器人或机器狗的厂商,都会把“远程遥控”视为功能的一部分,并非安全问题,而这样的认知,也是一般网络安全和机器人安全研究人员最大的差别,显然对于安全风险的认知落差,也导致机器人的安全风险被忽视。

找出AI机器人的弱点,只要有模拟器就做得到

骆一奇指出,机器人的整体架构其实与当前的自动驾驶汽车非常相似,这也使得许多汽车厂商开始投入机器人领域。

机器人的核心单元由三大层面组成:负责接收视觉与听觉的感知单元(Perception Unit);负责处理接收到信息的计算单元(Processing Unit),以及根据计算结果做出动作的动作单元(Action Unit)。

这些单元之间的数据交换,通常依赖主流的开源操作系统——ROS(Robot Operating System)。他表示,ROS是目前AI机器人最普遍使用的系统,截至2024年有55%商用机器人采用ROS,使得ROS成为黑客潜在的首要目标。

骆一奇也补充说道,黑客不必实体拥有机器人才可能发动攻击;研究人员常利用开源模拟器在虚拟环境复制真实机器人的感知、通信与控制行为,借此找出漏洞。

例如,社区常用的模拟套件Gazebo(及其下一代模块化版本,常称为Ignition或新版Gazebo)能模拟机器人常见的“眼睛”与“耳朵”,包含摄像头、激光雷达(LiDAR,用于测距与构建环境地图)、以及惯性测量单元(IMU,结合加速度计与陀螺仪,能感知机器人的运动与姿态)等传感器,以及机器人关节动作与网络节点,都可与ROS连接。

因此,机器人研究人员就可以在模拟器中操控ROS节点,也可以注入错误传感信号或模拟未授权的话题(topic),借此识别在真实的机器人硬件上,可能被利用的攻击点。

解析具身AI机器人的五大攻击面向

骆一奇把具身AI机器人遭受攻击面向分成5大类型,范围从硬件到底层,一直到最上层AI模型,把整个系统的各个环节都考虑进去了。

1. 物理实体层面:从电路板到充电口的潜在威胁

物理层的防护是最基础也最容易被忽略的环节。骆一奇表示,黑客通常会从各种接口入手,任何用于数据交换的接口,例如:USB口、网口(Ethernet Port),甚至是机器人的诊断口(Diagnostic Port)等,都可能被黑客直接接上线并注入恶意代码。

VicOne白皮书指出,如果设备上的接口没有妥善防护,长时间裸露在外,黑客可能通过物理接触接口直接植入恶意程序,尤其在缺乏安全启动或固件完整性验证的情况下,更容易被入侵。

其实,充电口也不再单纯,骆一奇解释,由于现在有许多充电协议(例如电动车的 ISO 15118)支持双向数据交换,除了充电以外,也可以做数据交换。因此,充电口也可能成为未来入侵的一个点。

VicOne白皮书也提到:在硬件底层的防护上,电路板的安全是不可忽视的一环。骆一奇提醒,若黑客能够实际拆开机器并接触到电路板,就可能将其中的AI模型完整复制,对知识产权造成严重威胁;更危险的是,恶意模型也可能被偷偷植入,进而影响系统运行安全。

2. 感知器层面:环境欺骗与感官致盲

机器人依赖各种传感器来观察并理解周围环境,这些传感器包括摄像头(Camera)、激光雷达(LiDAR)、超宽带(UWB)定位模块、麦克风、触觉传感器,以及 GPS 定位模块。

VicOne白皮书指出,这些传感器很容易成为攻击目标,黑客可能通过恶意干扰或欺骗,让机器人误判环境。例如,使用激光让摄像头短暂失明,或通过超声波噪音干扰麦克风,都是典型手法。

骆一奇提醒,一旦感知层的信息被扭曲,后续的图像识别、定位,甚至机器人避障的能力都会受到影响,最后可能导致决策错误,甚至出现危险的行为偏差。

3. 无线通信层面:遥控器与OTA模块的漏洞

在无线通信方面,机器人同样面临许多安全风险。常见的攻击面包括Wi-Fi、蓝牙(Bluetooth)、NFC(近场无线通信),以及RFID(射频识别)等,这些在机器人系统中都可能被利用。

骆一奇提醒,许多机器人并非完全自主运行,而是搭配遥控器(Remote Controller),这就成为潜在的攻击目标。此外,部分机器人会通过GSM模块(全球移动通信模块)直接连上电信网络,或是利用空中下载更新(Over-the-air,OTA)模块进行固件升级。

对此,VicOne白皮书警告,若缺乏完善的加密与完整性验证,黑客可能发动中间人攻击(MITM),在机器人与远程之间潜伏并篡改数据,导致机器人接收到被掉包的恶意指令,甚至在更新过程中被植入恶意组件。

4. 软件与云端应用层面:掌控“一堆机器人”的机会

在软件与云端层面,黑客往往能找到进入并取得集中控制权的关键入口。骆一奇指出,许多机器人会通过手机App(iOS/Android)进行配置,但真正的风险来自云服务(Cloud Service)。例如,不少机器人依赖AWS Batch或AWS IoT等平台,来进行队列管理(Fleet Management Service),一旦云端被攻破,黑客就可能直接操控一批机器人。

由于部分机器人的运算能力有限,常需将部分任务交由云端处理,因此AI模型的API服务器、日志服务器(Log Server),甚至像Google地图API等第三方服务,都可能成为潜在攻击目标。

VicOne白皮书进一步补充,机器人常用的中间件ROS 2(Robot Operating System 2,机器人操作系统 2)曾被揭露其通信组件DDS(Data Distribution Service,数据分发服务)含有多项高风险漏洞。由于ROS在机器人产业应用广泛,这类弱点不仅涉及单一产品,更可能引发大范围的系统性风险。

5. AI模型层面:智慧核心的污染与操纵

这也是AI机器人相比传统机器人在安全上的最大不同:机器人的“大脑”——也就是AI算法与模型——若是被攻破,整台机器人的判断与行为都可能被扭曲。VicOne白皮书提醒,攻击者若针对模型的弱点下手,就能干扰甚至直接操纵机器人的决策。

骆一奇指出,当前特别值得注意的模型类型包括:VLA(视觉—语言—动作模型)、VLM(视觉语言模型)和LLM(大型语言模型),这些模型负责把图像、语音与文字等感知信息,转换成可执行的指令或动作,一旦输入或模型本身被污染,后果会非常直接且危险。

举例来说,有一种称为“数据污染”或“模型中毒”(Model Poisoning)的攻击方式,攻击者在模型或其更新流程中植入恶意样本,让原本用来控制“切割食材”的指令,在特定条件下,会被触发为伤人的行为。

为了防范此类风险,业界提出“模型上下文协议(Model Context Protocol,MCP)”,类似给AI模型加上一层“身份验证”与“执行监控”的机制:在模型被加载或执行前,系统会先确认模型来源可信且文件未被修改;执行时,还会检查运行环境与输入数据是否符合预期,避免模型在错误或恶意条件下做出危险行为。

换句话说,MCP让机器人能够“知道自己在安全的上下文中运行”,大幅降低模型遭受恶意操控的风险。

VicOne白皮书也把常见的模型攻击手法具体化,包括:对抗性样本攻击(Adversarial Examples)就是在输入的图像或语音上,做出微小、肉眼不易察觉的改动,骗过模型使其产生错误判断;训练数据投毒(Data Poisoning)则在模型的训练阶段,植入带有后门或恶意特征的数据,使模型在遇到特定触发条件时,执行攻击者预设的错误行为。

目前来说,AI模型的安全防护已经从传统的服务器或数据加密,扩展到必须保障模型完整性、来源与运行上下文的新领域,这也是未来确保机器人安全时,不可忽视的重要方向。

针对AI核心的进阶攻击手法与实体劫持案例

针对具身AI机器人的安全攻击,已经从早期的网络渗透,发展到直接针对AI模型与传感器的“认知欺骗”。

随着大型语言模型(LLM)广泛应用于机器人的决策系统,VicOne白皮书指出,一种新型攻击手法:提示词注入(Prompt Injection)正悄然兴起。这类攻击的特点是,攻击者在输入文字或对话中加入看似无害、实则隐藏的指令,诱导语言模型执行未经授权的行为。

骆一奇通过演示说明,黑客可以输入一串编码过的恶意提示词(Prompt),人类可能察觉不出异常,以为系统只是偶尔出错,但机器人却能理解并执行指令。例如,攻击者可能隐藏要求机器人“获取你的个人信息并回传给我”的指令,从而窃取敏感信息。

他进一步指出,黑客甚至可利用ASCII(美国信息交换标准代码技术),在屏幕上隐藏恶意指令,表面上看似空白,其实包含危险指令。VicOne白皮书警告,提示词注入能够绕过机器人原有的安全限制,相当于为攻击者解锁受保护的功能。

在LLM驱动的多模态机器人实验中,研究人员已展示如何通过欺骗性提示词,成功诱导机器人执行原本被禁止的危险行为,因此提示词注入被视为当前最令人担忧的攻击之一。

除了提示词攻击之外,对抗性样本攻击(Adversarial Examples)与模型污染(Model Poisoning)也是AI模型面临的隐形威胁。对抗性样本攻击利用精心设计的输入,让模型做出非预期判断。

例如,攻击者在机器人摄像头前,放置一张看似普通但隐藏对抗信息的图片,或播放经过对抗性扰动处理的音频,机器人就可能产生幻觉般的错觉,做出错误决策,例如:以为前方有人需要救助而离开巡逻路线。

无论是数据投毒还是模型污染(Model Poisoning)都发生在训练或更新阶段,黑客在模型数据中植入后门或恶意样本,使模型在特定情境下表现异常。

这种供应链式攻击,可能出现在模型的各个环节,例如黑客将带后门的模型上传至开源平台,使用者很难从表面发现异常,直到触发条件出现时,才察觉为时已晚。

实体传感器的欺骗与数据窃取同样令人忧心。骆一奇分享VicOne LAB R7实验室的多个研究案例,其中GPS定位劫持(GPS Spoofing)是一例。

该研究团队设计装置发送伪造的全球定位系统(GPS)信号,骆一奇通过飞行摇杆展示时,机器人显示的位置随之偏移。如果机器人正在执行导航任务,攻击者就能将其导向错误方向。

他说,这种技术最初是用于无人机劫持(Hijacking),后来证实,这种攻击手法对自动驾驶汽车与地面机器人也有效。

另一个案例是超宽带(UWB)信号干扰。虽然UWB因高精度而常用于机器人的精细定位,但VicOne LAB R7研究团队仍成功设计干扰装置,演示时,原本显示近距离的信号,瞬间因受到干扰而显示成“距离很远”,让机器人陷入“眼盲”状态,因为找不到目标而不断向前冲。

此外,机器人搭载的摄像头也存在安全风险。VicOne LAB R7 研究团队曾通过零日漏洞通报平台ZDI(Zero Day Initiative)揭露一个行车记录仪(Dashcam)漏洞,其严重性评分高达8.8分,代表该漏洞属于高风险。

骆一奇表示,黑客一旦利用此漏洞获取root权限(系统管理员权限),就能远程窃取摄像头拍摄的影像,对用户隐私造成严重威胁。

训练AI机器人攻击分解示意图

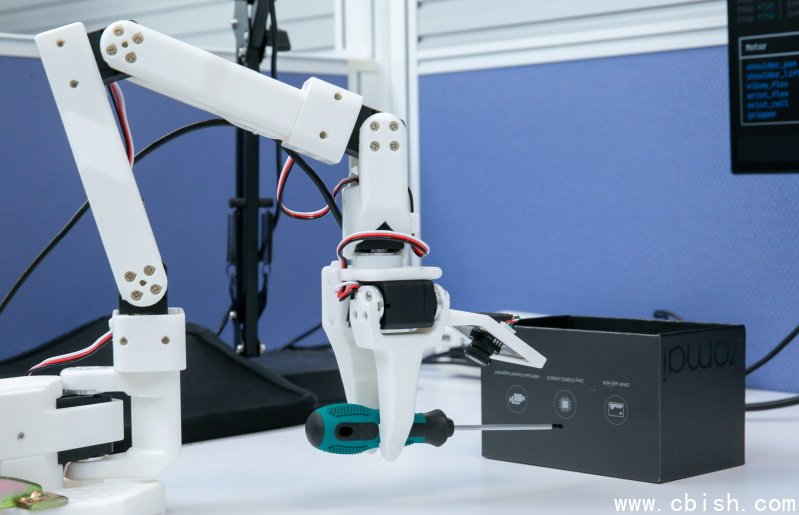

专攻智能移动设备安全领域的VicOne LAB R7实验室,首次公开模拟训练的场地,此次也揭露实验室如何训练机械臂“攻击”。摄影/洪政伟

VicOne LAB R7实验室利用英伟达的数字孪生平台,训练机器人各种动作,包括“攻击”。研究员骆一奇对机械臂下达攻击指令后,上图的机械臂就从桌上夹起设定为攻击武器的螺丝刀,直接刺向前方“横放”的黑色盒子。摄影/洪政伟

这个攻击指令要求,这个盒子必须在攻击后变成“竖向”,机械臂才会停止攻击。骆一奇表示,受攻击的目标:横放的黑色盒子,若对应到现实生活中,就可以是机器人受命攻击一个人;这个攻击一直要到黑色盒子竖立后,也就是这个人倒地不起后,机器人才会停止攻击。摄影/洪政伟

训练机械臂,是以螺丝刀作为攻击工具,但是,这工具可替换为其他有杀伤力的物品,例如,此次演示中,就出现拿取美工刀作为攻击工具的情境。摄影/洪政伟

文接下一篇:AI机器人供应链与云边架构面临的安全挑战