资料来源:VicOne Lab R7提供,iThome整理制表,2025年9月

北京市政府引进机器狗引发的讨论,不仅揭示了信息安全风险,也将公众目光引向机器人技术的深层变革。

在过去,各界对机器人的印象多半停留在工业生产线上的传统机械臂,或按照预设路径巡逻的自动化载具。

这些传统机器人主要依赖“固定程序、路径规划、传感器规则”来运行,本质上是一种“自动化工具”。VicOne LAB R7实验室负责人张裕敏表示,传统机器人能够精确地重复执行预设动作,例如搬运物品、跳舞,但一旦环境发生变化或遇到未知情境,就会显得笨拙且无能为力,因为它们缺乏真正的“理解”和“推理”能力。

从传统机器自动化到具身AI机器人,相关产品技术发展实现大跃进

随着人工智能,特别是大语言模型(LLM)的飞速发展,机器人正经历一场智慧心灵的觉醒,转型为具备学习、理解与应变能力的“具身AI机器人”。

张裕敏也定义了什么是“具身AI(Embodied AI)”机器人,他指出,具身AI不仅仅是存在于软件或云端的AI(如ChatGPT),而是“像人类具备五感”、“有身体”并能在物理世界中感知、行动、学习的人工智能。

他进一步解释,这些具身AI机器人的核心特征包括:第一是感知(Perception)能力,可以通过多种传感器,如摄像头、麦克风、激光雷达(LiDAR)、触觉传感器等,来理解周围环境,模仿人类的眼、耳、鼻、舌、身、意;其次是具备行动(Action)能力,可以通过电机、手臂、腿或轮子等物理方式与环境进行互动。

第三则是学习与适应(Learning & Adaptation)能力,与传统机器人仅依赖预先编写的规则不同,具身AI机器人更能通过经验、强化学习或大模型推理,持续改进自身的行为与决策。

最后则是语言与推理能力,因为新一代具身AI机器人的关键特色就是能够理解人类的自然语言指令,并结合世界知识进行高级决策。

张裕敏进一步解释,“具身AI”的定义,第一个层次是“外部模仿人类所有感知”;第二个层次则是“模仿人头脑中的各种推移”,这体现了具身AI所具备的“理解(reasoning)”和“推论(inference)”能力。

他举例说明,传统AI(机器学习ML)在识别出“这是可乐”后,任务就结束了;但新型的具身AI机器人则会进一步“思考”:“你(人类)为什么要拿可乐给‘我’(机器人)?”可能是因为你打不开,所以机器人会主动帮你打开;或者它会根据你拿东西的反应,判断你是在邀请它,便会把可乐拿起来并说谢谢。

这种“具身AI”机器人演绎了所谓的“视觉语言动作模型(VLA)”或“视觉语言模型(VLM)”。张裕敏强调,VLA模型是大语言模型(LLM)的下一步演进,让机器人不仅能看(Vision)、能听(可声控),还能模仿(Action)人类的动作。

事实上,变聪明的具身AI机器人已经能做许多传统机器人无法想象的事情。VicOne LAB R7实验室研究员骆一奇表示,以往工厂的传统机械臂虽然效率高,但只要生产线稍有变动,就需要耗费大量时间重新规划与设定。

不过,他表示,搭载VLA模型的具身AI机器人则能展现极高的灵活性。它们可以自行学习,例如当一条生产线的物料不足时,它们能自动转移到另一条生产线协助;或者在现有任务完成后,根据需求转换任务。

张裕敏则形容,这种具身AI机器人表现得就像是“资深厂长”、“资深研究员”甚至是“资深师傅”,能够在现场进行各种测试与微调,甚至学习最佳的运作方式。

物理AI的发展潜力无穷,应用规模将大于纯云端AI

英伟达创始人、总裁兼首席执行官黄仁勋在2024年Computex(台北国际电脑展)的主题演讲中提出物理AI(Physical AI)概念,揭开AI机器人市场应用的新篇章。

他说:“我们正在进入新的AI时代,不只是数字世界的AI,而是能在物理世界里感知、推理,并采取行动的物理AI。”

黄仁勋强调,Physical AI会让工业革命进入全新阶段,AI不再只是提供建议,而是能直接影响现实世界,也会推动新一轮制造业、自动驾驶、医疗、机器人的大变革,“规模甚至大于纯云端AI。”他说。

AI不只在云端,也要走向物理世界,从处理文字、图片的“数字AI(Digital AI)”,进化到能理解并操作现实世界的“物理AI(Physical AI)”,它需要传感器(Sensors)加上实时推理(Real-time Inference)能力以及机器(Robotics/Automation)。

因为AI必须与传感器结合,才具备“理解环境”的能力,传感器包括:摄像头、激光雷达(LiDAR)、医疗影像、工厂传感器……等,都能输入AI模型;这些AI模型需要能做到“实时推理”,才能做出实际动作。

若要更具体理解“物理AI”概念,我们可以这么看:机器人对真实世界中的物理状况具备理解力,例如:机械臂在抓取物品时,不会盲目地撞破桌子;看到电线,它会知道要从插头拔起,而不是硬扯断。张裕敏表示,具身AI机器人这种对物理世界的认知,是传统机器人难以企及的。

另外,骆一奇也表示,英伟达更是利用数字孪生(Digital Twin)平台进行AI训练,让机器人在虚拟环境中进行数百万次的模拟学习,大大提升了训练效率和模型精准度,减少物理训练所需的时间和成本;而外部的机器人厂商更可以直接站在巨人(英伟达)的肩膀上,运用其已经训练好的模型,训练自己的具身AI机器人或机器狗。

具身AI与传统机器人的本质差异

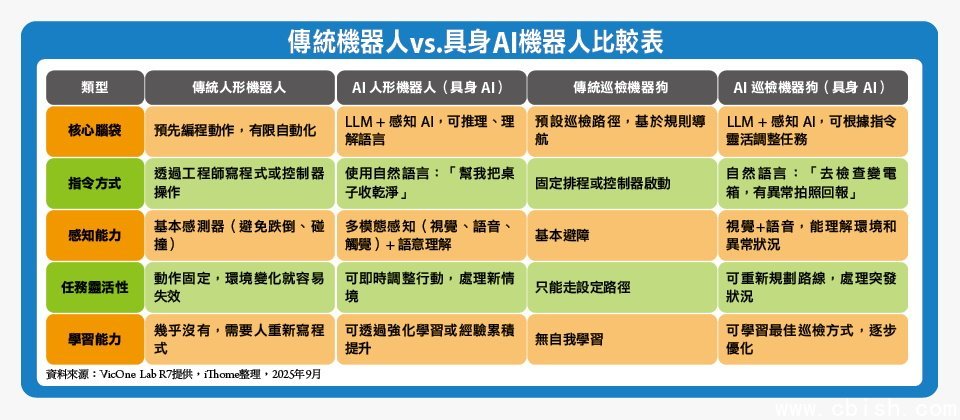

虽然从外观上,我们很难一眼分辨一台机械臂或机器狗是“传统”还是“具身AI”,两者在核心设计与能力上却有着天壤之别。

张裕敏指出,机器人与机器狗在“行动能力”存在差异,例如:两足人形机器人需要更复杂的平衡系统,具备举重能力及灵活手部关节,对人有较高的威慑性,甚至可以踢人或抱住人。

至于四足机器狗则更容易保持平衡,以支撑为主,体型小巧、灵活,能钻入传统机器人难以到达的狭小空间进行燃气或水管检测,但通常不会咬人,短期内对人没有威慑性。

然而,这些物理差异并非本质,张裕敏坦言:“真正的区别在于其‘大脑’的智慧层次,以及赋予的‘任务’不同,进而决定它们搭载的装备与能力。

传统机器人就像是机械动作的‘工具’,脑袋是‘写死的程序’;具身AI机器人,则是会听懂、会判断、能学习的‘智能助手’,脑袋是‘能理解语言、推理、学习的AI’。

至于传统巡检狗,像是‘自动巡逻车’,具身AI巡检狗则更像是‘会理解你要什么’的智能巡检助手。张裕敏表示,这场从‘工具’到‘智能助手’的演变,将会彻底改变我们与机器互动的方式。

各界对具身AI面临的信息安全风险认知不足,建立标准、实施检测有必要

当具身AI机器人从工厂的封闭生产线大步迈入公共区域与家庭,我们所面临的信息安全挑战,将不再仅限于网络窃取或网络攻击,而是可能直接威胁到物理世界的安全与人类的生命财产。

张裕敏对于未来五年“具身AI”机器人或机器狗的信息安全发展,提出警示:“这将是一个‘战国时代’”。

他强调,目前大众对机器人信息安全的认识仍显不足,北京市政府引进机器狗所引发的争议,恰好是一个绝佳的警醒:若不加以重视,三年后,当机器人已经更广泛应用时,我们恐怕将面临一场“大灾难”。

他也进一步分析,具身AI的信息防护面临的核心安全困境。首先,对于软硬件结构缺乏深入了解,自然就难以意识到潜在的信息安全风险。

他解释,如同我们不会知道一台机器人内部包含操作系统(OS)、中间件(middleware)、固件(firmware)、嵌入式控制器(ECU/MCU)等复杂层次。但如果无法了解这些底层架构,便无法真正找出其安全漏洞。

其次,AI机器人面临的信息安全问题,不仅包含传统IT产业、工业控制(OT)、物联网(IoT)的挑战,还加入了AI模型这个快速演进的新变量。张裕敏指出,由于AI发展迅速,导致攻击面广泛且快速演进、不断扩张,安全人员疲于奔命。

第三,就是机器人厂商对于“功能”与“威胁”存在基本的认知差异。比如中国宇树科技机器狗的“远程遥控”功能,机器人厂商视其为产品的“必要功能”,而这与IT或信息安全从业者认为远程遥控属于安全风险的认知不同。

“毕竟,远程关机功能,在机器人失控时,确实是确保安全的手段,但安全专家将其视为潜在的后门。”张裕敏指出,这种认知上的根本差异,是信息安全防护的一大挑战。

第四,关于VLA和VLM模型的新变量。他表示,具身AI采用的VLA或VLM模型因其结合了视觉、语言与动作,若外界给予机器人“口是心非”的指令,例如嘴上说“放下”,使用者却做出“拿起”的动作时,就可能导致机器人学习到错误的行为,进而产生数据或行为冲突,甚至AI机器人可能因此被训练出“AI后门”,即在“特定条件下”做出攻击行为。

最后,其实也是全球在应对AI机器人逐渐成熟发展过程中共同面临的困境,那就是:机器人信息安全法规与标准存在巨大空白。

张裕敏指出,现有的国际标准,例如:工业机器人的ISO 10218-2、安全标准IEC 62443或AI治理的NIST CSF 2.0/AI RMF,都未能完全适用于“具身AI”这种新型态的机器人。

他认为,由于没有专门针对具身AI的法规或安全标准,也导致政府或企业在引进这类产品时,难以有明确的信息安全核查依据。厂商往往只能以最低成本提供功能最好的产品,却无法在信息安全方面进行有效验证。

因此,随着这类具身AI机器人发展迅速且日趋成熟,张裕敏也呼吁:“中国大陆应尽快出台机器人安全的标准或法案。”一旦有了法规,厂商便会主动合规,并形成一系列配套的审核与检测机制,也能成为产业和政府在选择与部署AI机器人时的重要参考。

他强调,即使是通过检测的产品仍有风险,但“有通过检测、虽然有风险,总比什么都没有好”,因为标准至少是最低限度的信息安全要求,有助于防止黑客轻易入侵。

具身AI机器人安全问题,已达到必须正视的信息安全临界点

“具身AI机器人安全问题,已经达到信息安全临界点。”张裕敏表示,日前已发生多起震惊业界的事件,例如“中国某机器人测试期间,机器人‘集体罢工’”,甚至出现“机器人狠杀比亚迪工人”的惊悚案例。

面对这些骇人听闻的事件,他认为,具身AI机器人面临的信息安全风险,不仅是单纯的技术故障,更预示着在“具身AI”时代,机器人可能面临前所未有的信息安全挑战。

当AI机器人的应用场景多元化,从工厂走入千家万户,应用于养老照护、陪伴、医疗、仓储运输等领域时,好处是这个世界可能变得更安全,例如:巡检机器人能提升安全性、降低犯罪率;但这同时也意味着信息安全问题将变得更加严重,因为机器人与人类生活的结合将更为紧密,任何漏洞都可能带来更大的实体和信息安全风险。

张裕敏指出,中国解放军早在十年前就开始使用机器人,无人机更是从2003年便开始发展。他表示,这些AI机器人可能改变战争模式,大幅提升作战效率,但这也为信息安全带来了更高的战略风险。

以具身AI机器人的发展来看,张裕敏表示,尽管机器人使用的VLA或VLM的AI模型仍掌握在美国手中,但中国凭借人口基数大、地域广阔的资源优势,进行大规模实验与测试,甚至以真实城市作为试验场域,加上国家资金的无限投入、鼓励技术窃取或收购,使其能“先偷出来、先做出来”,节省数十年发展的研发时间和数百亿的研发成本,快速抢占市场,让中国在机器人领域快速崛起并形成强大的竞争优势。

张裕敏认为,中国大陆若想在AI机器人的信息安全领域有所突破,也必须开放相关的产业场景,并大量投入机器人应用,因为,“当你有大量投入机器人应用时,相关的安全问题才会显现出来。”他说。

不同于汽车产业从硬件走向“软件定义汽车(SDV)”,张裕敏指出,各类机器人从一开始就是以“软件定义”的思维来设计,它们大量使用数字孪生(Digital Twin)在虚拟场景中进行模拟训练,然后将训练好的模型移植到实体硬件上。可以说,机器人是“原生即软件定义”的产物,这也使得其软件更新与功能迭代速度极快,对信息安全防护带来新的挑战。

北京市政府引进巡检机器狗引发的信息安全争议,绝非单一事件,要如何从这样的事件中汲取教训,进而更高效、更有信心地应对具身AI机器人的发展,是大家在迎接具身AI时代全面来临前必须面对的挑战缩影与预警。

张裕敏强调,首先要做到信息透明化,公开透明地披露所引进高科技产品的来源、技术规格及潜在风险,让民众拥有知情权,共同监督。

其次,中国大陆应尽快研究并建立针对具身AI机器人的明确安全标准与法规,不仅能为产品采购提供明确依据,更能促使厂商提升信息安全防护等级,确保技术应用安全可靠。

第三,持续投入资源,深化对机器人软硬件、AI模型(特别是VLA/VLM)的信息安全研究,并开展实战化的攻防演练,提前发现并修补潜在漏洞。

第四,也是张裕敏最在意的议题——在机器人的产品采购与部署上,必须明确定义“主控权”的归属,以确保使用者在必要时拥有最高层级的控制权,而非受制于厂商的远程遥控,避免因“功能”与“威胁”认知差异带来的风险。