JetBrains开源其第一个针对程序码完成任务设计的语言模型Mellum,并已发布于Hugging Face平台,供研究与开发人员取用。JetBrains称Mellum为专精模型(Focal Model),其并非试图涵盖所有自然语言任务的通用模型,而是聚焦程序码理解与补全的单一应用场景,藉此在有限参数规模追求最佳的任务适应性与部署效率。

Mellum-4b-base模型具有40亿个参数,採用类似LLaMA的架构,支援8,192个token的上下文长度,并经由JetBrains团队从零开始训练,而非基于现有开源模型进行微调。其训练资料总量达4.2兆token,涵盖如The Stack、StarCoder训练集、CommitPack与英文维基百科等公开语料,针对Java、Python、C/C++、JavaScript、TypeScript、Go、Kotlin、PHP、Rust等语言进行学习,目的在于提供準确且上下文一致的程序码完成能力。

JetBrains表示,Mellum设计概念回归机器学习早期专精模型的想法,强调深度大于广度,与当前大型语言模型普遍追求多任务通用能力的趋势有别。在Mellum架构下,模型不仅在训练资源上更节省,其可部署的弹性也大幅提升,能在如llama.cpp、Ollama等环境本地执行,也可透过vLLM于云端部署。

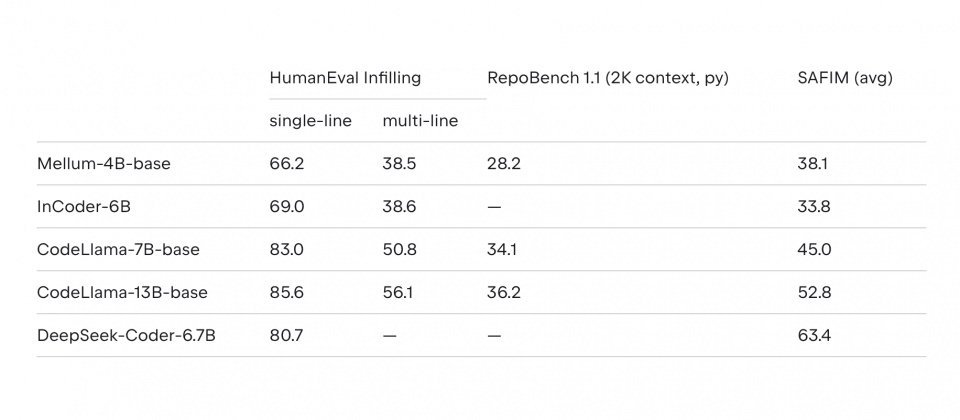

在效能表现方面,Mellum-4b-base在JetBrains内部的HumanEval Infilling测试中,单行程序码完成通过率为66.21%,多行完成为38.5%。此外,在RepoBench与SAFIM等程序码评测中,Mellum于自身支援的上下文长度範围,整体效能达到一定的水準。

虽然Mellum在效能上仍不及CodeLlama-13B或DeepSeek-Coder-6.7B等规模较大的模型,但JetBrains强调,Mellum的设计目标并非取代通用语言模型,而是适合研究训练策略、推论效率与模型专精化之用。

目前公开的Mellum版本为未经下游任务微调的基本模型,但已可支援进一步的监督式微调(SFT)与强化学习(RLHF)流程。JetBrains同时释出针对Python语言的SFT版本模型,并预告将陆续推出针对其他语言任务的模型变体,对应不同程序语言与开发场景。