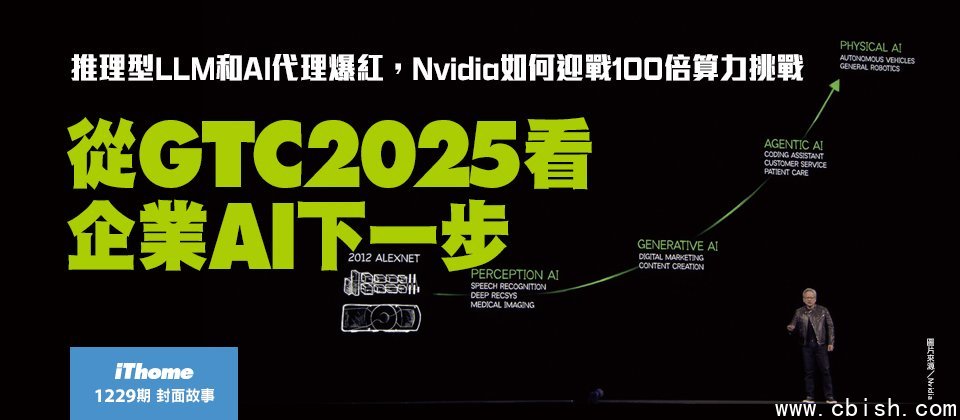

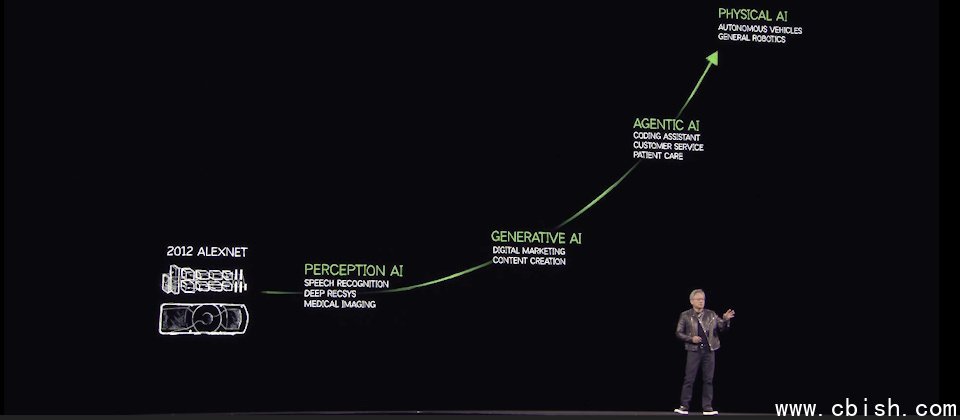

十年前是感知AI,5年前开始出现生成式AI, 最近2年,代理型AI(Agentic AI)崛起,下一波是机器人学,这是物理AI(Physical AI)驱动的新浪潮。(图片来源/Nvidia)

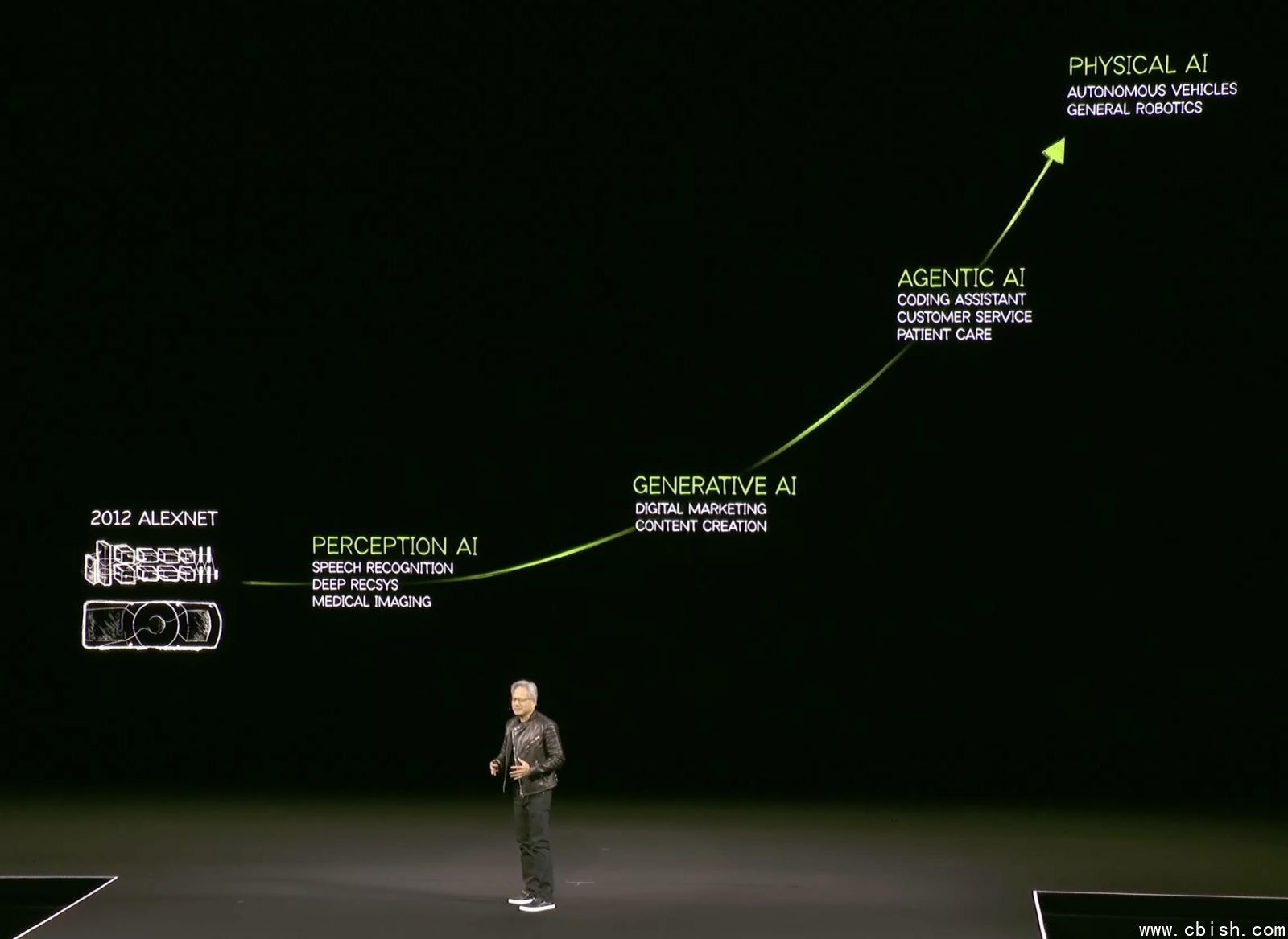

「去年,几乎全世界都错了,AI扩展定律更加飙速地成长,代理型AI和LLM推理能力的影响下,我们目前需要的算力,是去年预估需求的100倍之多!」Nvidia执行长黄仁勋在一年一度的GTC大会开场演讲中如此强调,在这场号称是AI界超级盃的活动中,黄仁勋盘点了从AI到GAI的发展,归纳出他所看到的下一个AI挑战。

从感知AI、代理AI到物理AI

AI技术十年前从感知类AI开始发展,像是电脑视觉、电脑语音,然后再进展到生成式AI的领域,过去5年的生成式AI焦点是,训练AI能将一种模态的资料,转换(生成)为另外一种模态的内容,像是文字生成图片,文字生成影音,氨基酸结构生成蛋白质结构,或从化学特性生成化学物质结构。甚至最近2年,代理型AI(Agentic AI)崛起,这是一个可以代理行动的AI,能了解上下文,来进行推理、计画再展开行动,甚至懂得使用工具蒐集新资讯,来完成任务。

「生成式AI,从根本改变了电脑运算的方式,从检索式运算,变成了生成式运算模式。」他解释,过去先产生内容,分散成多个版本,在需要的时候,找出最适合的内容版本来用。但是,现在的AI,可以从上下文了解我们想问什么,了解人类请求的意义后,产生它所知道的内容,甚至有必要,AI还能检索资讯,为人们生成答案。「生成答案取代了资料检索,这彻底改变了电脑运算的模式,全球更掀起了一场平台变革浪潮,过去是在通用处理器上执行手工开发的软件,现在转变了在GPU和加速处理器上执行机器学习应用。」

图片来源/Nvidia

黄仁勋强调:「AI下一波浪潮将是机器人学(Robotics),这是物理AI(Physical AI)驱动的新浪潮。」,物理AI指那些可以了解物理世界特性的AI,如摩擦力,惯性,物体恆定性,因果关係等,一辆车开到转角后看不见,AI可以理解这辆车仍然存在,没有消失,只是看不见。「 这些理解物理世界的AI,会带来新的物理AI时代,可以用来实现机器人技术。」

在这场AI界超级盃中,今年主轴是代理AI和物理AI。但最直接影响到企业AI未来2、3年发展的是,因推理LLM而进入爆发转折点的代理AI。

GAI发展三阶段,美银预测2027年开始爆发企业需求

GTC大会前夕,美国银行全球研究部(BofA Global Research)刚好在台举办论坛,美银超级研究部门主管Tap Liani指出,科技的应用才能创造效率,当前的AI发展,正处于基础设施建设的初期,还没看到应用程序。现在看到大型云端公司正在打造AI需要的基础设施,他们有自己的软件,可以结合ODM设备商来降低基础设施的成本,这是第一阶段。第二阶段是云端SaaS公司,他们会找到独特的方式运用AI。

不过,这位长年观察资料科技和网路安全的资深分析师强调:「第三阶段才是影响最大的阶段,可能从2027年开始,大量企业要找出适合AI的应用。」像是利用AI来创造新的收入,降低成本,寻找新顾客,寻找新的商业模式等。「第三阶段的基础建设规模,将比现在的规模还要大四到五倍。」

Tap Liani剖析,因为企业不想将自己的数据交给大型云端业者,为了将数据留在内部,必须建立自己的基础设施。未来2、3年,企业会积极开始建立边缘云,将创新和算力带到边缘环境中。从第一阶段到接下来的二、三阶段发展,「AI基础设施将是进入一个持续多年成长的发展周期。」

AI基础设施如何降低成本?必须先区分出训练和推论的不同,训练不是节省成本最多的阶段,推论才是。「AI推论更适合企业的应用,如果推论成本可以降低9成,甚至更高,将加快推论应用的部署,进而加速企业採用GAI。」Tap Liani观察。

根据黄仁勋在今年GTC演讲中揭露的数据,光是四大公云业者在2025年就订了高达360万张新一代Blackwell GPU卡,比2024年的前一代Hopper GPU订购量130万张,多了快三倍。这个数据呼应了美银超级研究部门主管的观察,当前处于第一阶段的发展,大型云端积极投入AI基础设施的建置。等到第三阶段,企业大量採用后,知名研究机构如Dell’Oro也曾预测,2028年全球AI资料中心的资本投资规模将高达1兆美元。

发展生成AI的三大难题,推论算力增加100倍

不论处于哪一个AI发展阶段,感知AI到生成式AI,推理AI或是物理AI,都要面临三个根本问题的挑战,这是基础设施投资规模暴增的原因。第一个问题是,要如何解决资料问题。因为AI是一种资料驱动的电脑科学,需要大量数位化的经验数据,才能让AI获得数位化的能力。第二个挑战课题则是如何在不需要人工介入的情况下,能够解决模型训练的问题。因为人类的时间有限,必须能够让AI用超越人类,超越即时的速度来学习,就不能有人工的介入。最后一个课题是如何扩大规模。需要找到一套演算法,让投入的资源越多,就能够让AI更聪明。

黄仁勋认为,AI资料中心的市场,将比预期更快的速度,达到1兆美元规模,因为代理型AI和推理能力需要的运算量,是去年预估需求的一百倍。

不同于两年让人惊艳的ChatGPT,当时单靠预训练资料和一次性的回答(One-shot),现在的AI可以一步步拆解问题来推理,运用像是思考链(Chain of Thought)、Best Of N方法、一致性检查、多重路径规划等不同的方法,一步一步推理。

尤其过去一年来,推理LLM成了代理AI的基础模型,这类模型透过拆解问题,一步一步解决,可以用不同方法来解一个问题,再选出最好的答案,或是用多种方法解问题,再确认答案的一致性,也可以将找到的答案,带入到方程序中来检验。代理AI运用模型推理能力给出的答案,不再是两年前惯用的一次性回答。

图片来源/Nvidia

这个改变带来的影响是,「推理产生的Token(词元)数量,比一次性回答,多了100倍以上。」因为现在出现了有能力产生10倍Token数量的複杂模型,也有10倍算力的技术,可以轻易达到100倍Token量的生成能力。

为了训练AI的推理能力,需要大量已知答案的问题来合成训练资料,提供数百类,每类上百万个的问题範例,来提供多种解法尝试的答案,需要兆级Token资料量,来训练具备这类有能力推理的模型。「这是四大公云GPU採购量特别在今年暴增的原因,这一年来AI基础架构需求大爆发,训练和推论所需的算力大大增加了。」

世界需要新的运算方法,AI工厂概念浮现

不过,通用型处理器运算的算力成长速度,有其侷限,「世界需要新的运算方法!」黄仁勋反覆强调这个观点,点出当前AI,企业AI,甚至可说是企业IT运用模式的典範转移,从「通用运算搭配手写的软件,转移到,在GPU上执行的机器学习软件。这样的转变已经通过不可逆的临界点,甚至跨过了快速发展的转折点,这是带动资料中心需求暴增的第一股推力。

另一股算力暴增的推力是对软件未来需求的投资。过去的软件执行人写的软件,但未来将有一种电脑要为软件生成Token,电脑过去从文件中检索现成的资料,现在则是用来生产各种Token。可说是从「检索运算架构」变成了「生成运算架构」,既有资料中心架构,也要转变成新的基础架构设施,黄仁勋称这个新IT基础架构设施为「AI工厂」。

「AI工厂唯一任务就是生产Token,再重组成不同类型的资讯。」他解释。黄仁勋举例,未来的製造业会有两种工厂,一间是实际生产线的工厂,另一间是生产製造资讯给生产线使用的AI工厂。像汽车工厂会需要汽车製造的AI工厂,半导体厂也需要生产製程资讯的AI工厂。像Nvidia有一套半导体巨头都在用的Cuda函式库cuLITHO,可以用GPU来加速运算半导体生产中的微影(Lithography)製程的设计图样资讯。

黄仁勋在GTC上所描绘的AI工厂,像是大型製造业才会用到的AI基础架构,但若用发电厂来思考AI工厂,不只是大型製造工厂需要电力,一般企业也需要用电,甚至遇到营运不能中断的需求下,企业还得自己準备一套备援电力或发电机。

当未来所有的应用程序,都如微软执行长Satya Nadella所说的,会成为AI化的应用,Token生产能力就会像是「用电」需求一样,成了每一家要用到AI技术的企业,需要的基础资源,也不能单靠公共电力般的公共Token供应,像是公云上的AI基础架构和服务,企业也需要有一套自己的Token设备,类似发电机般的支援不能上云的Token生产需求,像是处理高度机敏资料或法规禁止上云的资讯。

推理能力的代理AI的出现,带来了100倍的Token算力需求后,不只是大型製造业或大型公云业者,需要打造黄仁勋口中的AI工厂,就连一般企业也将会有一套小型AI工厂,来支援内部AI推论所需。

「AI和机器学习重新发明了整个运算架构。」黄仁勋解释,不只处理晶片不同、OS层不同,连AP层也不同。而且正因为AP层不一样了,调度这类AI化AP的方式也不一样,运作这类AP的方式更是不一样。「技术架构的每一层都不一样了。」他开场就强调生成式运算模式的转变,发生在技术架构的每一层。

举例来说,资料存取方式开始和过去截然不同,过去,要先精确存取到想要的资料,人们透过阅读这些资料来理解。但未来,只需对AI问问题,AI就会告诉你答案。「这是企业未来的工作方式,AI代理会成为数位工作团队的成员,未来将有上百亿个数位助手,一起和几亿人协作。」像是Nvidia工程师到今年底也会全部都使用AI来辅助开发,全球3千万名软件开发人员,未来也都将用AI辅助。

「AI代理将无所不在,如何运作,企业如何使用,人们如何运用,都会从根本上开始改变。」黄仁勋。

图片来源/Nvidia

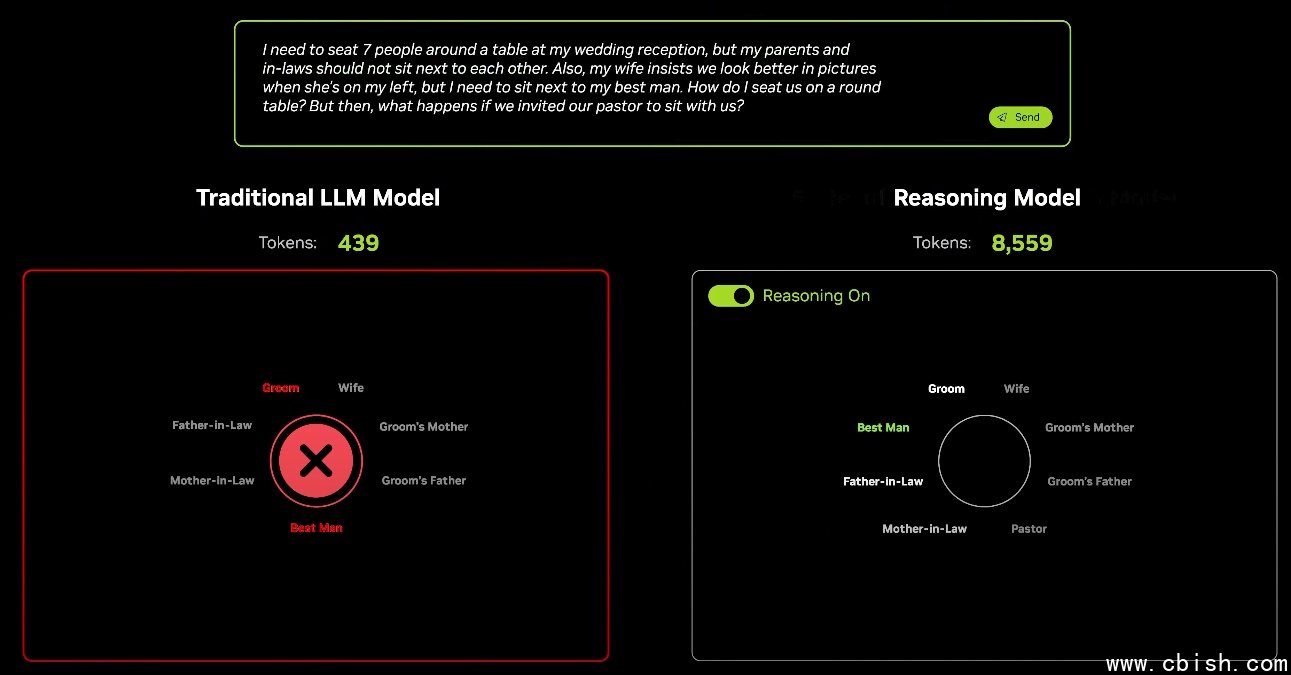

在演讲中,黄仁勋用一个如何安排婚宴主桌座位的问题,来凸显AI代理结合推论后带来的挑战。用同一个问题,同时询问传统AI和推理型模型R1,传统LLM快速(一次性回答)的推论,产生了439个Token,但回答没有符合需求,而推理型R1则花了比较长的时间推论,过程和结果共产生8,559个Token,得到了有效可用的座位安排。两者相比,推理型LLM的推论,产生的Token数多了20倍,算力需求更是多了150倍以上。「推论」的算力需求,正是黄仁勋眼中的Nvidia终极考验。(后续报导请见:瞄準代理AI的推论需求,Nvidia的两手战略)