JetBrains更新其人工智慧助理增加本地大型语言模型支援,使开发人员能够透过LM Studio直接在本地环境执行模型,扩展人工智慧助理的适用场景,并提升隐私与资料控制能力。这项更新适用于2024.3.2版本的JetBrains IDE,除了现有的云端语言模型选项,也能让使用者选择以本地运算方式操作语言模型,降低对OpenAI、Anthropic等云端服务的依赖。

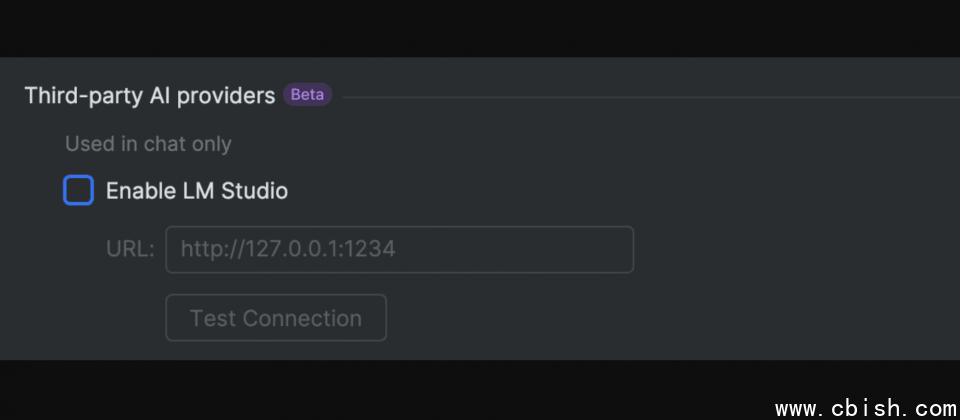

LM Studio是一款提供本地语言模型执行环境的应用程序,允许开发人员以友善的介面,下载并管理如Llama、Mistral等开源模型,并透过API连结至各种开发工具。藉由这项整合,JetBrains人工智慧助理可以利用LM Studio读取并存取本地语言模型,提供使用者在IDE内获得与云端模型类似的互动体验,但运算过程完全留存在个人电脑中,减少资料外流的风险。

除了本地模型支援,JetBrains人工智慧助理此次更新也加入了最新的云端模型,开发者现在可以使用包含Anthropic的Claude 3.5 Sonnet和Claude 3.5 Haiku,以及OpenAI的o1、o1-mini和o3-mini模型。开发人员可根据实际需求挑选模型,像是o1模型擅长更精确推理,适合解决複杂的问题,而o1-mini和o3-mini则更偏向高效运算,适用于即时回应的工作流程。

JetBrains持续扩展人工智慧助理的功能,目标是让开发者能更灵活地在本地与云端环境间切换,使得人工智慧助理不仅可提升开发效率,也能符合资料隐私与企业IT的安全需求。对于重视资料掌控与运算成本的开发团队而言,支援本地语言模型使人工智慧工具的应用更灵活,并减少对云端服务的依赖。