蚂蚁集团开源全球首个万亿参数思考模型 Ring-2.5-1T

2月13日,蚂蚁集团正式开源 Ring-2.5-1T —— 全球首个基于混合线性架构的万亿参数大模型。这不是又一个参数堆砌的“纸面模型”,而是一个真正能在复杂任务中跑得快、想得深、用得上的实用系统。它在长文本处理、数学推理、代码生成和智能体任务执行上,已经超越了当前主流开源模型,甚至在部分场景下逼近闭源顶尖模型的表现。

长文本生成快了3倍,内存占用降了10倍

过去,处理一篇50页的PDF报告、跨10个文件的代码库,或者生成一段5000字的分析文档,模型不是卡顿就是耗光显存。Ring-2.5-1T解决了这个问题。在32K以上长度的文本生成任务中,它的显存占用比上一代模型降低了10倍以上,同时生成速度提升了3倍。这意味着,你可以在普通消费级显卡(如4090)上流畅运行长文本推理,不再依赖昂贵的A100集群。

举个实际例子:如果你正在写一份商业计划书,需要整合10份行业报告、5份财务数据表和3份竞品分析,传统模型可能只能处理其中3份就爆内存,而Ring-2.5-1T能一次性读取全部内容,输出结构清晰、逻辑连贯的综合报告。

数学竞赛拿金牌,代码生成不掉链子

在IMO2025和CMO2025的模拟测试中,Ring-2.5-1T分别取得了35分(满分42)和105分(满分120)的成绩,达到国际数学奥林匹克金牌水平。这不是靠背题,而是真正在没有题库的情况下,一步步推导出解法。

在代码方面,它在LiveCodeBench-v6基准测试中表现领先,能准确理解复杂函数调用关系、跨文件变量追踪,并生成符合工程规范的完整代码。不少开发者实测后表示:“它能看懂我项目里那个三年前写的烂函数,还知道怎么改。”

不只是模型,是能“干活”的智能体

Ring-2.5-1T不是孤立的模型,它从设计之初就为“智能体”(Agent)场景优化。它能无缝对接Claude Code、OpenClaw等主流AI助理框架,支持多步任务规划、工具调用(如查数据库、调API、运行代码)、结果校验与迭代修正。

你可以让它: - 自动帮你从100份邮件中提取关键信息,生成周报; - 读取你本地的代码仓库,找出潜在的性能瓶颈并给出优化方案; - 连接你的日历、网盘和在线表格,自动整理下周行程与数据报表。 这些都不是预设脚本,而是模型自己判断、规划、执行的全过程。

架构创新:参数多,但不“笨”

Ring-2.5-1T总参数量达到1万亿,但真正“激活”参与计算的只有630亿——这个数字比Kimi K2的320亿还高,却没带来算力负担。秘诀在于它基于全新的Ling2.5架构,采用了混合线性注意力机制,让模型在处理长文本时,像人类一样“聚焦重点”,而不是把所有内容都摊开来看。

这意味着:你让它分析一本500页的书,它不会从第一页硬啃到末尾,而是快速定位关键章节,跳过冗余信息,直接抓住核心逻辑。这种效率,随着文本变长,优势越明显。

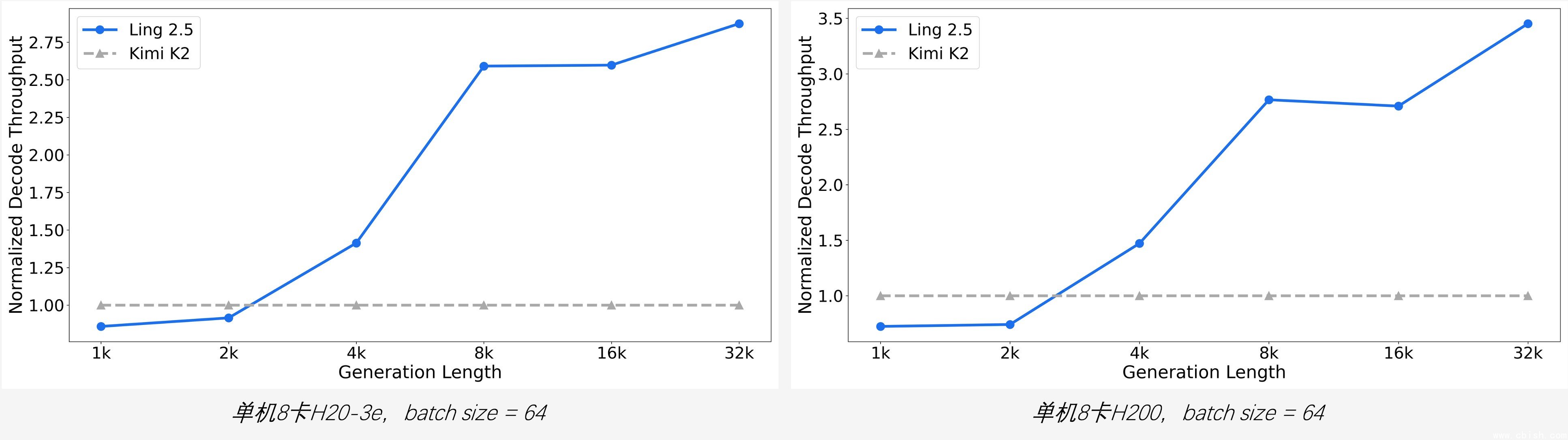

(图说:生成越长,效率优势越明显。在100K长度下,Ring-2.5-1T吞吐量是同类模型的2.8倍)

开源,不是口号,是真开放

模型权重、推理代码、部署文档,全部已在 Hugging Face 和 ModelScope 平台公开下载,无需申请,无需审核。你甚至可以把它部署在本地服务器,完全离线运行。

官方也同步开放了在线体验入口(即将上线),你可以在网页上直接输入长文本,测试它的推理能力。API服务也将在近期开放,开发者可按量付费使用,无需自建算力。

为什么这次不一样?

过去几年,我们见过太多“参数爆炸”但用不起来的模型。Ring-2.5-1T的特别之处在于:它不是为了刷榜,而是为了解决真实世界的复杂问题。蚂蚁的百灵团队花了两年时间,从训练基础设施到推理引擎,每一层都做了针对性优化。他们不是在做“AI玩具”,而是在搭建一个能支撑企业级AI应用的底层引擎。

如果你是开发者,它能帮你省下几周的代码调试时间;如果你是研究者,它能帮你处理海量文献;如果你是普通用户,它能真正帮你“思考”,而不是“复述”。

现在,这个工具,免费开放了。