小米开源首款机器人大模型,消费级显卡也能实时控制机器人

今天,小米正式开源了其第一代机器人大模型——Xiaomi-Robotics-0。这款模型参数规模为47亿,在普通游戏显卡(如RTX 4090)上就能实现流畅的实时推理,不再依赖昂贵的服务器集群。这意味着,哪怕你家里只有一台高性能PC,也能跑通一个能听懂“把桌上的杯子拿过来”这种自然指令、并真实做出动作的机器人系统。

不是“想得太多”,而是“做得更快”

传统机器人模型常常陷入“想太久、动太慢”的问题。你喊一句“帮我倒杯水”,它要思考半分钟才开始抬手——这在实际场景里根本用不了。Xiaomi-Robotics-0 的设计思路很直接:把“思考”和“动手”分开处理。

模型内部有两个核心模块:一个叫“大脑”,负责理解你的话和看懂画面——比如分辨哪个是杯子、杯子在哪、你指的是哪个;另一个叫“小脑”,专门负责把“拿杯子”这种指令,拆解成一连串精确到毫秒的电机动作。这个“小脑”用的是类似图像生成中流行的DiT结构,但做了针对性改造,让它能连续输出平滑的动作序列,而不是一卡一卡地跳。

简单说,它不是在“推理完再动”,而是在“边想边动”,动作和感知同步进行,响应速度大幅提升。

训练方式:先学道理,再练手艺

小米团队没有直接拿一堆机器人数据去喂模型,而是分了两步走:

第一步,先让模型“看懂世界”。它看了上百万条人类操作视频,配上语音指令,学会理解“拿起”“推开”“折叠”这些动作背后的意思。这一步用的是视觉语言模型(VLM),学完就冻结,不再动它。

第二步,只训练“小脑”部分。用真实机器人采集的动作数据,教它怎么把“拿杯子”翻译成具体的电机转速、关节角度变化。这一步重点不是“对不对”,而是“顺不顺”——动作要像人一样流畅,不能抖、不能卡。

最后还加了一道“真机调校”:在实际机器人上跑的时候,模型会根据摄像头实时反馈,动态调整动作。比如你突然伸手挡了一下,它不会继续按原计划执行,而是立刻停住、重新判断。这套机制叫“Clean Action Prefix + Λ-shape Attention”,听起来复杂,其实就是让机器人学会“看一眼,再动一下”,而不是闭着眼睛执行预设路线。

真机实测:拆积木、叠毛巾,样样行

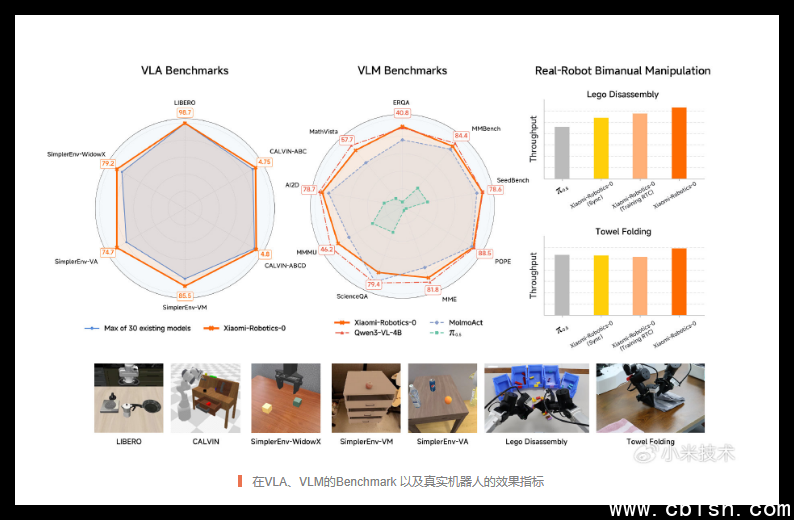

在仿真环境里,Xiaomi-Robotics-0 在 LIBERO、CALVIN 和 SimplerEnv 这三个业内公认最难的机器人任务榜单上,全部拿下第一,击败了包括Google的RT-2、Meta的RT-X在内的30多个主流模型。

但更让人意外的是,在真实双臂机器人上,它也表现得非常自然。视频里,机器人能准确抓起散落的积木,按颜色分类堆叠;也能轻轻捏住一条柔软毛巾,对折、压平,动作不拉扯、不打滑。这些动作不是靠预编程,而是完全由语言指令驱动——“把毛巾叠成四分之一大小”。

更关键的是,它能在不同结构的机器人上迁移使用,不需要重新训练。这意味着,未来你买一台国产机器人,只要接入这个模型,就能立刻学会新技能。

全开源,不设门槛

小米这次没藏私。除了发布模型,还开放了全套工具链:

- 技术主页: https://xiaomi-robotics-0.github.io —— 包含完整技术说明、视频演示和对比数据

- 开源代码: https://github.com/XiaomiRobotics/Xiaomi-Robotics-0 —— 所有训练、推理代码都已公开,支持PyTorch

- 模型权重: https://huggingface.co/XiaomiRobotics/ —— 可直接下载,本地部署

开发者可以拿它做研究、做教学,甚至自己改一改,让家里的扫地机器人学会“把拖鞋放到门口”。社区里已经有人开始尝试用它控制机械臂做咖啡、组装乐高。没有闭源限制,没有API调用费,这才是真正推动行业进步的方式。

这不是一个实验室里的Demo,而是一个能跑在你电脑上的、真正可用的机器人大脑。如果你对机器人、AI控制、人机交互感兴趣,现在就可以下载试试——它已经准备好,等你来让它动起来。