蚂蚁集团开源Ming-flash-omni2.0:一个能听、能看、能生成的全能AI模型

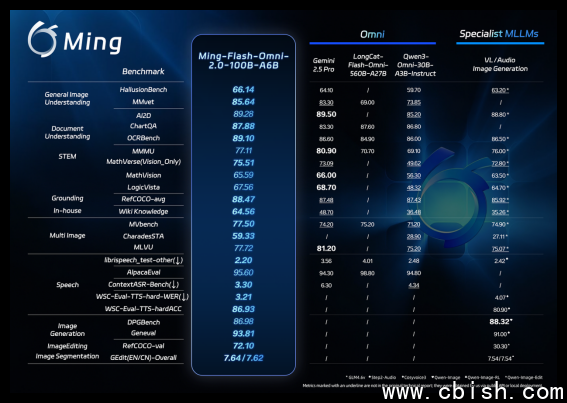

2月11日,蚂蚁集团正式开源了旗下全模态大模型 Ming-flash-omni2.0。这不是又一个“听起来很厉害”的AI模型——它能听懂你说话,看懂图片里的细节,还能在一段音频里同时生成人声、背景音乐和环境音效,全部由一句自然语言指令控制。更关键的是,它做到了开源模型里前所未有的综合表现:在视觉理解、语音生成、图像编辑等多个核心任务上,部分指标已经超越了Gemini 2.5 Pro,成为当前开源领域最强的全模态模型之一。

一段音频,三重声音:语音、音乐、环境音,一次生成

过去,想让AI生成一段包含人声、背景音乐和雨声的音频,你需要三个独立模型:一个负责语音合成,一个负责音乐生成,一个负责音效合成,再手动对齐时间轴、调音量、做混音——耗时、复杂、成本高。

Ming-flash-omni2.0打破了这个流程。你只需要说:“用温柔的女声,缓慢地念一段诗,背景是轻柔的钢琴曲,偶尔有窗外的雨滴声,情绪是安静的思念。”——它就能在一条音轨里,精准生成所有元素,连语速、音色、情绪、方言都能按你的要求调整。更惊人的是,它支持“零样本音色克隆”:你上传一段3秒的自己的声音,它就能模仿你的语气说话,不需要专门训练。

在推理效率上,它做到了3.1Hz的帧率——这意味着生成一分钟的高质量长音频,只需不到20秒。对开发者来说,这不再是“能做”,而是“能用”。

看得清细节,改得准画面:不只是“生成图”,而是“编辑图”

很多人用过AI生成图片,但很少有人能真正“编辑”它。比如:想把照片里的人换件衣服,但保留光影和背景;想让一幅古画里的灯笼亮起来,同时让阴影自然过渡;或者想把一张模糊的文物照片修复到高清状态——这些,Ming-flash-omni2.0都能做。

它在视觉理解上用了上亿张细粒度数据,训练出对“近缘物种”“工艺纹路”“稀有文物”的识别能力。比如,它能区分两种外观相似的兰花,认出宋代青瓷釉面的开片纹理,甚至看出一幅古画中被覆盖的原始笔触。在图像编辑上,支持一键修图、光影重调、人物姿态微调、场景替换,而且在动态场景(比如视频帧)中,能保持画面连贯,不会出现“鬼影”或突兀跳变。

为什么这次开源,让开发者真正兴奋?

过去,做一款多模态应用,比如智能客服、AI配音助手、互动教育产品,你得串联多个模型:用CLIP看图,用Whisper听音,用Stable Diffusion作图,用VITS生成语音……每个模型都要单独部署、调参、对齐时间戳,开发成本高得吓人。

Ming-flash-omni2.0把这一切打包成一个统一入口。你不再需要“拼积木”,而是直接用一套代码,调用视觉、语音、文本、图像生成的全部能力。这对创业团队、独立开发者、教育科技公司来说,意味着从“三个月开发周期”缩短到“一周上线”。

目前,模型权重和推理代码已上线Hugging Face,任何人都可以下载使用。同时,蚂蚁也开放了在线体验平台“Ling Studio”,无需注册,直接输入文字或上传图片,就能实时看到效果——你甚至可以用它给短视频配乐、给老照片上色、为儿童故事生成专属配音。

这不是终点,而是起点

蚂蚁百灵团队负责人周俊说:“我们不是要造一个‘万能AI’,而是想让AI真正理解人类的表达方式。”

过去几年,Ming-omni系列经历了三次迭代:从构建统一架构,到验证规模效应,再到如今的“精准控制+高效生成”。这次2.0版本,不是靠堆参数,而是靠数据质量、训练策略和系统优化,把能力拉到了新高度。

下一步,团队计划优化视频时序理解(比如让AI看懂一段10分钟的视频并准确总结关键动作),提升复杂图像编辑的稳定性(比如同时改多人物、多物体),并进一步压缩长音频生成延迟——目标是让“实时语音+实时画面”互动成为可能,比如直播中AI实时根据主播情绪调整背景音乐和字幕风格。

现在,你可以在Hugging Face下载模型,也可以直接访问Ling Studio体验:https://lingstudio.antgroup.com

这不是实验室里的Demo,而是一个已经能用、能跑、能落地的工具。如果你在做内容创作、教育产品、智能硬件、无障碍辅助,它可能正是你等了三年的那个“答案”。

(图说:Ming-flash-omni2.0在视觉语言理解、语音可控生成、图像生成与编辑等核心领域实测表现均已达到开源领先水准)