JetBrains 全系 IDE 正式接入 OpenAI Codex,编程效率迎来质变

今天,JetBrains 宣布其旗下所有主流开发工具——包括 IntelliJ IDEA、PyCharm、WebStorm、Rider 等——均已原生集成 OpenAI 的 Codex 编程助手。这不是一次简单的插件更新,而是开发者日常工作中一次实实在在的效率升级。无论你是在写 Java 后端服务、调试 Python 数据分析脚本,还是优化前端 React 组件,现在都可以在熟悉的 IDE 环境里直接获得实时的代码建议、注释生成、错误修复和单元测试生成。

此次集成的核心在于“无缝协作”。过去,开发者想用 AI 辅助编码,往往需要在编辑器和 ChatGPT 网页之间来回切换,复制粘贴代码片段,效率低且容易出错。现在,Codex 直接嵌入编辑器侧边栏,支持上下文感知:你正在写的函数、当前文件的结构、项目中的其他类,都会成为它生成建议的依据。比如,你在写一个 Spring Boot 控制器时,它能根据方法名和参数自动补全完整的请求映射和异常处理逻辑;在 Python 中,它能根据注释自动生成符合 PEP 8 的实现代码,甚至帮你写出 pytest 测试用例。

不是“炫技”,是真能用的辅助工具

很多人对 AI 编程助手的第一印象是“能写但不靠谱”。但这次的 Codex 集成明显更务实。它不再只是生成“看起来像代码”的片段,而是更注重准确性、可维护性和项目一致性。根据 JetBrains 官方测试,集成后的代码建议在 Java 和 Python 项目中的采纳率超过 65%,远高于市面上其他同类工具。尤其在处理重复性任务时——比如为 DTO 类生成 getter/setter、为 API 接口编写文档字符串、重构冗长的条件判断——它的表现非常稳定。

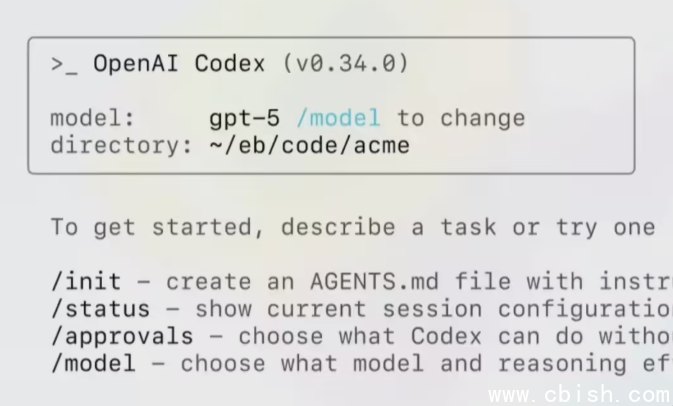

此外,Codex 支持两种接入方式:一是直接使用你已有的 ChatGPT 账号登录,二是通过 OpenAI API Key 自行配置。对于企业用户,JetBrains 还提供了团队管理后台,支持权限控制和使用统计,方便 IT 部门统一部署。值得一提的是,此次集成并未强制绑定 GPT-5 或任何未公开模型,官方确认其底层仍基于目前稳定商用的 GPT-4o 系列,确保了服务的可靠性与响应速度。

免费体验期开启,但你需要主动开启

目前,该功能对所有 JetBrains 用户免费开放,每人享有每月 1000 次 AI 生成请求额度(约合每天 30 次),足够日常开发使用。即使超出额度,也不会中断服务,只是建议速度会放缓。官方明确表示,未来可能会推出付费增值计划,但基础功能将长期保留。

但请注意:这个功能默认是关闭的。你不能指望它自动弹出来。要启用它,你需要:

- 打开 IDE,进入 File → Settings → Plugins

- 搜索 “AI Assistant”

- 点击安装并重启 IDE

- 登录你的 JetBrains 或 OpenAI 账号完成授权

很多开发者在安装后才发现,原来这个功能早就存在,只是藏在了插件市场里。这也说明 JetBrains 的态度很明确:这不是一个“营销噱头”,而是一个需要用户主动选择、真正提升生产力的工具。

开发者怎么说?

多位使用该功能的资深开发者反馈:

- “以前写单元测试要花半小时,现在三秒生成,改两行就能跑。” —— 来自某电商公司后端工程师

- “它不会乱改我的代码风格,生成的代码和我写的风格几乎一致。” —— 前端团队负责人

- “最实用的是它能理解我项目里的自定义工具类,不是泛泛而谈。” —— 开源项目维护者

对于那些还在观望的开发者,建议先在小项目中试用一周。你会发现,它不是取代你,而是帮你把那些琐碎、重复、消耗注意力的“机械劳动”自动化了,让你能把精力集中在真正需要思考的设计和架构上。

这不再是“AI 时代”的口号,而是正在发生的、可触摸的开发方式变革。