AI连六岁孩子都不如?一场颠覆认知的视觉测试曝光

当AI在国际奥赛、编程挑战和论文写作中频频击败人类专家时,我们很容易相信:人工智能已经全面超越人类。但最近一项由UniPat AI、xbench、阿里、月之暗面与阶跃星辰联合发起的实验,却把这种自信打得粉碎。

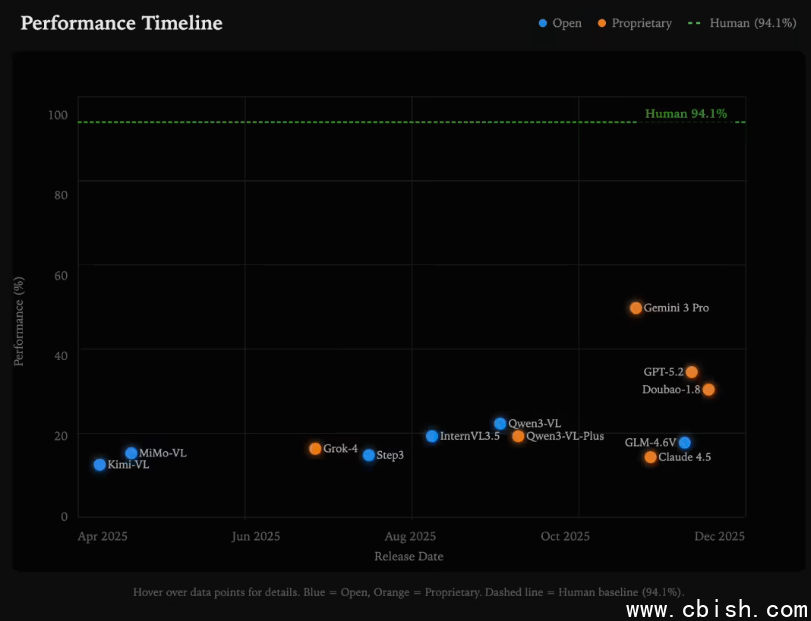

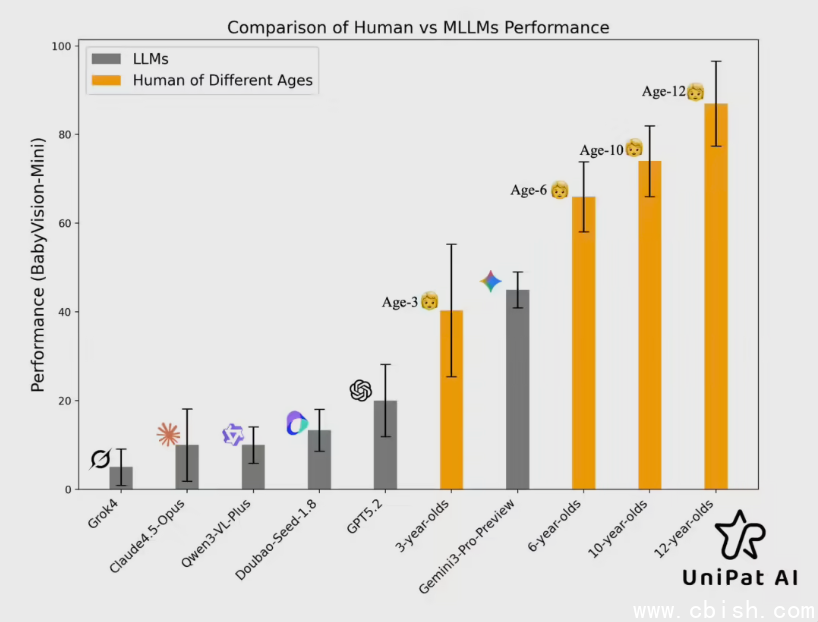

他们设计了一套名为“BabyVision”的视觉推理测试,题目全部来自3至6岁儿童的认知发展标准:找不同、拼图配对、积木投影判断、轨迹追踪……这些我们小时候玩得烂熟的游戏,成了AI的“噩梦”。结果显示,即便是当前最顶尖的Gemini 3 Pro Preview,其表现也只勉强超过3岁幼儿,面对6岁孩子的任务,准确率直接跌了20%——相当于一个大学生做小学二年级数学题,错了一半。

为什么AI看不懂“简单”的图?

你可能以为,AI看图是靠“眼睛”——其实它没有眼睛。它靠的是文字。

当一张图片输入AI系统,它不会像人一样“一眼看出”两个积木的旋转关系,而是先用语言模型把图像转成一段描述:“左边是红色立方体,右边是蓝色长方体,中间有阴影……”然后基于这段文字做推理。这就像让一个盲人通过别人口述来拼乐高——哪怕描述再详细,也难免漏掉指尖能感受到的微小凹凸、角度的微妙偏差。

这种“语言中转”机制,在处理抽象概念时还能撑住场面,可一旦遇到真实世界的物理细节——比如一个旋转了15度的三角形、一条被部分遮挡的曲线、或者三块叠在一起的积木哪一层在最底下——AI就彻底懵了。

AI在儿童测试中翻车的四大硬伤

研究团队把AI的失败归纳为四个真实世界中人人都会的“基本能力”,而AI一个都没掌握:

- 看不清细节:拼图里多出0.5毫米的边角,人类一眼发现,AI却说“看起来一样”。

- 记不住路径:让你跟着一条蜿蜒的线从A走到B,人不会走错,AI一遇到交叉口就“断片”,像没带地图的游客。

- 想象不出立体:给一张积木的正面图,问侧面长什么样?AI经常数错层数,甚至把隐藏的块当成不存在。

- 学不会规律:你给它看三个例子,它就能总结出“颜色交替”的模式,人类小孩做得到,AI却只会死记“红蓝红”,遇到“红蓝绿”就乱套。

具身智能的现实困境:机器人连玩具都不会玩

这项研究之所以引爆行业,是因为它戳中了当前最热赛道——具身智能(Embodied AI)的软肋。

我们总听说“AI机器人将协助老人、照顾孩子、驾驶汽车”,但如果你的AI连孩子玩的拼图都搞不定,它怎么知道你递过来的杯子是满的还是空的?怎么判断楼梯台阶的高度是否安全?怎么避开地上的电线?

2024年,OpenAI的Sora、Google的Gemini 2.0、Meta的Llama 3等模型都在强调“多模态”,但大多数仍停留在“看图说话”层面:能描述图中有什么,但不能理解“为什么”。真正的视觉智能,不是“认出猫”,而是“知道猫跳上沙发时,沙发会下陷多少”。

出路在哪?不是更大数据,而是更像孩子

研究人员提出两条可能的突破方向:

一是让AI“动手试错”——通过强化学习,在虚拟环境中反复操作物体,像孩子一样靠经验积累空间直觉。MIT和DeepMind在2023年的实验已证明,让AI在模拟器中玩积木300小时后,其空间推理能力提升近40%。

二是彻底抛弃“语言翻译”模式,直接让模型在像素层面做推理。就像Sora能直接生成视频,未来的AI或许需要学会“在脑子里画图”——不是描述图,而是像人类大脑的视觉皮层那样,直接处理光影、形状、运动的原始信号。

这就像教一个只会读字的人学开车,和直接教他感受油门、方向盘、轮胎打滑的物理反馈——后者才是真正的驾驶。

真正的AI革命,藏在儿童玩具里

我们总以为AGI(通用人工智能)的钥匙在数学公式、在千亿参数、在超算集群。但这场测试告诉我们:它可能藏在幼儿园的拼图盒里。

一个三岁孩子能用手指拼出一辆车,是因为他有身体、有触觉、有试错、有反复观察。而AI没有手,没有痛感,没有童年。

也许,通往真正智能的道路,不是让AI变得更“聪明”,而是让它变得更“像人”——从看懂一张图开始,从玩一次拼图开始。

下次你看到孩子专注地摆弄积木时,别急着催他。他正在做的,可能是人类历史上最复杂的AI训练课。