微信团队推出新语言模型 WeDLM,推理速度提升数倍

腾讯微信 AI 团队近日发布了名为 WeDLM(WeChat Diffusion Language Model)的新一代语言模型。它不是又一个“更强更大”的模型,而是一次对生成方式的根本重构——用扩散模型的思路,干出了自回归模型做不到的事:快,还稳。

为什么快?关键在“拓扑重排”

传统模型(比如 GPT、Qwen)生成文字是一步一步往前推,像写日记一样,每写一个字都要等前一个字完成。这种“因果顺序”虽然可靠,但太慢,尤其在长文本、复杂推理场景下,延迟明显。

WeDLM 没有走这条路。它借鉴了图像生成中扩散模型的思路,但做了一个关键改造:把原本“双向看上下文”的注意力结构,重新排列成一种能和 KV 缓存兼容的形式。简单说,就是让模型在并行计算时,依然能保持语言的逻辑连贯性——这在以前被认为是“不可能的任务”。

结果是:不再需要等前一个词生成完才能算下一个,多个词可以一起算。这就像从单车道排队过收费站,变成了多通道自助闸机。

实测:数学题快3倍,计数任务快10倍

不是吹,是实测数据:

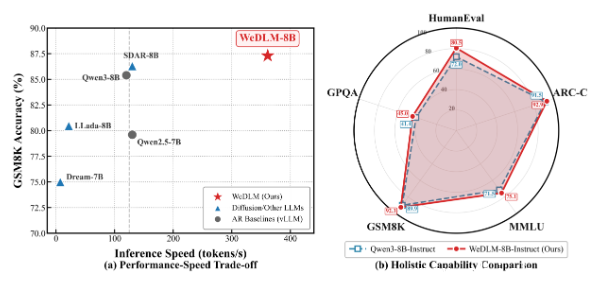

- 在数学推理数据集 GSM8K 上,WeDLM-8B 比优化过的 Qwen3-8B 快了近3倍,同样一个奥数题,别人还在算,它已经出答案了。

- 在需要精确计数的低熵任务中(比如“这段文字里有多少个‘的’”),速度提升超过10倍——这在客服自动回复、代码补全这类高频短任务里,体验差异直接能感知。

更重要的是,它没因为快而牺牲质量。在 ARC、MMLU、Hellaswag 等通用能力测试中,WeDLM 的准确率和主流模型持平,甚至在部分题目上还略优。这意味着它不是“速通型”模型,而是真能打。

谁最受益?客服、开发者、普通用户

这模型不是实验室玩具,它瞄准的是真实场景:

- 智能客服:用户问“我上个月的账单里有几笔退款?”,响应从1.5秒降到0.3秒,体验直接升级。

- 代码辅助:VS Code 插件里补全一行函数,不再有“卡顿感”,写代码更顺手。

- 实时问答:手机上的语音助手、AI 陪聊,响应更跟得上节奏,不“答非所问”也不“慢半拍”。

对平台来说,同样的算力,能服务更多人;对用户来说,AI 不再是“慢半拍的机器人”,而是像人一样反应自然。

开源了,谁都能试

WeDLM 已在 GitHub 全部开源,代码、模型权重、训练细节一应俱全。没有隐藏门槛,没有商业授权限制。

项目地址:https://github.com/tencent/WeDLM

如果你是开发者,想试试“快到离谱”的语言模型;如果你是产品经理,想优化对话延迟;或者你只是好奇——这回微信到底做了什么不一样的东西?现在就可以下载跑一跑。没有“AI味”的宣传,只有实打实的速度提升。