xAI发布Grok 4 Fast:支持200万Token上下文,成本降低98%

xAI上周五(9/19)发布了Grok 4 Fast,这是基于Grok 4推出的新模型,首次采用统一架构,可在快速响应与长链推理之间自由切换,并支持高达200万个Token的上下文长度。Grok 4 Fast在性能上接近Grok 4,但成本大幅降低98%。

今年5月推出的轻量版模型Grok 3 Mini源自Grok 3,仅支持12.8万个Token的上下文长度;而今年7月发布的旗舰模型Grok 4同样支持200万个Token的上下文长度。

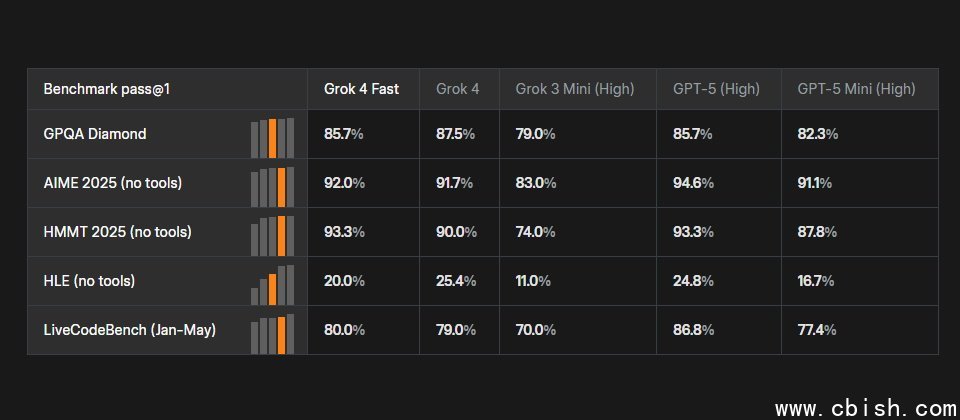

在衡量跨学科研究生级别问题的GPQA基准测试中,Grok 3 Mini得分为79%,Grok 4 Fast为85.7%,Grok 4为87.5%;在基于高中数学竞赛的AIME基准测试中,Grok 3 Mini得分为83%,Grok 4 Fast为92%,Grok 4为91.7%。

xAI表示,以往推理模式(长链思考)与非推理模式(快速响应)通常需要不同的模型,但Grok 4 Fast采用了统一架构,使同一组模型参数能够同时满足两种需求,并可通过系统提示调整模型行为,从而降低端到端延迟并减少Token消耗。

由于xAI使用大规模强化学习来最大化Grok 4 Fast的智能密度,该模型在基准测试中实现了与Grok 4相当的表现,但平均使用的Token数量减少了40%。此外,Grok 4 Fast每百万输入/输出Token的费用为0.2/0.5美元,而Grok 4为3/15美元,因此xAI宣称其使用成本较Grok 4下降了98%。

普通用户可通过Grok官网及移动应用访问Grok 4 Fast,目前免费用户也可使用;开发者则可通过xAI API、第三方平台OpenRouter或Vercel AI Gateway调用该模型的推理端点或快速端点。