图示说明语言模型在判断生成内容正确性时的差异,拼字任务可稳定学习,计数容易出错,生日等随机事实则无规律可循,因而常产生幻觉。

OpenAI在最新研究中指出,大型语言模型频繁出现幻觉(Hallucination),主要原因是当前评测(Evaluation)与训练机制设计不当,使得模型在不确定时更倾向于猜测而非承认不知道。研究指出,当主流评测榜单只看答对率时,模型在不确定的情况下更倾向于猜测而非坦承不知道,最终以更高的自信错误(Confident Error)率换取更漂亮的分数。

OpenAI主张,评测应对自信错误的回答给予更重的惩罚,并对适当的不确定表达给予部分分数,以纠正模型在不确定时倾向于乱猜的行为。

OpenAI将幻觉定义为看似可信但不正确的回答。研究团队以实际案例说明其普遍性,例如询问作者Adam Tauman Kalai的论文题名或生日,当前聊天机器人能给出多个且互相矛盾的答案。这类错误在当前只计算准确率的评测中并未被完整反映,因为猜中一次即可提高分数,而诚实回应的“我不确定”则保证得零分。

这就像选择题的答题策略,面对不知道的问题,盲猜仍有答对的可能,而留空则一定得零分。如果一个模型在数千道题中始终选择猜测,最终可能比懂得在不确定时放弃作答的模型获得更高的准确率,但伴随更多错误。

OpenAI在GPT5系统说明卡中以SimpleQA呈现这一矛盾:gpt-5-thinking-mini的弃答率为52%,准确率为22%,错误率为26%;相比之下,OpenAI o4-mini的弃答率仅1%,准确率为24%,但错误率高达75%。如果仅看准确率,o4-mini略胜一筹,但从自信错误率来看,gpt-5-thinking-mini明显更低。这意味着在只注重准确率的基准测试榜单中,偏好猜测的模型可能排名更靠前,但在实际使用中更容易产生幻觉。

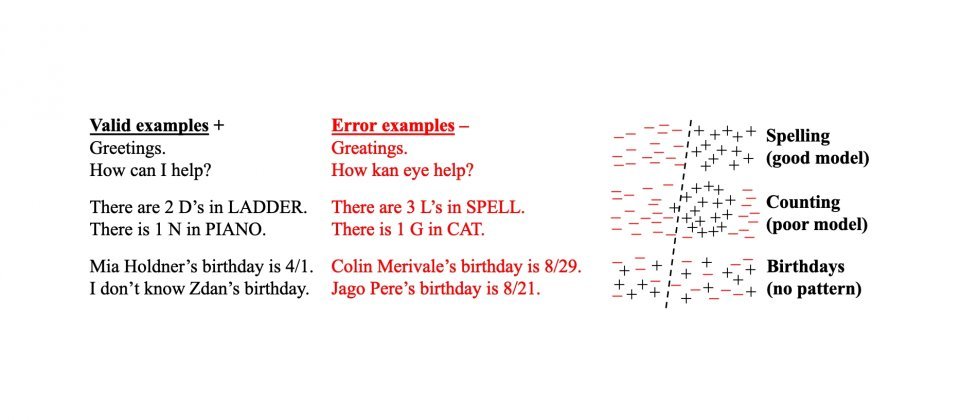

研究也从训练机制角度解释了幻觉的来源:大型语言模型在预训练阶段通过预测下一个字词进行学习,观察到的大多是流畅语句的正例,缺乏明确标记为错误的反例。对于规则明确的任务,例如拼写或括号匹配,模型能随着规模和数据量的增加学到稳定模式,错误率自然下降;但像某人生日这类低频且随机性强的事实,无法从语料分布中可靠推断,因此始终存在一个无法完全消除的最低错误率。

OpenAI提出的解决方案侧重于改变评测与计分机制。研究人员建议将主要评测指标改为同时考虑准确、错误与弃答,将自信但错误的回答视为比弃答更严重的问题,并对恰当的不确定表达给予部分积分。这种对错误给予负分、对不确定回应给予部分分数的方式并非新概念,一些标准化考试早已采用类似设计,学术界也已提出校准与不确定性导向的评测方法。不过OpenAI指出,如果只在少数评测中加入允许不确定性的设计,仍不足以改变当前主流榜单只看准确率高低的排序方式。

该研究得出了几项重要结论:其一,单靠提升准确率无法彻底消除幻觉,因为真实任务中总存在无法回答或需要澄清的问题,使准确率难以达到100%;其二,幻觉并非不可避免,模型可以在不确定时选择弃答;其三,避免幻觉并不一定依赖更大的模型,小模型在明显超出能力范围时更容易说出“不知道”,而良好校准所需的计算资源未必比高准确率模型更高。

OpenAI最新模型在推理场景中的幻觉率相较以往已有所降低,但问题仍未完全解决。