图片来源:

图片来源: Hugging Face

继4月份公布可在装置上执行的小语言模型OpenELM后,苹果本周又公布了14亿及70亿参数的DCLM模型,号称效能不输竞争模型如Llama 3、Gemma或Mistral,或是更节省训练运算资源。

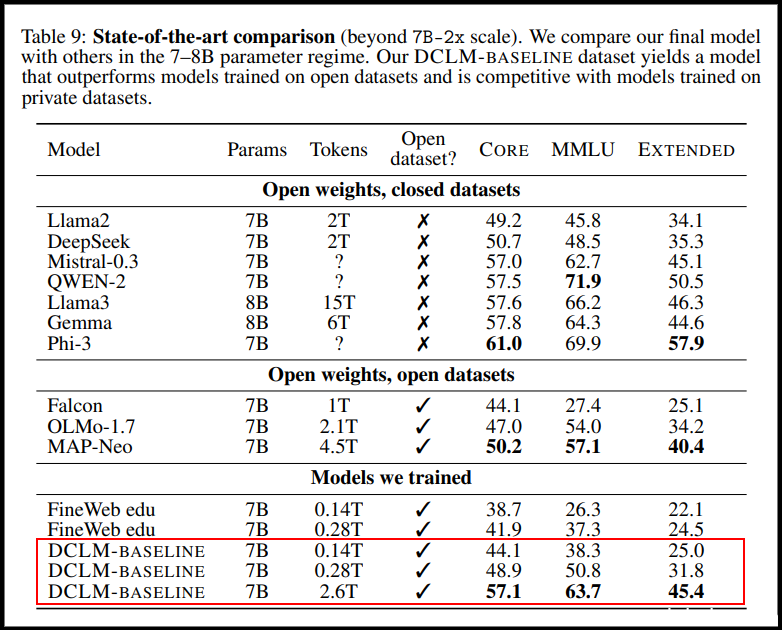

这二款模型是由苹果DataComp for Language Models(DCLM)团队开发,并在Hugging Face平台上公布。Venturebeat报导,DataComp专案成员来自苹果、华盛顿大学、以色列台拉维夫大学及丰田研究院。第一款为DCLM-7B,是69亿参数的模型,以2.6兆字符(token)资料训练而成。苹果指出,和State of the Art(SoTA)模型如Mistral、Llama 3、Gemma、阿里巴巴Qwen-2、微软Phi-3及开源模型MAP-Neo相比,DCLM-7B在多语理解测试MMLU中,最后的成果和Map-Neo相较效能相同,但运算资源耗损少40%。和私有模型相较,DCLM-7B準确性得分(64%)和Mistral-7B-v0.3(63%)及Google Gemma(64%)相比差不多,比起Llama 3-8B(66%)略低,但苹果说,其模型耗能低了6.6倍。

图片来源/arXiv:2406.11794

第二款DCLM-1B模型参数量为14亿。苹果宣称,在Alpaca bench测试中,效能优于Hugging Face上周公布的小模型SmolLM。

苹果最后将DCLM模型框架、高品质训练资料集DCLM-BASELINE以及预训练方法,都开源公布在https://datacomp.ai/dclm专案网站。