图片来源:

图片来源: OpenAI

在微软、Google、Meta之后,OpenAI也搭上小语言模型列车,推出多模态AI模型GPT-4o mini,强调低成本,且比Claude Haiku、Gemini 1.5 Flash其他小模型理解能力更高,目前可支援文字和视觉,未来还会再加入影片与声音支援。

OpenAI指出,GPT-4o mini是该公司最具成本效益的小模型,低成本及低延迟性等优点,预期它可扩大AI应用广度和使用普及。OpenAI并未公布GPT-4o mini的参数量。该公司对Techcrunch表示,其参数量和主要小模型如Llama 3.8B、Claude Haiku和Gemini 1.5 Flash差不多。

目前已知,GPT-4o具备128K字符的context window,一次呼叫支援最多16K输出字符,其训练资料集已更新到2023年10月。由于与GPT-4o使用同样的tokenizer,这小模型处理非英文文字的成本效益会再更提升。

虽然号称多模态支援,但目前GPT-4o mini仅在API支援文字和视觉,未来才会加入多模态能力,支援文字、图片、影音输入/输出功能。GPT-4o mini现在可透过Assistants API、Chat Completions API及Batch API提供文字和视觉模型。收费方面,每100万(大约是一本2,500页的书)输入字符费用为15美分,每100万输出字符为60美分。OpenAI计画未来几天内,就会推出GPT-4o mini微调功能。

ChatGPT免费版、Plus、Team方案用户今天起可存取GPT-4o mini,取代GPT-3.5。下周Enterprise方案用户也可开始存取。

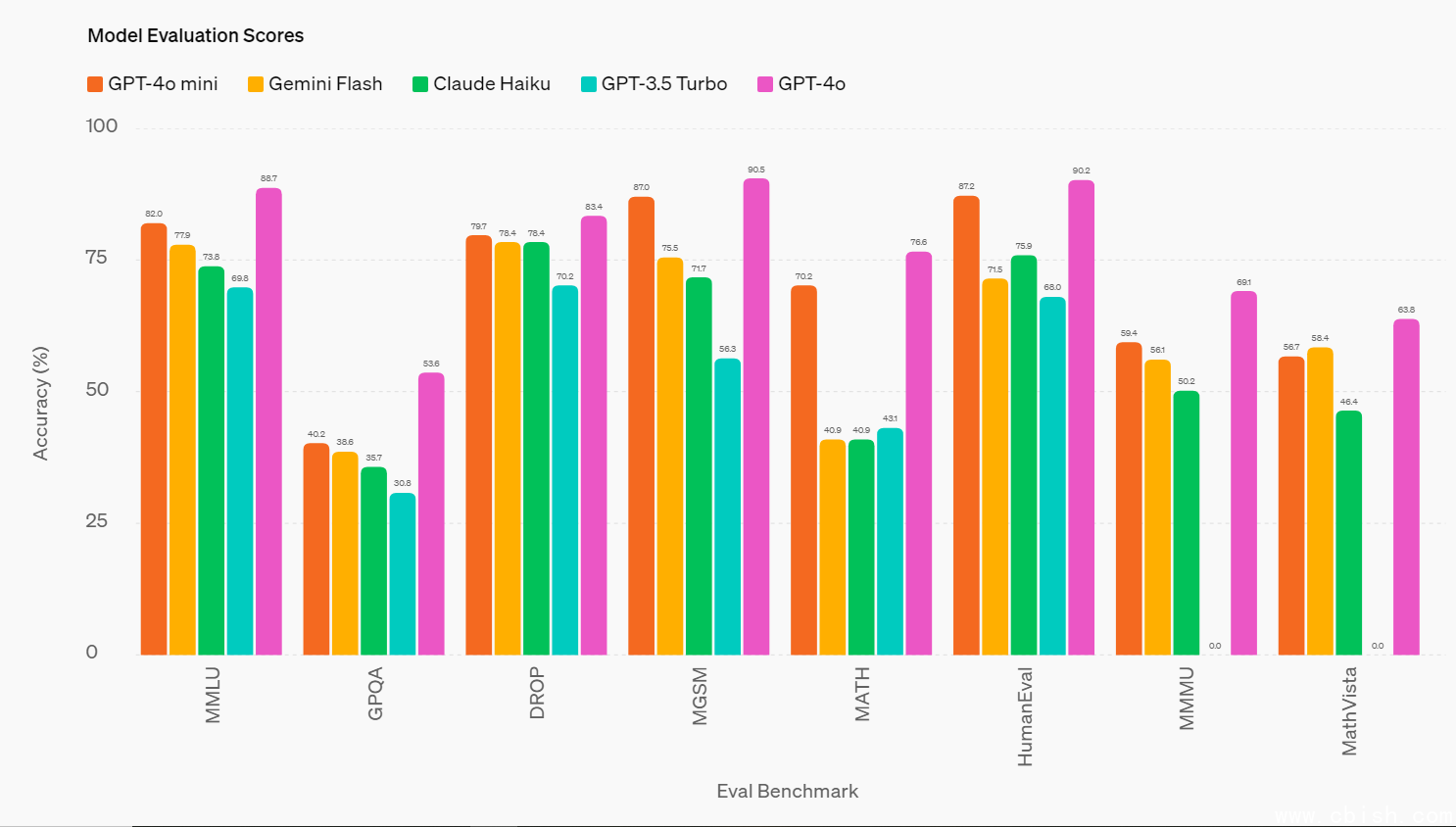

现有能力上,GPT-4o mini在文字智慧及多模态理解能力,已超越GPT-3.5 Turbo及其他小模型。例如在文字与视觉理解任务上,GPT-4o mini在MMLU测试中得分82.0%,超过Gemini Flash的77.9%和Claude Haiku的73.8%。在数学与程序任务上,它在MGSM测试中拿到87.0%,在写程序效能的HumanEval测试中拿到87.2%,都超越Gemini Flash(75.5%/71.5%)及Claude Haiku(71.7%/75.9%)。此外,在多模态理解的MMMU测试中,GPT-4o mini也以59.4%击败对手(Gemini Flash 56.1%;Claude Haiku 50.2%)。

图片来源/OpenAI

GPT-4o mini也展现强大的函式呼叫能力,能协助开发人员建立捞资料,和外部系统串联以採取行动的应用程序,其长脉络效能也优于GPT-3.5 Turbo。OpenAI举例,这小模型能支援串联或平行执行多个模型呼叫动作(如呼叫多个API)、将大量脉络资讯传送给模型(如完整的code base或对话纪录),或是以快速、即时回应(如客户支援聊天机器人)和客户互动。

目前OpenAI已和第三方应用开发商合作测试GPT-4o mini,包括帐单管理App Ramp及智慧化电子邮件App Superhuman等。

OpenAI也不忘强调为GPT-4o mini加入的安全防护。包括从预训练的资料去除仇恨、暴力、成人内容,以及个资。后训练中则以强化式学习搭配人员回馈提升模型回应的可信度与準确性。这模型也具备和GPT-4o同样的安全机制,也找来了专家团队测试。

OpenAI说,和2022年的text-davinci-003相较,每字符(token)成本已经降低99%,该公司也致力于未来持续降低成本同时提升模型能力。