图片来源:

图片来源:

Meta

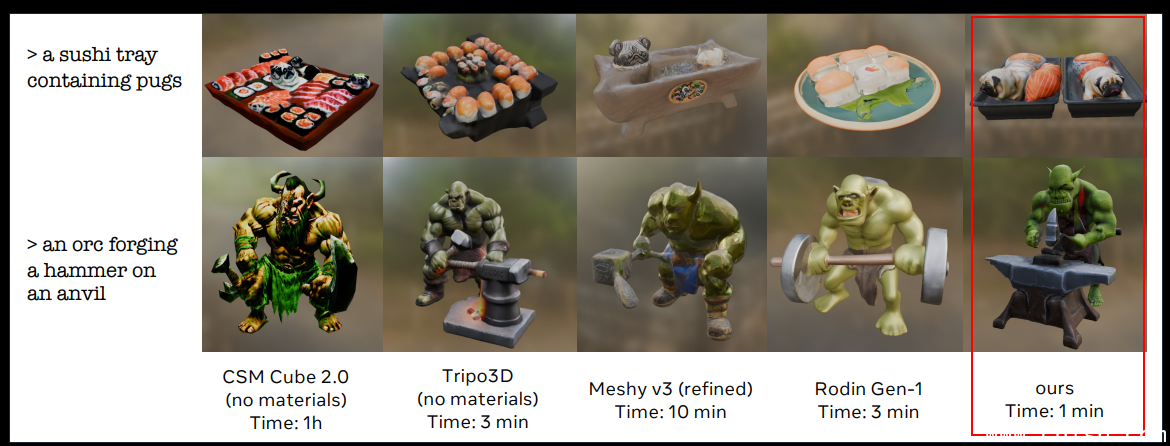

Meta本周公布一个可让用户输入文字1分钟就可以产生高品质3D物件的AI模型Meta 3D Gen,号称速度是别人的3到10倍。

Meta说明,3D Gen能在不到1分钟内根据用户文字输入,生成高度符合提示需求,具备高品质3D形状和文字的资产。这新模型支援3D影像应用在为3D物件打光时,必要的实体渲染(physically-based rendering,PBR),也能将之前AI生成或人类创作的3D物件,根据用户文字提示加以强化纹理(retexture)。

从技术面而言,3DGen结合了2个阶段的2个模型,包括文字转文字(text-to-text)技术3D TextGen,以及文字转3D(text-to-3D)技术3D AssetGen。透过结合这二种能力,3DGen可同时以3种方式表达物件,包括视觉空间、体积空间及UV(或纹理)空间。

Meta指出,3D Gen整合2阶段生成及结合各自表达(representation)结果。在其测试中,个别阶段的模型优于竞争模型;AssetGen凭藉其RBR能力能生成更佳的3D形状,它发展出的新神经网路可有效在单一纹理中整合视觉(view-based)资讯。另一方面,TextGen则发展端对端的网络,可在视觉和UV混合空间运作,纹理产出效能也超越之前模型。

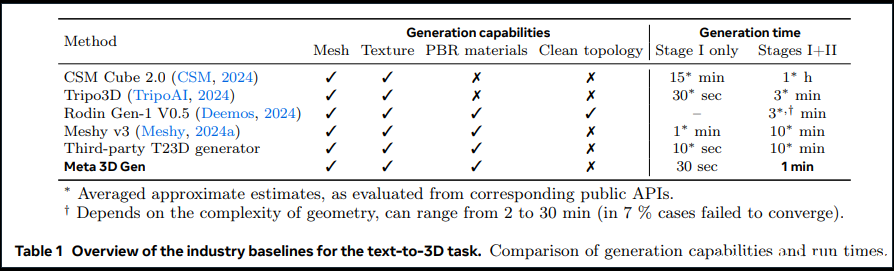

根据Meta提供的数据,和单一阶段模型,包括Common Sense Machines(CSM)Cube、Tripo3D、Rodin Gen-1、Meshy T23D(text-to-3D)生成模型相比,Meta有68%的胜率。在AssetGen阶段中,Meta 3D Gen居第二(仅低于CSM Cube),而整合二个阶段,Meta 3D Gen平均可以在1分钟生成3D物件超过大部分其他模型。

图片来源/Meta

Meta 3D Gen目前还在研究阶段,论文可在此下载。