阿里通义实验室发布Z-Image:60亿参数,16GB显存跑出旗舰画质

就在今天,阿里通义实验室正式推出新一代图像生成模型 Z-Image,一款参数仅60亿、却能与百亿级模型比肩的轻量级图像生成神器。它不靠堆参数,而是靠架构创新,在消费级显卡上实现了前所未有的画质与速度平衡——你甚至可以用一块RTX 4060或3080 16GB,轻松生成媲美Midjourney V6、SDXL 1.0的摄影级图像。

更令人惊喜的是,Z-Image 不只是“能跑”,而是“跑得稳、画得好、懂人话”。它在文字渲染、文化理解、复杂指令解析和图像编辑上,展现出远超同体量模型的成熟度。这不再是实验室的Demo,而是一款真正面向创作者、设计师、短视频运营和普通用户的生产力工具。

三款模型齐发:Turbo、Base、Edit,覆盖全场景需求

Z-Image 本次发布完整产品线,满足从“秒出图”到“深度定制”的全链条需求:

- Z-Image-Turbo:8步生成,3秒出图,画质直逼SDXL和DALL·E 3,适合日常创作、电商海报、社交媒体内容快速生产。

- Z-Image-Base(即将上线):开源底座模型,支持LoRA、DreamBooth微调,开发者可基于它训练专属风格,比如国风插画、赛博朋克、二次元等。

- Z-Image-Edit(即将上线):专为图像编辑设计,支持“改衣服不改脸”“换背景不扭曲主体”“局部重绘文字”等高精度操作,是设计师的“AI修图助手”。

与市面上多数模型“生成完就结束”不同,Z-Image 的编辑能力直接打通了“生成—修改—再生成”的闭环,真正实现“所想即所得”。

单流架构突破:把文本、图像、语义“串起来”一起学

Z-Image 的核心技术是全新的 Single-Stream Diffusion Transformer(单流扩散变换器)。传统模型要分别处理文本编码、图像编码、VAE压缩码,再拼接融合,效率低、信息丢失严重。

Z-Image 把所有信息——你输入的文字、图像的语义标记、甚至VAE压缩后的像素编码——全部拼成一个统一序列,像读一本“图文并茂的书”一样同步学习。这不仅让模型对语义理解更透彻,也大幅提升了算力利用率。

结果就是:同样16GB显存,别人跑SDXL要压缩到512x512,Z-Image-Turbo 直接输出1024x1024,细节不缩水,还快一倍。

六大实测亮点:不只是快,是“懂行”

1. 写实感拉满,人物细节堪称“毛孔级”

在人物生成上,Z-Image-Turbo 展现出惊人的真实感:发丝根根分明,皮肤有自然的红润与阴影过渡,衣物褶皱符合物理规律,光影方向一致。没有“塑料感”、没有“AI脸”,连睫毛的投影都清晰可见。这在以往轻量模型中几乎不可能实现。

2. 中英文文字渲染,准确到标点符号

“AI画图写错字”是行业通病。但Z-Image 在海报、LOGO、书籍封面等场景下,能准确生成中英文混合文本,大小适配、字体清晰、无扭曲。无论是“双十一狂欢”还是“Welcome to Shanghai”,都能精准还原,连引号、逗号都不出错。

3. 文化理解力强,不是“拼图机器人”

它能理解“敦煌飞天”该穿什么服饰、“清明上河图”该有什么市井氛围、“日本神社”该配鸟居和枫叶。不是靠关键词堆砌,而是基于真实世界知识生成。你输入“李白在月光下独饮”,它不会画个现代人穿汉服,而是还原唐代衣冠、酒具、山水意境。

4. 能“推理”指令,不是“照搬词典”

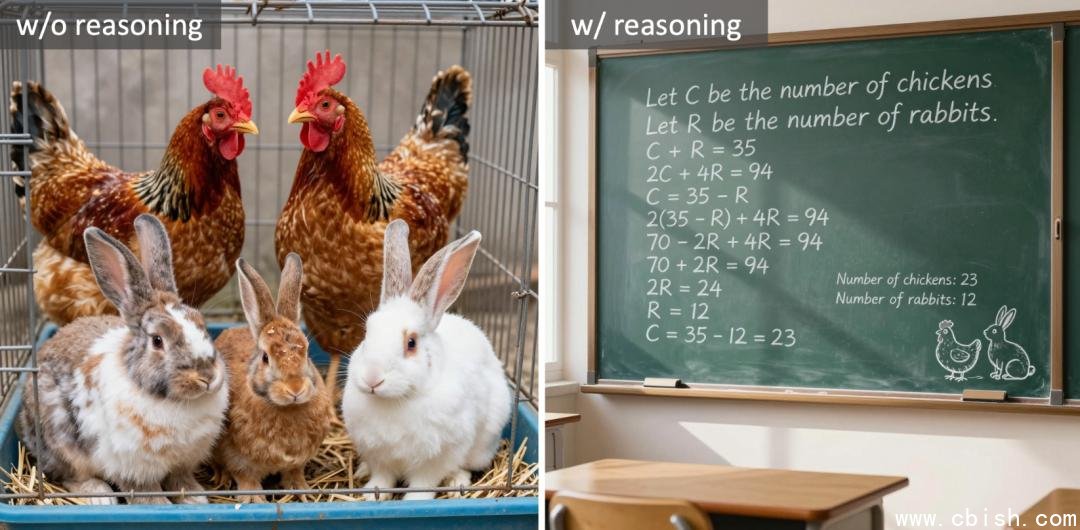

传统模型看到“鸡兔同笼,共35头94足”,只会乱画一堆动物。Z-Image 却能自动推理:23只兔子 + 12只鸡,画出合理的动物分布和环境。

还能处理模糊描述:“帮我画一个像宫崎骏电影里的海边小镇,但要有中国江南的味道”——它能融合日式治愈感与青瓦白墙、乌篷船、石板路,生成一幅有文化融合感的画面。

5. 图像编辑:改哪里,像哪里

Z-Image-Edit 不是“涂改”,而是“理解式编辑”。你可以:

- “把背景换成雪山,但人物衣服和表情不变”

- “把海报上的‘限时优惠’改成‘新年特惠’,字体风格自动匹配”

- “把人物姿势从站立改成奔跑,四肢自然延展,不崩脸”

支持中英文混合指令,甚至能识别“把左边的花瓶移到右边,稍微放大一点”这种多步操作。

6. 8步生成的秘密:Decoupled-DMD + DMDR

Turbo 模型能8步出图,靠的是两项原创技术:

- Decoupled-DMD:把“分布对齐”和“提示词引导”分开优化,避免传统CFG(Classifier-Free Guidance)带来的画面过饱和或失真。

- DMDR:引入强化学习机制,让模型学会“什么是好看的构图、什么是自然的光影”,再用DMD稳定输出。相当于给AI请了个美学导师+质检员。

最终效果:速度快、细节多、不崩、不糊、不违和。

部署像发微信一样简单:几行代码,立刻上手

无需复杂配置,无需训练,Z-Image 提供官方 Hugging Face Diffusers 接口,5分钟就能在本地跑起来:

```bash pip install git+https://github.com/huggingface/diffusers ``` ```python from transformers import ZImagePipeline import torch pipe = ZImagePipeline.from_pretrained( "Tongyi-MAI/Z-Image-Turbo", torch_dtype=torch.bfloat16, low_cpu_mem_usage=False, ).to("cuda") image = pipe( prompt="一位穿着唐装的女子在江南水乡撑伞漫步,夕阳洒在青石板路上,风格写实摄影", height=1024, width=1024, num_inference_steps=8, guidance_scale=0.0, ).images[0] image.save("jiangnan.jpg") ```支持 Flash Attention、模型量化、CPU Offload,即使你只有8GB显存,也能通过优化跑通1024x1024分辨率。官方已提供 Colab 演示链接,无需安装,点开就能试。

为什么Z-Image能改变行业?

过去,高质量图像生成是大厂的专利——你得用API、得花钱、得等排队。现在,Z-Image 把“高质量”和“可触达”真正统一了。

自媒体博主能用它做封面;独立游戏开发者能快速出原画;电商团队能批量生成商品图;甚至美术生也能用它辅助构思草图——这一切,都不再需要RTX 4090或云端算力。

更重要的是,它不是“闭源黑盒”。Base版本即将开源,意味着社区可以共建中文风格模型、训练国风LoRA、甚至开发插件。Z-Image,正在成为中文AI视觉生态的“新安卓”。

未来已来:Z-Image 与你的创作,只差一次点击

现在,你可以在 Hugging Face 模型库搜索 “Tongyi-MAI/Z-Image-Turbo” 立即体验。官方已开放 Discord 社区,开发者可申请内测 Z-Image-Edit 和 Base 版本。

当AI图像生成从“炫技”走向“实用”,从“高端玩家”走向“普通人”,真正的变革才刚刚开始。