OpenAI推出两大新安全功能,守护企业与开发者的数据防线

OpenAI 近日宣布为 ChatGPT 系列产品上线两项关键安全升级,直击当前AI应用中最棘手的“提示注入攻击”问题。这类攻击常被黑客利用,通过精心构造的指令诱导AI访问恶意网站、窃取内部数据,甚至执行未经授权的操作。随着企业越来越多地将AI接入内部系统、客户平台和代码环境,这类风险已从理论威胁演变为真实隐患。

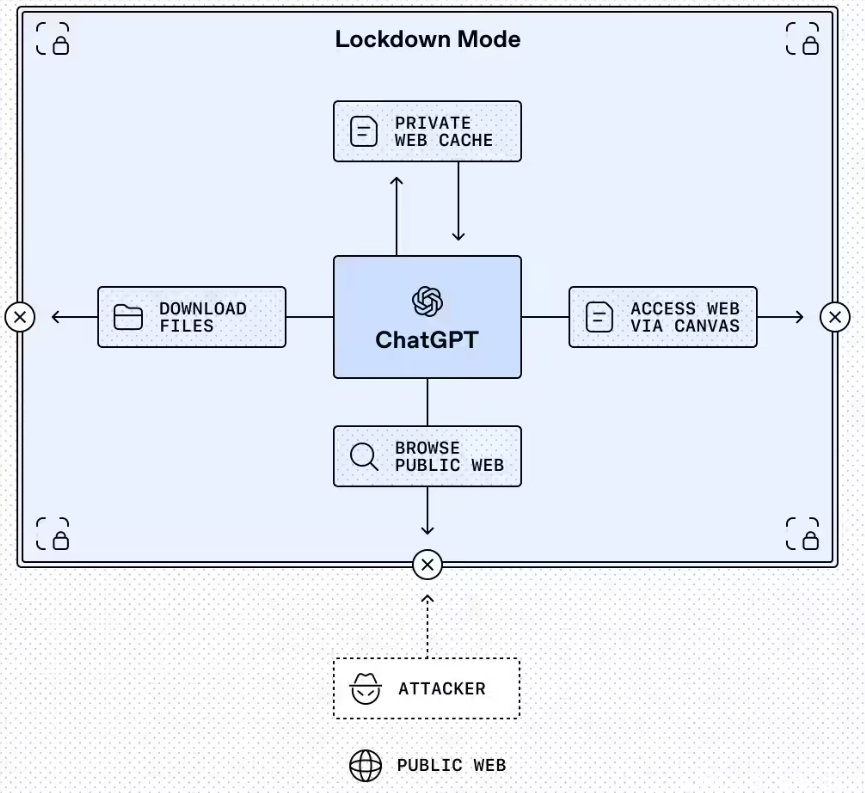

锁定模式:为企业和敏感机构打造“安全气泡”

此次推出的“锁定模式”(Lockdown Mode),不是普通用户能随意开启的花哨功能,而是专为医疗、教育、金融、政府等对数据安全有严苛要求的组织设计的“硬核防护”。启用后,ChatGPT 将彻底切断对外部网络的随意访问——网页浏览只能调用已缓存的、经过审核的内容,任何未经验证的API、文件上传、实时爬虫等功能一律禁用。

目前,该功能已开放给 ChatGPT Enterprise、教育版、医疗版和教师版用户。管理员可在后台创建不同权限的角色,精确控制哪些外部工具可以使用、哪些操作被禁止,比如允许访问公司内部知识库,但禁止连接外部云存储或社交媒体。

更关键的是,OpenAI 同步推出了 Compliance API Logs Platform,所有通过锁定模式触发的外部调用都会被完整记录,支持导出审计报告,满足GDPR、HIPAA等合规审查要求。这意味着企业法务或IT部门不再只能“相信AI不会出错”,而是能真正看到“它到底做了什么”。

据内部消息,OpenAI 计划在2024年下半年将锁定模式逐步开放给个人付费用户(Plus 和 Team 订阅),但默认关闭,需手动开启。这意味着普通用户未来也能为自己使用AI时的隐私安全加一道保险。

“高风险”标签:让每个功能的风险,不再藏在说明书里

另一项升级看似低调,却直击用户痛点:在 ChatGPT、ChatGPT Atlas 和 Codex 中,所有涉及网络访问、外部系统调用或敏感数据交互的功能,都将统一打上 **“Elevated Risk(风险提升)”** 标签。

过去,开发者在使用 Codex 时,可能只是点了个“允许联网”按钮,却不知道这意味着AI可以访问公开代码库、读取GitHub仓库,甚至可能被诱导爬取公司内部文档。现在,一旦启用这类功能,界面上会清晰弹出提示:

- ?? 启用后,AI 可访问互联网内容

- ?? 可能暴露你输入的代码片段或项目结构

- ?? 建议仅在隔离环境或非敏感项目中使用

- ? 推荐做法:关闭联网,使用本地模型

这不是吓唬人,而是把选择权交还给用户。OpenAI 承认:有些功能确实有用,但“有用”不等于“安全”。与其让用户在不知情中踩雷,不如提前亮红灯。

这一设计也适用于企业场景。当一名工程师在公司内部使用 ChatGPT Atlas 分析日志时,系统会明确提示:“该操作将连接外部监控系统,可能泄露服务器IP和错误堆栈”。管理者可以据此决定是否允许该操作,或要求使用脱敏数据。

这不是终点,而是安全意识的起点

OpenAI 的这两项更新,标志着AI产品从“功能优先”转向“安全与功能并重”。过去,我们担心AI会“胡说八道”;现在,我们更怕它“太听话”——被诱导执行危险指令。

对企业而言,锁定模式 + 审计日志,等于给AI装上了“黑匣子”和“安全锁”;对个人用户,高风险标签则是一道醒目的“红绿灯”,让你在享受便利的同时,清楚自己在冒什么险。

未来几个月,随着更多组织将AI嵌入核心业务,这类安全机制将成为标配,而不是加分项。OpenAI 没有吹嘘“绝对安全”,而是选择用透明和控制,重建用户信任——这才是真正负责任的做法。