图片来自 Igor Omilaev 在 Unsplash

安全公司SentinelOne和Censys发现,开源大语言模型(LLM)框架Ollama在全球的部署,形成了约17.5万台主机可公开访问的AI计算基础设施,可能被恶意人员滥用。

Ollama是一个开源、轻量且高效的LLM开发框架,允许用户在自有硬件上运行LLM。研究人员指出,其原始设计中,Ollama实例绑定在本地接口上,仅允许本机程序或用户访问。但若用户或部署者更改服务绑定地址(例如设为0.0.0.0或指向公共网络接口),就会使服务暴露在互联网上。许多用户未配置防火墙或访问控制,导致大量Ollama实例可被外部网络直接访问。

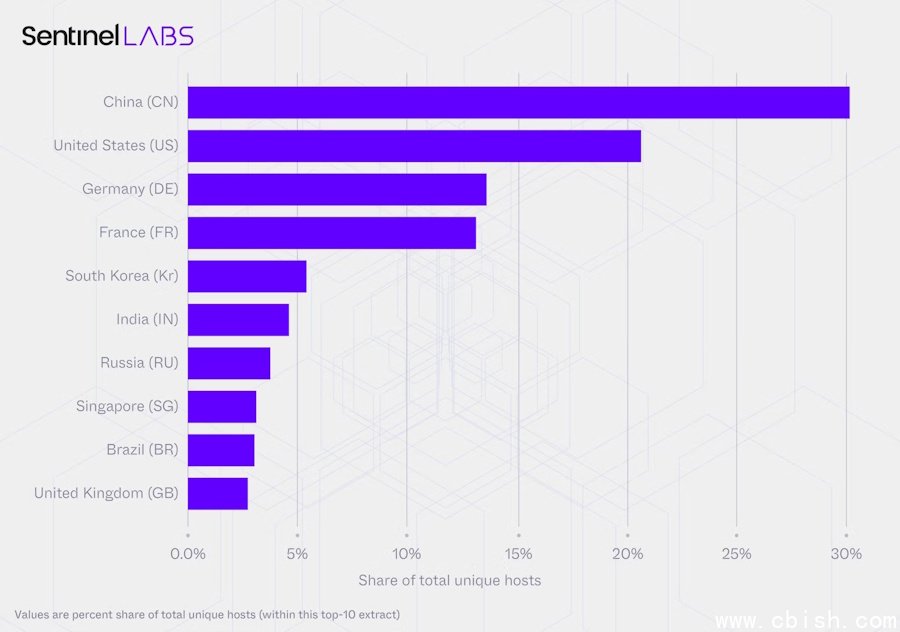

SentinelOne与Censys合作开展的研究项目扫描了互联网上可访问的Ollama环境。经过293天的扫描,他们发现了175,018台Ollama主机,分布于130个国家、4,032个自治系统编号(Autonomous System Numbers,ASN),其中中国和美国分别占30%和21%。研究记录到这些17.5万台主机共执行了723万次访问,其中大部分活动来自2.3万台主机。

图片来源:SentinelLABS

为评估其安全风险,研究人员深入分析了这些主机的能力。超过48%的被监测主机具备通过API端点调用工具的能力,可执行代码、访问API并与外部系统交互;38%的主机同时具备调用工具和完整任务执行能力。研究还发现,至少有201台主机运行了“无审查”(uncensored)的提示模板,可绕过安全限制。

该报告总结了这一庞大去中心化Ollama网络所面临的安全隐患。首先,这些资源可未经身份验证、监控或计费管控被访问,可能被用于发送垃圾邮件、钓鱼攻击、传播虚假信息或滥用网络资源。其次,调用工具功能与缺乏身份验证、公开暴露的主机结合,使攻击者可通过提示注入(prompt injection)等手段诱导LLM查询或操作本不应暴露的系统数据,研究人员指出这构成了最高风险场景。

目前公开的Ollama主机主要运行三大主流模型家族:Llama、Qwen2与Gemma2,且普遍依赖相同的量化格式(如Q4_K_M),形成高度同质化的脆弱环境。一旦该模型或格式存在漏洞或可被操控的处理方式,大量暴露系统可能同时遭受同一攻击手法的波及。

其他两项风险包括:身份伪装与安全绕过。由于大量Ollama主机部署在家庭网络或低成本VPS上,攻击者可将流量通过这些网络隐藏真实身份,绕过安全过滤和反机器人检测机制。此外,缺乏云端集中化网络管理机制,一旦被滥用,难以通过传统安全通报或封禁流程及时遏制。