12亿参数,手机跑得动的“思考型”AI

Liquid AI 最近发布了一款让人眼前一亮的新模型:LFM2.5-1.2B-Thinking。别被“12亿参数”吓到——它不是那种需要服务器集群撑着的庞然大物。你甚至能把它装进iPhone或安卓旗舰机里,运行起来只占约900MB内存。也就是说,过去只能在云端跑的复杂推理任务,现在关掉网络,手机也能独立完成。

这不是又一个能聊天、写文案的通用AI。它专为“动脑子”的活儿设计:解数学题、做逻辑推演、调用计算器或日历工具,样样拿手。最特别的是,它不直接甩答案,而是先“想一想”——每一步怎么算、哪里容易出错、要不要回头检查,都会留下清晰的思考轨迹。就像你做题时在草稿纸上写写画画,它也在后台默默列步骤、验结果。这让你能看懂它为什么这么答,而不是一头雾水。

跑得快,还不卡顿

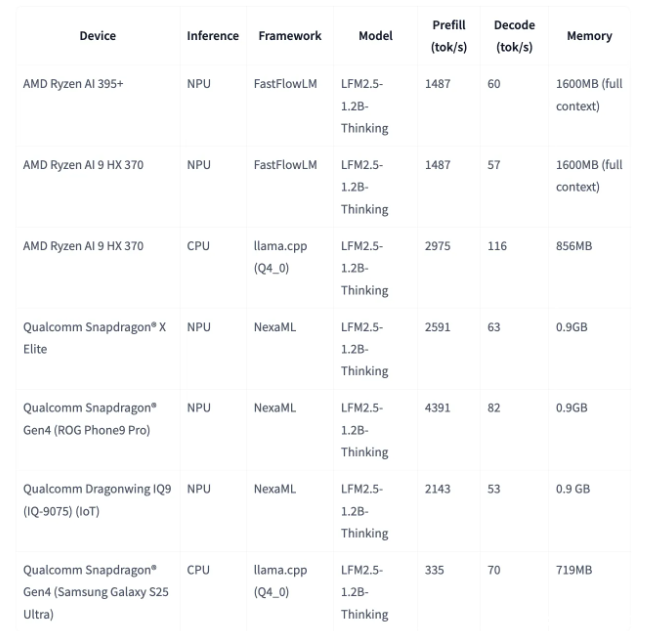

速度上,这款模型在AMD笔记本CPU上每秒能输出239个字符,手机上的NPU(神经网络处理单元)也能稳定跑到82字符/秒。这个速度意味着你输入一个问题,几乎和打字一样快就能看到完整解答,没有等待的焦躁感。

更关键的是,它不容易“卡壳”。过去很多推理模型一遇到复杂问题就陷入无限循环,反复重算、死机重启。Liquid AI团队用一种叫多阶段强化学习(RLVR)的技术,把这类问题的发生率从近16%压到了不到0.4%。简单说,你让它算一道奥数题,它不会原地打转,也不会突然没反应——它会一直认真算下去,直到出结果。

离线可用,隐私无虞

你不用再担心敏感数据上传云端。无论是财务计算、学习笔记、医疗信息,还是工作中的机密方案,全部在本地处理。没有网络?没关系。没开流量?照样用。这不只是方便,更是对隐私的真正尊重。

目前,这款模型已开始向开发者开放测试,未来有望集成到笔记应用、学习工具、编程辅助等场景中。如果你用过类似Notion AI、MathGPT这类工具,但总嫌它慢、怕它乱、担心它“偷看”你的内容——那这款模型,可能正是你一直在等的那一个。