树莓派(Raspberry Pi)官方正式发售AI HAT+ 2扩展板,面向树莓派5的本地AI推理需求,主打将生成式AI工作负载部署到设备端运行。AI HAT+ 2采用Hailo-10H神经网络加速器,并配备8 GB板载专用内存,定价130美元,目前已上市销售。

树莓派约一年前推出的AI HAT+以Hailo-8和Hailo-8L为核心,分别提供26 TOPS和13 TOPS的推理性能,主要加速计算机视觉模型,涵盖目标检测、姿态估计、场景分割等应用。但随着生成式AI模型在开发者群体中迅速普及,上一代AI HAT+在支持生成式AI模型方面存在明显不足。

AI HAT+ 2的主要改进在于硬件架构与内存配置。官方指出,Hailo-10H可在INT4精度下提供40 TOPS的推理性能,并搭配8 GB板载专用内存,旨在更高效地处理更大规模的模型。官方也将支持范围扩展至大型语言模型、视觉语言模型等生成式AI应用,不再局限于摄像头和图像导向的计算机视觉任务。

AI HAT+ 2标称的40 TOPS是基于INT4精度的推理性能,主要面向生成式AI负载。对于YOLO等以计算机视觉为主的模型,树莓派表示AI HAT+ 2的整体视觉性能与前代26 TOPS版本基本持平,板载专用内存有助于稳定这类任务的运行表现。在软件集成方面,新扩展板延续了原有的摄像头软件栈接口,包括libcamera、rpicam-apps和Picamera2,原有AI HAT+用户迁移到AI HAT+ 2后,基本可保持相同的使用方式。

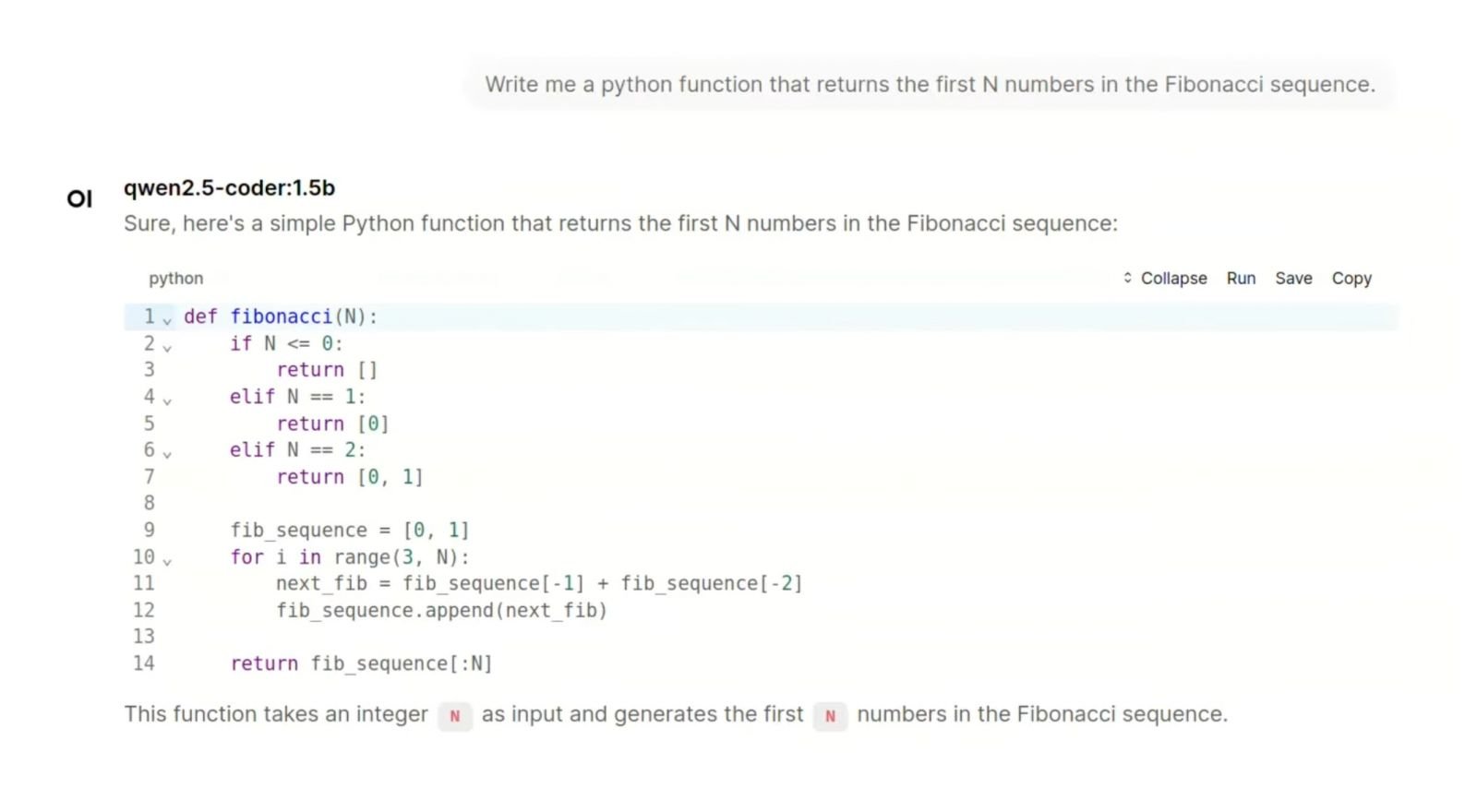

官方在演示中采用Hailo提供的hailo-ollama作为大型语言模型后端,结合Open WebUI在浏览器中提供对话界面,展示了在树莓派5搭配AI HAT+ 2的组合下,实现本地端问答、编程辅助、翻译,以及通过摄像头画面进行场景描述等应用场景。官方列出的支持模型多为10亿至15亿参数规模。

树莓派也提醒,边缘端可运行的模型规模受限于设备本身的内存与算力资源,其定位与云端超大规模模型不同。为提升特定场景下的可用性,AI HAT+ 2延续前代做法,支持使用Hailo Dataflow Compiler重新编译视觉模型,同时支持语言模型的LoRA微调——即仅调整少量参数的轻量级微调方法,便于开发者针对特定任务制作适配器并在扩展板上部署运行。