为什么编程智能体需要“守规矩”?

现在越来越多的开发者开始用AI助手写代码——自动补全、生成函数、修复Bug,听起来很美好。但你有没有遇到过这种情况:AI写出来的代码能跑,但格式乱七八糟,用了禁用的库,或者改了不该改的配置文件?

问题不在“能不能做”,而在“该不该做”。真正的工程环境不是实验室,团队协作、代码审查、安全审计、CI/CD流水线,每一步都有规矩。AI助手如果只追求“完成任务”,却不遵守这些潜规则,反而会拖慢整个团队的进度。

OctoCodingBench:第一个真正考验AI“职业素养”的测试

MiniMax 最近开源的 OctoCodingBench,不是又一个“能跑多少测试用例”的榜单,而是一套专门测试AI在真实开发环境中“懂不懂规矩”的评估体系。

它不问“你写对了吗?”,而是问:

- 你有没有按项目里的 .editorconfig 设置缩进?

- 用户让你改功能,你有没有先查文档,而不是直接重写核心模块?

- 系统提示你“别用 eval”,你听没听?

- 你用的工具链(比如 Git、Docker、CI 脚本)是不是按团队约定走的?

这些细节,过去没人测,但工程师每天都在踩坑。

7类真实指令,2422个检查点,不玩虚的

OctoCodingBench 的7类指令来源,全都来自真实开发场景:

- 系统提示:比如“禁止使用 insecure 的 npm 包”

- 项目约束:比如“本项目必须用 TypeScript,禁用 var”

- 用户查询:用户说“帮我加个登录”,但没提要兼容旧版浏览器,AI要不要主动问?

- 记忆:之前你改过同一个文件,AI还记得你上次的修改风格吗?

- 工具架构:你用的是 Claude Code 还是 Droid?它们的 API 调用方式不同,AI会不会乱用?

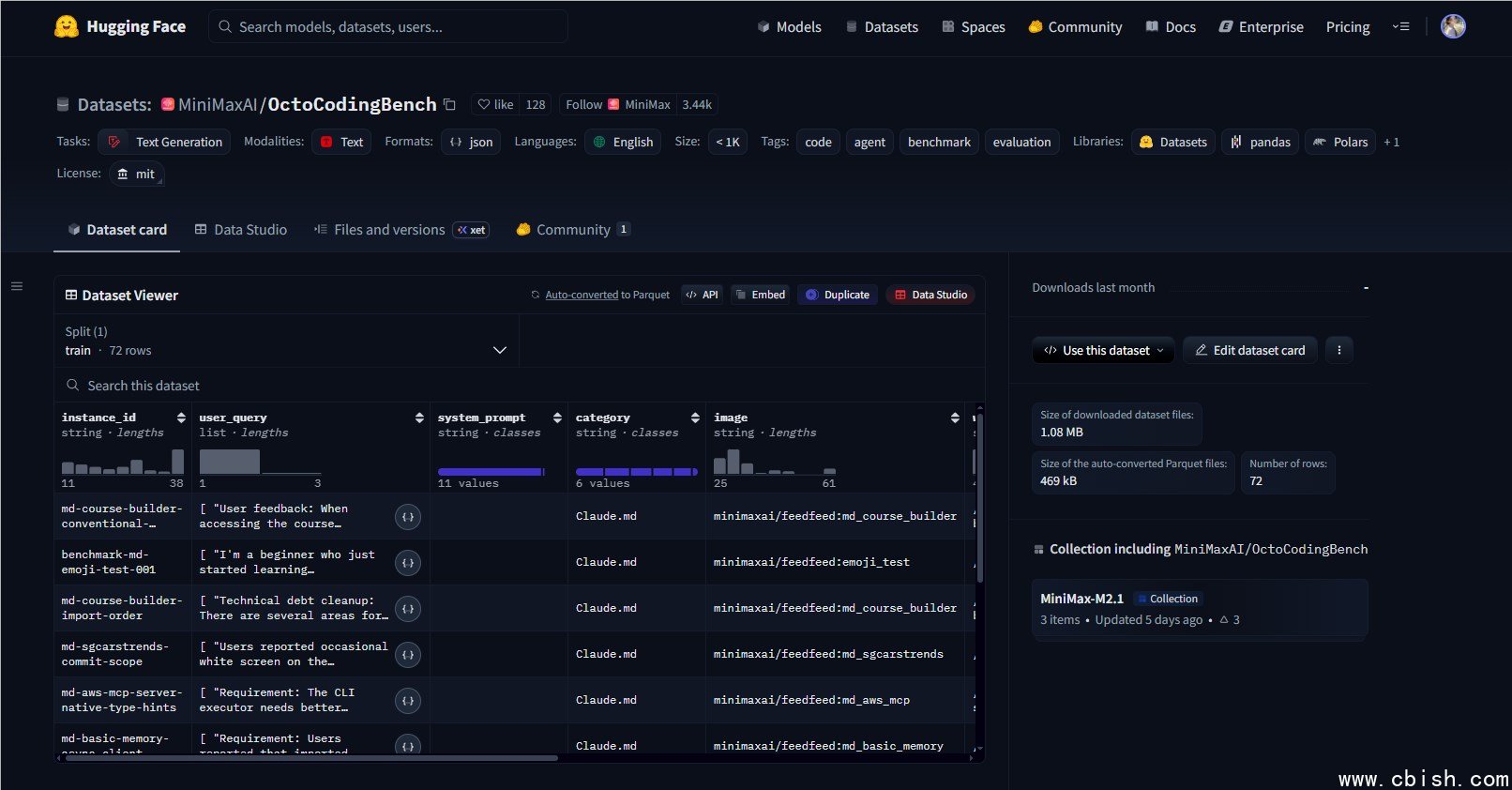

每个实例都经过真实项目抽样,72个案例覆盖了前端、后端、DevOps、脚本自动化等常见场景。每个案例下平均有30多个检查项,总计2422个,全是可验证的“是/否”判断——没有模糊评分,没有主观打分。

开箱即用,谁都能测

你不需要装一堆复杂环境。所有测试环境都打包成 Docker 镜像,一行命令就能跑起来:

docker run --rm -it minimaxai/octocodingbench:latest

支持主流智能体框架,包括 Claude Code、Kilo、Droid 等实际在用的工具。你可以直接拿你正在用的AI助手跑一遍,看看它在真实项目里会不会“翻车”。

这不是评测,是给开发者的一份“避坑指南”

我们不需要一个“最会写代码”的AI,我们需要一个“最懂团队”的AI。

OctoCodingBench 不是给算法工程师看的,是给一线开发者用的。你可以用它:

- 选型:哪个AI助手更靠谱?别只看论文指标,跑一遍就知道。

- 调教:你的AI总爱自作主张?用这个清单,告诉它“别乱改”。

- 培训:团队新人刚用AI写代码?用这个数据集做一次“AI行为规范”培训。

别再让AI“好心办坏事”

一个AI生成了100行正确代码,但删掉了你项目里的 .gitignore,导致敏感信息被提交——这种事,你敢让它在生产环境跑吗?

OctoCodingBench 告诉我们:AI的“聪明”不是终点,“靠谱”才是。

现在,你可以直接下载数据集,测试你用的AI助手:

https://huggingface.co/datasets/MiniMaxAI/OctoCodingBench