谷歌悄然曝光 Android XR 眼镜原型:不靠云,靠端侧

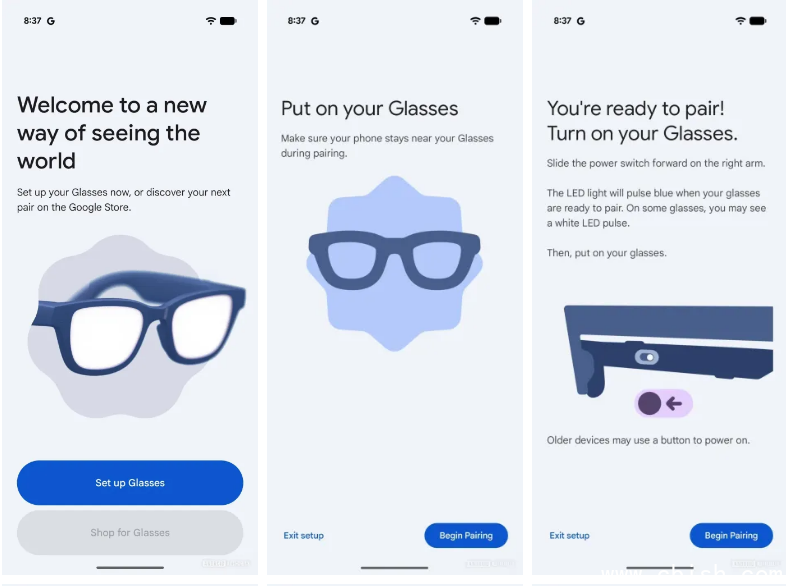

就在 Android Studio 最新 Canary 版本的代码里,一个名为“Glasses”的配套应用悄然现身——包名是 com.google.android.glasses.companion。它没有官宣,没有发布会,甚至连硬件影子都还没露,但它的代码却像一把钥匙,打开了谷歌在智能眼镜领域憋了多年的底牌。

这不是概念图,也不是未来设想。从代码结构、权限声明到功能逻辑,这个应用已经具备了完整的产品形态。它指向的,是 Meta Ray-Ban 智能眼镜之后,真正能打的下一代 AR 眼镜——而且,谷歌这次,不走老路。

拍得清,也懂得“不拍”

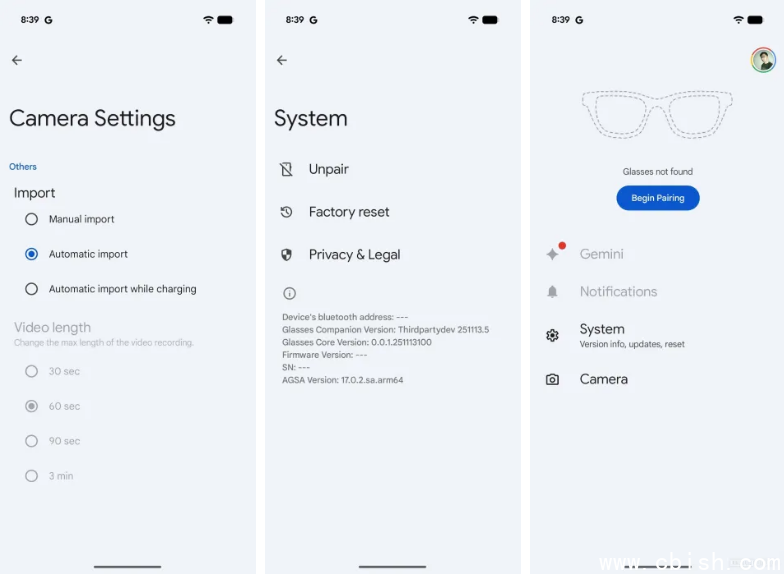

这款眼镜的影像能力相当硬核:标准模式支持 1080p 视频录制,而一个被标注为“实验性”的 3K 模式,单段视频最长可录 3 分钟——这已经远超目前市面上主流智能眼镜的拍摄能力。更关键的是,它不是简单地“能拍”,而是“知道什么时候不该拍”。

内置的 LED 状态灯不是装饰。如果有人用手或物体遮住前方的灯,系统会直接锁定摄像头,连拍照按钮都会变灰。这不是技术限制,是设计哲学:隐私必须看得见、摸得着。你挡住了灯,就意味着你不想被记录,系统就尊重你。

还有更聪明的:它能听出你是不是在说话。借助 Gemini 模型在设备端的实时语音分析,一旦检测到用户开口,所有通知音、电话铃声都会自动静音。你和朋友聊天时,它不会突然“滴滴”打断你;你走在街上自言自语,它也不会把你的每一句话都录下来传到云端——因为根本不会传。

所有数据,留在你的眼镜里

谷歌这次把“端侧处理”当成了核心卖点。视频、音频、对话识别,全都在眼镜本地完成。没有上传,没有云端分析,没有数据抽样。这不是一句营销口号,而是代码里明明白白的权限限制和数据流向设计。

这背后,是谷歌对隐私问题的重新思考。Meta 的智能眼镜曾因“偷偷录音”被欧盟调查,苹果的 Vision Pro 虽强,但依赖云端 AI 做空间识别。而谷歌这次,直接把 AI 压进芯片——不靠云,也能聪明。这不仅是技术自信,更是对用户信任的回应。

物理按键、亮度调节、纯音频模式——细节藏不住

别以为这只是个“软件演示”。代码里清晰写着:眼镜有独立的物理开机键,不是靠语音唤醒,也不是靠触控。你摸得到、按得响,这才是真正能用的硬件。

亮度调节、仅音频模式(也就是关闭摄像头,只当耳机用)这些功能,都被完整预留。这意味着,它不是为“炫技”设计的,而是为日常场景——通勤、开会、健身、散步——量身打造的工具。

有人会说,这不就是个带摄像头的 AirPods 吗?但不一样。它能拍,能识,能懂你,却从不越界。你用它录一段街景,它不会自动标记路人;你和同事对话,它不会把你的语气分析成情绪报告。

2026年,三星首发?谷歌的生态棋局

据多方信源透露,三星可能在 2026 年初发布首款搭载这套系统的 Android XR 眼镜,成为谷歌的“硬件代言人”。但这不是合作,是绑定——没有谷歌的软件,这副眼镜就只是个普通摄像头;没有三星的硬件,谷歌的系统也无处安放。

更值得玩味的是,谷歌没有像 Apple 一样自研硬件,而是选择让合作伙伴来造,自己掌管系统和生态。这背后,是安卓的基因:开放、分发、共赢。它不求独占,但求主导。

如果你用过 Pixel 手机,你就能理解这种节奏:不急着发布,但一旦露出,就是能用、好用、值得信赖的产品。这次的 Glasses,很可能就是下一个 Pixel 7——只是,它戴在你脸上。

我们等的不是一台“增强现实设备”,而是一副能看、能听、能懂,却从不打扰你的智能眼镜。谷歌,这次真的走对了路。