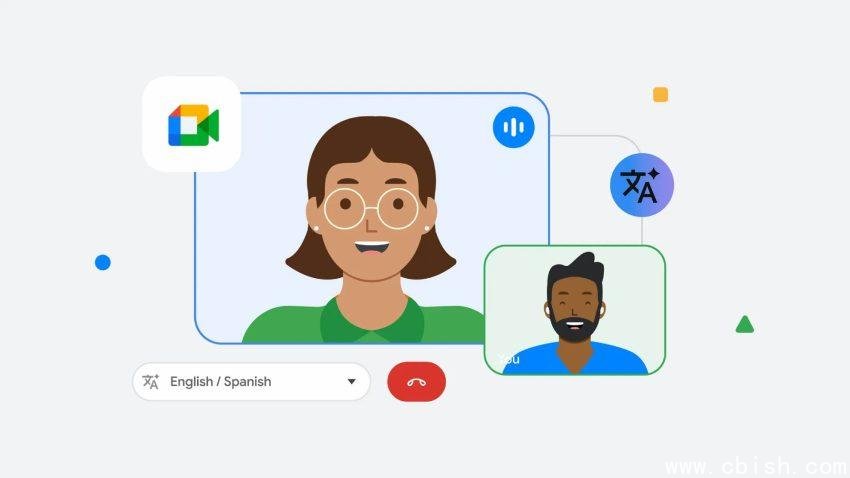

告别“机器人说话”:谷歌实时语音互译,让跨语言聊天终于像面对面

过去,参加一场跨国视频会议,你可能得忍受这样的体验:对方说完一句话,屏幕下方缓缓出现字幕;等你回应,系统又要花上四五秒才翻译出声音——整个对话像在玩“传话游戏”,节奏断断续续,情绪全被磨没了。更别提那些机械、僵硬的合成音,听上去根本不像真人说话。

现在,这一切正在被彻底改变。

谷歌最新推出的实时语音互译技术,首次将语音翻译延迟压缩到2秒以内,并实现了保留原声特征的突破——你听到的不再是AI合成的“机器人嗓音”,而是对方声音的自然延续,语调、节奏、甚至情绪都原汁原味地传递过来。这意味着,你和外国同事、客户、朋友,终于可以像在同一个房间那样,自然地插话、接话、开玩笑,而不是轮流“报幕”。

从“三步走”到“一步到位”:技术底层的革命

传统语音翻译依赖“语音→文字→翻译→合成语音”的三段式流程,每一步都像在链条上加了一个卡点:语音识别出错、翻译语义偏差、合成语音生硬,层层叠加,最终结果既慢又假。

谷歌这次彻底跳出了这个框架,采用端到端音频直接转换架构。简单说,系统不再“看文字”,而是直接“听声音”,然后“输出声音”。它通过训练数百万小时、时间精确对齐的多语言对话数据,让AI学会在两个语言的语音波形之间建立直接映射关系。

这套系统由两个核心组件驱动:

- 流式编码器:持续分析过去10秒的输入语音,提取语义与语调特征,不等说完就“预判”下一句。

- 流式解码器:一边接收编码信息,一边实时生成目标语言的音频,每毫秒都在调整,确保输出连贯自然。

音频被编码为一组二维token——一种专为语音设计的高效表示方式,能在极低延迟下保持高保真音质。同时,系统还会同步输出一个文本token,供开发者和用户校验翻译准确性,真正做到“听得清、看得懂”。

已落地:Google Meet 和 Pixel 10,你随时能用上

这项技术不是实验室里的Demo,它已经进入真实产品:

- Google Meet 服务器端实时翻译:在视频会议中自动开启,支持多人同时发言、自动识别说话人,翻译结果直接叠加在语音流中,无需手动切换语言。

- Pixel 10 设备端语音翻译:即使没有网络,手机也能本地运行翻译模型,保护隐私的同时实现“离线无障碍沟通”。出差、旅行、街头问路,再也不用靠翻译App截图了。

两者共享同一套AI模型和训练数据,但根据使用场景做了优化:Meet 注重多人、多语种、高并发;Pixel 10 则更强调低功耗、快速启动和隐私保护。

为避免误导,系统在每次生成翻译语音前,都会自动播放一句提示音:“This is an AI-generated voice.”(这是AI生成的声音),确保沟通透明,符合伦理规范。

目前支持哪些语言?未来会更懂“人话”

初期重点覆盖全球使用最广的六种语言:英语、西班牙语、德语、法语、意大利语、葡萄牙语,并支持双向互译。测试数据显示,在这些语言对之间的翻译准确率已超过90%,自然度大幅提升。

更令人惊喜的是,在印地语、阿拉伯语、日语等语法结构复杂、语序差异大的语言上,系统也展现出出色的适应能力——这说明它的泛化能力远超传统模型。

谷歌团队透露,下一步将重点攻克“语序适配”难题。比如中文常说“我昨天去了超市”,英文习惯说“I went to the store yesterday”,传统翻译会逐字硬套,而新系统能自动调整语序,让翻译结果更符合目标语言的表达习惯——不是“翻译了句子”,而是“翻译了意思”。

这意味着什么?一场沟通方式的静默革命

当语言不再是障碍,跨国协作、教育交流、家庭团聚、旅游体验……都将被重新定义。

一位在德国工作的中国工程师,终于能和同事边喝咖啡边聊孩子上学的事;一位西班牙游客在东京街头,对着便利店店员自然地问路,对方笑着用流利的日语回应——而这一切,发生在你手机或会议软件的后台,无声无息,却真实有效。

这不是科幻,它已经来了。谷歌这场“语音翻译的iPhone时刻”,或许正是我们迈向“无语言世界”的第一步。