AI的“黑箱”困境:为什么我们看不懂大模型在想什么?

从写论文、批改作业到辅助医生诊断,AI已经悄然融入我们生活的每一个角落。但一个根本性问题始终悬而未决:我们真的知道它为什么这么“答”吗?

当前主流的大语言模型,比如GPT系列,依靠的是数十亿甚至上万亿个内部参数(权重)的协同作用。它们不是像程序员写代码那样“按步骤执行”,而是通过海量数据“猜”出最优答案。这种机制让模型表现强大,却也像一个密封的黑盒子——你输入一个问题,它给出答案,但没人能说清中间到底发生了什么。

这不仅是个学术难题,更是现实风险。当AI在医疗诊断中误判、在司法辅助中偏见决策,甚至在教育场景中给出错误解题思路时,我们连错在哪都找不到。无法解释,就无法信任;无法信任,就无法规模化应用。

OpenAI的新尝试:用“神经电路”代替“超级网络”

为破解这一难题,OpenAI团队另辟蹊径,不再追求更大、更密的模型,而是转向“稀疏模型”——一种只保留关键连接、剔除冗余路径的神经网络结构。

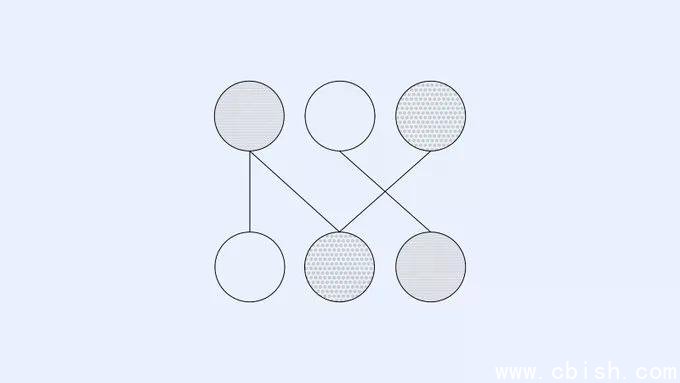

传统模型中,一个神经元可能与成千上万个其他神经元相连,信息像洪水般涌动,难以追踪。而稀疏模型则像城市中的地铁线路图:只保留必要的换乘站和直达线路,每一条路径都清晰可辨。

一个生动的例子是:当模型需要判断Python代码中字符串的结束引号时(比如是单引号'还是双引号"),传统模型动用成千上万个神经元“模糊投票”,而稀疏模型仅靠3–5个神经元和一条明确的注意力通道就能精准完成。如果人为切断这条通道,模型立刻出错——这说明,它不是“猜”的,而是“真懂”了。

更令人振奋的是,类似原理被成功应用于变量绑定、函数调用等复杂编程逻辑。研究人员甚至能“画出”模型内部的“功能电路图”:哪些神经元负责识别变量名,哪些负责作用域判断,一目了然。

图片:稀疏模型的“神经电路”可视化示意图

为什么这很重要?不只是“可解释”,更是“可控制”

这项研究的意义远不止于学术好奇。在AI安全、合规与监管日益严格的今天,可解释性已成为全球科技政策的核心议题。

- 医疗AI:如果AI建议某种治疗方案,医生需要知道是基于哪条“证据链”做出的判断。

- 教育工具:AI家教若给出错误答案,老师必须能追溯错误源头,而非全盘否定。

- 金融与法律:欧盟《AI法案》已要求高风险AI系统具备“可解释性”,否则不得部署。

稀疏模型提供了一条前所未有的路径:让AI的决策过程像程序代码一样,可以被审查、测试、修改,甚至“打补丁”。这不再是“信任AI”,而是“验证AI”。

挑战与未来:稀疏模型能跑赢“大模型竞赛”吗?

当然,这条路并不平坦。目前OpenAI的稀疏模型规模远小于GPT-4或Claude 3,训练效率低、计算成本高,还无法处理复杂长文本或多模态任务。

但研究团队已提出两条务实的突破路径:

- “剪枝提取”法:从现有大模型中自动识别并提取出高效、可解释的子电路,就像从一部巨著中摘出精华章节。

- “可解释训练”算法:直接在训练过程中引导模型构建清晰结构,而非事后分析。

2024年,斯坦福大学与DeepMind联合发表的《Sparse Transformers Are More Interpretable》研究也证实:在相同性能下,稀疏结构的可解释性提升达40%以上。这说明,这条路不仅有理论价值,更有工程前景。

结语:AI的“透明化革命”才刚刚开始

我们不再满足于“AI很聪明”,我们更想知道“它为什么聪明”。OpenAI的这项探索,不是要取代大模型,而是为它们装上“透明玻璃罩”——让每一次推理都经得起审视。

未来,或许我们能像调试代码一样调试AI:点击一个神经元,看到它在处理什么;拖动一条连接,观察模型行为如何变化。这不仅是技术的跃迁,更是人与AI关系的重塑:从“使用者”变成“合作者”。

当AI不再神秘,它才真正成为人类值得信赖的伙伴。