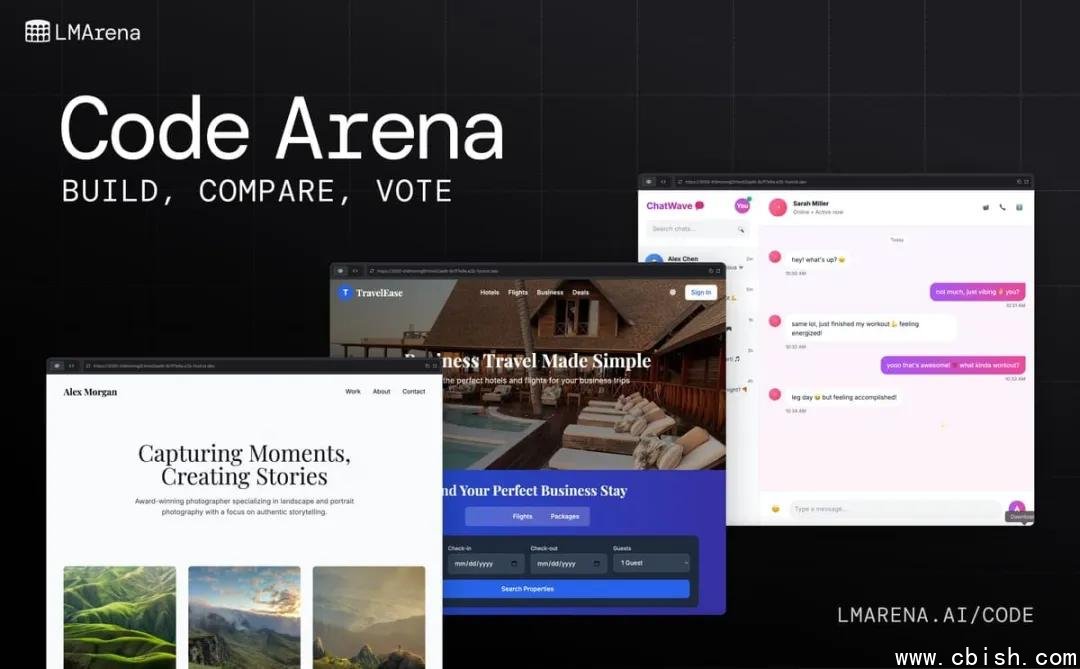

Code Arena:让AI写代码的过程,看得见、查得清、比得准

今天,LMArena 正式推出 Code Arena —— 一个专为AI编码能力打造的全新评测平台。不同于传统测试只看“对不对”,Code Arena 把AI写代码的全过程摊开在你眼前:从理解需求、拆解任务,到写第一行代码、调试报错、重构优化,再到最终提交可运行的程序,每一步都被完整记录、可回溯、可复现。

不是“结果导向”,而是“过程透明”

过去,我们看到的AI编程演示,往往是“一键生成”一段完美代码。但真实开发中,90%的时间花在调试、改错、重构上。Code Arena 模拟真实工程师的工作流:AI不再是黑箱,而是像一个有自主判断力的“智能协作者”——它会主动调用工具创建文件、执行命令、查看日志、修改配置,甚至在遇到错误时主动搜索解决方案(如查阅官方文档或Stack Overflow)。

所有操作都被实时记录在会话日志中,你可以像回放Git提交记录一样,逐帧查看AI的思维路径:它为什么选这个库?为什么改了这个变量?哪一步卡住了?哪次修复是灵光一现?这些细节,过去从未被系统性地收集过。

每一个评测,都有专属“数字工单”

每次评测生成一个唯一ID,像项目工单一样可追踪、可分享。开发者可以复制这个ID,直接在平台中还原整个编码过程,包括环境配置、依赖版本、运行结果和错误日志。这意味着:你看到的不是“演示片段”,而是一个完整、可验证的开发副本。

这不仅让评测更公平,也为学术研究提供了宝贵数据。MIT、CMU等高校的研究团队已开始接入Code Arena,用于分析AI在复杂任务中的决策模式。一些开源项目甚至直接用这些评测结果来训练下一代代码模型。

人工评审 + 数据驱动,拒绝“分数泡沫”

Code Arena 不靠自动化评分打分。每一份产出,都会由资深工程师从四个维度进行人工评估:

- 功能性:代码是否真正解决问题?

- 可用性:是否能直接运行?是否需要额外解释?

- 可维护性:结构是否清晰?注释是否合理?

- 工程意识:是否考虑边界情况、异常处理、性能优化?

所有评分均经过交叉验证,结果以统计分布形式公开,避免“单一评委偏好”带来的偏差。平台首批上线的200+个真实项目任务,均来自GitHub热门开源项目中的issue,包括Python脚本重构、JavaScript前端修复、CLI工具开发等高难度场景。

全新排行榜,从零开始,公平竞争

Code Arena 的排行榜不继承任何历史数据,所有模型从同一组任务、同一环境、同一时间点开始测试。这意味着:GPT-4o、Claude 3.5、Gemini 2.0、Qwen3、DeepSeek-Coder……所有模型都在同一起跑线上比拼真实编码能力,没有“历史红利”,只有当下表现。

首批参与评测的模型中,Qwen3-Code 和 Claude 3.5 Sonnet 在复杂任务中的表现尤为突出,尤其在处理“模糊需求”和“多文件协作”时,展现出更强的上下文理解和工程判断力。这些结果,已在平台公开可查。

谁在用Code Arena?

不只是AI公司。越来越多的科技团队开始把Code Arena作为选型工具:

- 某一线大厂的内部AI助手团队,用它评估不同模型在内部代码库上的适配能力;

- 一家AI编程创业公司,基于Code Arena的评测数据训练自己的微调模型;

- 高校实验室用它做AI编程行为研究,论文已进入评审阶段。

“我们不再相信‘生成代码’的炫技,我们相信‘能解决问题的AI’。”一位参与评测的工程师说。

现在就来体验

Code Arena 已开放公测,免费注册即可使用。你可以上传自己的项目需求,让AI现场编码,全程录像,生成报告。也可以对比不同模型在相同任务中的表现,找到最适合你场景的AI助手。

真正的AI编程能力,不在演示视频里,而在每一次报错后的修复、每一次重构的权衡、每一次注释的斟酌中。Code Arena,让这些时刻,不再被隐藏。