人工智慧当红,相关的开发工具越来越重要,例如,训练大型语言模型的工具一旦存在资安弱点,很有可能危害AI的运作。

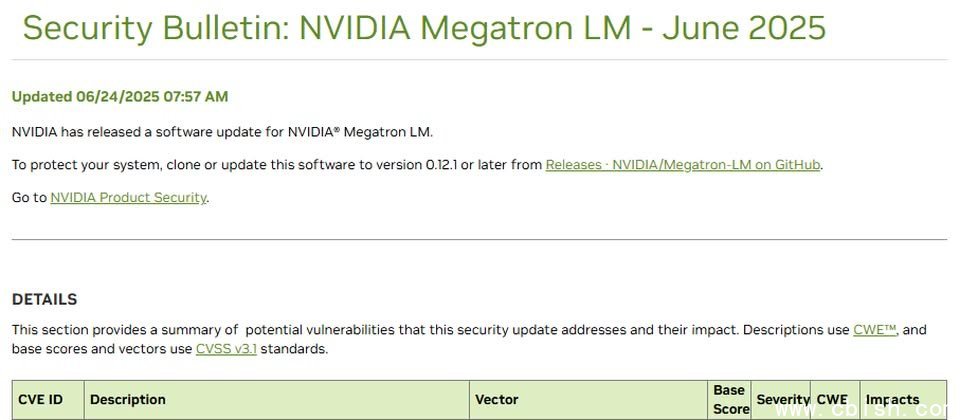

例如,6月24日Nvidia修补的分散式训练框架Megatron LM,就是典型的例子,他们公布CVE-2025-23264、CVE-2025-23265两个高风险的资安漏洞,它们都存在于特定的Python元件,攻击者可藉由恶意文件造成程序码注入的现象,最终导致程序码执行、权限提升、资讯洩露,或是资料窜改,CVSS风险为7.8分,影响0.12.0以前的所有版本,该公司发布0.12.1版Megatron-LM修补。

Megatron-LM是专门训练GPT、BERT、T5等大型语言模型的分散式深度学习训练框架,用于因应在训练数十亿至数千亿个参数的模型时,面临的运算瓶颈与记忆体限制,并能与Nvidia的NeMo框架整合运用,透过DGX A100、H100等GPU丛集运作。因此,上述的漏洞若不处理,很有可能影响模型安全。