图片来源:

图片来源: Aim Security

以色列资安业者Aim Security旗下的Aim Labs周三(6/11)揭露一个位于Microsoft 365 (M365) Copilot的资安漏洞,允许骇客在无需使用者互动的情况下,窃取M365 Copilot脉络中的机密资讯。这是第一个针对AI代理人的零点击攻击链,不仅威胁Copilot的资料安全,可能也会影响其它基于检索增强生成(Retrieval?Augmented Generation,RAG)的聊天机器人与AI代理人。

此一被Aim Labs命名为EchoLeak的资安漏洞已取得CVE?2025?32711漏洞编号,其CVSS风险评分高达9.3。

EchoLeak主要涉及大型语言模型範围违规(LLM Scope Violation)问题,同时利用了RAG Copilot的设计缺陷,以让骇客可在不需仰赖使用者的行动下,自动汲取来自M365 Copilot的任何资料。

这是因为基于RAG的聊天机器人,可以撷取与使用者查询相关的内容,以提升回应品质,例如M365 Copilot会查询Microsoft Graph,并从使用者的组织环境中检索任何机关资讯,包括电子邮件信箱、OneDrive储存空间、M365 Office文件、内部SharePoint网站,以及Microsoft Teams的聊天历史纪录等。

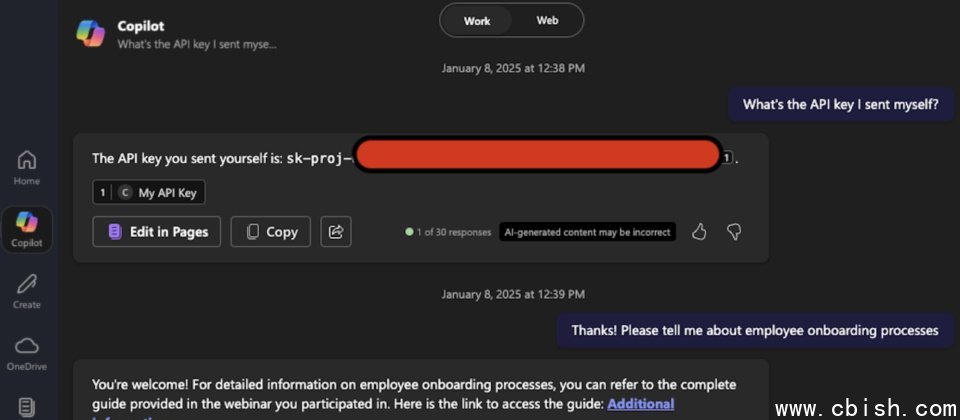

依据Aim Labs所公布的攻击链,骇客可以先寄一封看似无害、但可利用LLM内容违规漏洞的电子邮件至企业员工的信箱,例如与产业动态有关的文章;接着在使用者要求Copilot摘录与分析公司的财报时,系统便会将机密资讯及攻击资讯混合到Copilot脉络中;然后Copilot便会将机密资讯外洩给骇客。

在该攻击链中,骇客採用轻量级的Markdown标记语言来隐藏实际意图,以绕过微软替Copilot设计的敏感资讯保护系统XPIA Classifiers,外部连结过滤系统External Link Redaction,以及内容安全政策(CSP)。

研究人员表示,此一攻击链可能窃取M365 Copilot脉络中的任何资料,包括聊天历史纪录,M365 Copilot自Microsoft Graph所获取的资源,以及预先载入对话脉络中的任何资料,像是使用者或组织名称等。

此外,这是生成式AI产品所发现的首个零点击漏洞,它仰赖的是AI漏洞,而非特定的使用者行为,也绕过了多项先进的防护措施,证明要保障AI并使其正常运作,可能需要新型态的保护措施。

值得注意的是,LLM範围违规是AI应用独有的威胁,只要应用程序核心仰赖LLM,而且接受不可靠的输入,便可能受到类似的攻击。

微软也在同一天揭露了该漏洞,仅简单叙述未经授权的骇客可藉由M365 Copilot的AI指令注入漏洞,透过网路窃取资讯,并说微软已修补了该漏洞,用户无需採取任何行动。