图片来源:

图片来源: Hugging Face

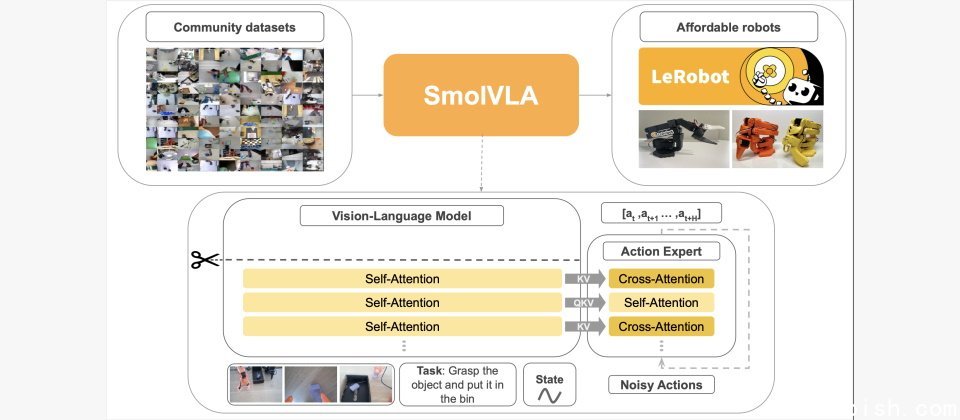

Hugging Face积极拓展机器人业务,继公布二款低成本机器人后,上周再开源一款4.5亿参数量的机器人模型SmolVLA,号称能执行在消费硬件如Mac电脑上。

相较于AI快速进步,机器人进展缓慢许多,这是因为欠缺高品质多元资料,及协助机器人像人类一样思考和行动的模型。为解决这个问题,产业界最近开始重视视觉语言行动(vision-language-action,VLA)模型,这类模型希望在单一模型中整合知觉、语言理解和行动预测能力,并输出相应的机器人行动。惟此类模型主要是专属模型,其训练通常要求昂贵的硬件、多种工程资源及大规模私有资料集,对研究社群取用有很高的门槛。

因此Hugging Face释出SmolVLA,希望能以这个开源、以公开资料集训练,且能执行在消费硬件的轻量模型,推动VLA普及化,加速通用型机器代理人的研究。

在训练时,SmolVLA是以一般操作资料预训练,再以特定任务专用资料进行后训练,以实现更强的适应能力。在模型架构上,SmolVLA结合了Transformer及flow-matching解码器,并採用4种技术,包括加速视觉模型推理速度:在视觉模型中跳过一半层数,以加速推论并缩小模型;交错融合自注意力(self-attention)与交叉注意力(cross-attention)区块,以强化多模态讯息整合效率;使用较少的视觉token提升处理速度;并选用更轻量的SmolVLM2来预训练,降低硬件需求。

即便训练集仅包含不到3万笔任务纪录,远少于其他视觉语言代理(VLA)模型,但Hugging Face说,SmolVLA在模拟与实体场景中的表现仍与大型模型相当,甚至超越。

此外,SmolVLA引入非同步推理架构(asynchronous inference stack),将感知(视觉与听觉理解)与动作执行解耦,有利于让机器人在环境快速变化时更迅速做出反应,有效提升机器人的实用性。

最后训练出的SmolVLA-450M可执行在搭载消费级GPU的硬件甚至MacBook上。而搭配SmolVLA-450M的机器人,则包括Hugging Face自己的平价机器人机型,如SO-100、SO-101、LeKiwi等。

而在标竿测试中,Hugging Face强调SmolVLA效能表现优异,其中在LIBERO、Meta-World模拟标竿测试中结果优于更大的模型,如Octo、OpenVLA,而在实际机器人SO100和SO101的抓取与放置、堆叠、分类的能力测试中,以SmolVLA的效能较好,而在SO101,SmolVLA也表现更好的泛化(generalization)能力。而非同步推论将执行和推论解耦,可使机器人在移动时反应更快,该公司强调支援提升30%速度及2倍的任务输出。

SmolVLA基础模型在Hugging Face平台释出。训练方法则在GitHub公布。