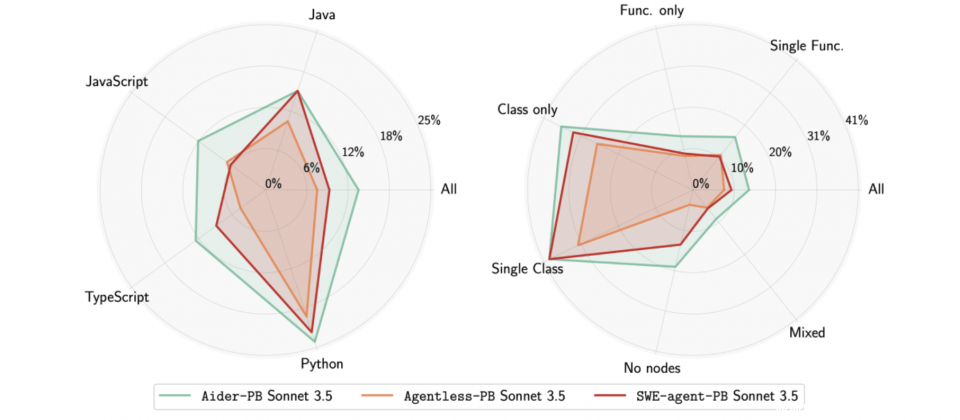

三款人工智慧程序代理模型于SWE-PolyBench测试基準中的表现比较。左图显示各模型在Python、Java、JavaScript与TypeScript四种语言的平均通过率,右图则比较在不同语法结构任务下的处理能力,包括仅修改单一类别、函式、混合节点或无节点等类型。

AWS宣布推出新测试基準SWE-PolyBench,目的是评估人工智慧程序代理人在多语言环境下,处理真实世界开发任务的能力,涵盖Python、Java、JavaScript与TypeScript四种主流语言,并透过複杂程序码修改情境,验证代理人在跨文件、跨类别的程序码导航与理解能力。

SWE-PolyBench测试基準由2,110笔实际GitHub Issue与PR(Pull Request)资料所构成,并包含一组500笔的实验子集SWE-PolyBench500,方便快速迭代测试,期望弥补现有SWE-Bench测试集偏重Python与除错任务的侷限。

SWE-PolyBench强调实务导向的任务设计,任务类型涵盖错误修正、新功能开发与程序码重构,不侷限于单一问题类型或语言,能更準确模拟人工智慧代理人,在实际开发环境的应对表现。该基準不仅提供传统的通过率统计,也新增文件层级与语法树节点层级的定位指标,进一步量化模型能否能準确找出需要修改的文件、类别与函式。

根据AWS团队的初步实验结果,现有多数开源人工智慧程序代理人仍以Python为主要强项,面对需要修改三个以上文件,或牵涉多类型语法结构的任务,表现明显下降。以Aider-PB、Agentless-PB与SWE-agent-PB三种针对多语言测试环境所调整的模型版本为例,在JavaScript与TypeScript任务的平均通过率仍低于15%,表示目前主流模型训练资源集中于Python,尚未能充分学习其他语言的程序结构特性。

AWS团队表示,SWE-PolyBench是一套跨语言、具高複杂度的人工智慧程序代理测试资料集,现已于Hugging Face开源,搭配完整程序码储存库,供研究者与开发者快速评估与比较不同人工智慧模型表现。