AWS今年度主力AI产品策略锁定生成式AI,比如去年上线的生成式AI平台Amazon Bedrock,今年就根据GAI带来的AI代理管理需求,新添多代理协作预览版功能。

「生成式AI(GAI)将成为每个应用程序的核心!」AWS执行长Matt Garman在今年度re:Invent大会中如此直言,揭露了AWS年度战略的一大重点:生成式AI。他更在主题演讲中,花了超过一半的时间,在说明AWS AI平台服务如何为生成式AI设计新功能。

?GAI平台亮点1? 上架市集,还有蒸馏功能加速开发

以去年正式上线的生成式AI平台Amazon Bedrock为例,这款平台专为生成式AI设计,提供基础模型选用、测试、算力支援以及各类工具,来让使用者将模型整合到应用程序、部署到正式环境。目前有数十万家组织在使用它。

今年,这款平台进一步延伸,从基础模型选择、提示管理,到RAG和大模型幻觉避免等生成式AI的热门议题,都有亮点更新。

首先是正式上架的Amazon Bedrock Marketplace市集,提供了100多个热门的基础模型,来让使用者测试和部署。这些模型种类多元,有特定领域的专用模型,像是用于蛋白质研究的ESM3模型,也有通用的基础模型,如来自Meta、Anthropic的语言模型。

而且,这个市集还提供单一介面,来让使用者直接存取专用和通用模型,不必再自己建立抽象层和複杂的安全层等複杂工作。

除了基础模型有更多选择,AWS还锁定建模需求,在Amazon Bedrock新添了预览版的模型蒸馏功能,能将大模型知识快速转移到小模型上,缩短模型开发时间、降低成本。

这个功能的特点是,使用者就算不具备机器学习专业知识,也能给定範本提示,来让系统产出较小的蒸馏模型。这个新功能适用于多种模型,来自Anthropic、Meta和Amazon自己在大会中新发布的Nova系列模型都可以。

?GAI平台亮点2? 更有效管理提示成本

随着生成式AI深化企业工作流程,如何控管提示成本,也成为一大问题。看準这波需求,AWS今年在Amazon Bedrcok中推出提示快取(Prompt caching)预览版新功能,可对提示进行快取,要是侦测到重複输入的提示,就能快取同部分的答案,减少提示重複出现所产生的Token成本。

也就是说,企业建立的GAI聊天机器人,有多位使用者在提示中询问同样问题时,Amazon Bedrock就能快取该部分的答案。因此,这部分问题只会处理一次,还能在每次有人想要询问相关问题时,重複使用,减少了模型每次需要处理的资讯量。

AWS资料与人工智慧资深副总裁Swami Sivasubramanian甚至形容:「这是降低延迟和节省成本的关键,可以降低85%延迟、节省90%成本。」

还有另一款管理提示成本的预览版新功能是智慧提示分配(Bedrock Intelligent Prompt Routing)。这个功能很特别,使用者配置后,它能根据提示内容,自动将提示分配给最适合且兼顾成本的模型来回答问题。这个方法,在不影响準确度的情况下,最高可节省3成成本,开发者也不必再花大量时间,测试哪些模型最适合回答特定问题。

?GAI平台亮点3? RAG支援结构化和多模态资料了

在正式场景运用生成式AI,最怕的就是答非所问。为约束生成式AI不乱回答,检索增强生成(RAG)成为一种主流方法,靠外接资料库,来让大型语言模型(LLM)在其中搜寻、产出答案,降低幻觉发生。

先前,AWS就推出相关服务来支援RAG,比如Amazon Bedrock Knowledge Bases知识库,能用来简化RAG工作流程管理。又或是Amazon Kendra,能利用机器学习预测,来让使用者更容易在企业或组织中找到所需的正确资料。

这次,AWS瞄準RAG所需的资料类型,分别祭出Bedrock Knowledge Bases的结构化资料检索功能,以及能自动从非结构化的多模态资料中抽取内容,来转换、生成结构化资料的Amazon Bedrock Data Automation预览版资料自动化功能。甚至还有支援图学检索的Bedrock Knowledge Bases GraphRAG预览版功能,使用者可以打造使用知识图谱的GAI应用程序了。

不只如此,AWS还扩大了RAG可参考的资料来源,一併推出Kendra GAI Index预览版,使用者能连结40多个资料来源、对其索引,来打造更好的数位助理和智慧搜寻体验。

?GAI平台亮点4? 多代理协作

同样是避免生成式AI幻觉,除了RAG,AWS今年还在Amazon Bedrock中新添另一项自动推理(Automated Reasoning)检查功能预览版,可以检测模型产出的答案是否符合逻辑。Matt Garman还透露,AWS自己有许多服务,就用自动推理功能来检查产出结果,像是S3、程序码检查工具Amazon Codeguru等。

生成式AI的兴起,也带动了AI代理(Agent)应用。也就是说,一项任务可拆解为好几个步骤,这些步骤可由几个AI代理来执行。但任务越複杂,比如涉及数百个、上千个变数的财务分析,就需要大量AI代理来分工执行,这种多代理的管理、调度难度也就越高。

所以,AWS今年在既有的Bedrock Agent代理功能中,进一步新添多代理管理协作功能预览版,使用者可用来建置、部署和管理多个AI代理,来共同执行複杂的多步骤任务,不必再写複杂的程序码。

?GAI助理亮点1? 协助IT现代化

AWS另一项AI主力产品,是去年新上线的生成式AI助理Amazon Q。这个助理分为Q Developer和Q Business两种,分别能用AI代理,来处理程序开发和企业知识管理任务。

今年,这两款助理各有重大突破,特别是Amazon Q Developer。

Matt Garman在大会上先卖关子,今年中,Amazon自己就用Q Developer来升级内部Java程序至Java 17,不只省下大把的人工转换时间,还因为提早使用了现代化Java程序,进而省下年度2.6亿美元的IT成本。

于是他们思考,Q Developer能否也加速其他IT现代化工作,而不只让AI助理辅助简单的程序开发任务。他们找上不少企业资讯长,详谈IT现代化痛点,最后锁定3个领域,打造出Q Developer转换新功能,来协助IT现代化。

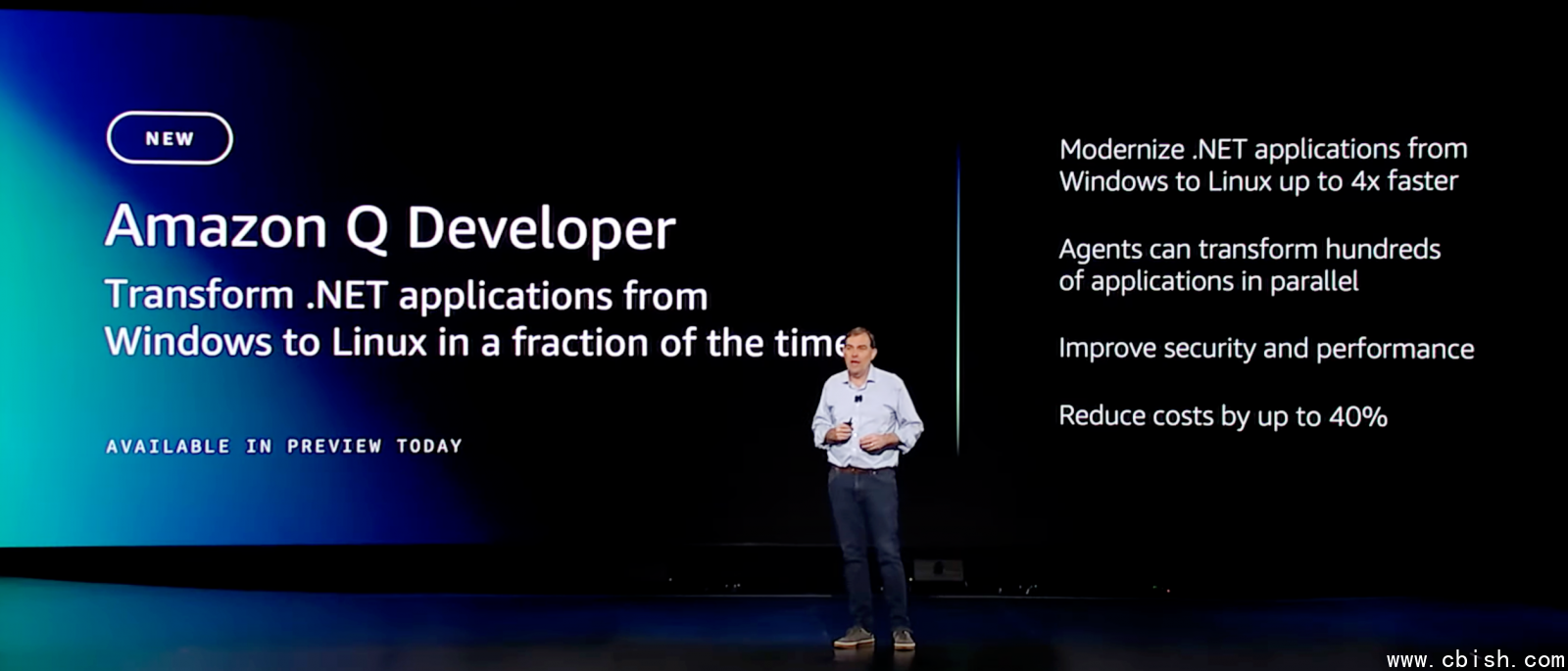

第一个转换新功能是,将Windows.NET程序转换为Linux作业系统相容的版本。为何这件事对企业很重要?

因为,Windows.NET是2002年推出、只在Windows作业系统执行,但不再积极更新的框架。而2016年,一款开源的跨平台.NET框架出现了,可在Linux作业系统上执行,轻量且效能更好。它还会定期更新,每年都会释出新功能和效能改进。

因此,将.NET应用程序从Windows转换到Linux版本,不只能使用最新功能,还能减少微软的授权费用支出。

而Q Developer的AI代理,会自动分析、找出不相容和效率低下的.NET程序码,产出转换计画并执行,重写有问题的原始程序码。Q Developer的AI代理还能「同时处理数百甚至上千个应用程序,」Matt Garman强调,转换时间能得到4倍加速,使用者还能省下40%的许可费用。

他甚至举例,欧洲一家数位交易大厂Signaturit是这项功能的早期合作伙伴,他们原本打算用6到8个月,来将.NET程序转换为Linux版本。但有了Q Developer的.NET转换功能协助,短短几天就完成了。

AWS另一款AI主力产品Amazon Q生成式AI助理,还可分为Developer和Business两种。前者专门由AI代理执行程序开发相关任务,在今年新添了将Windows.NET转换为Linux版本的现代化功能。

另一个新功能是将VMware虚拟机器工作负载转换到Amazon EC2云原生环境中。这个功能,由Q Developer的AI代理自动侦测程序相依性,评估状况后会产出初始搬迁计画,包含发现资料、应用程序分组、网路迁移和服务器搬迁等步骤。

过程中,AI代理会将本地端的VMware配置转换为AWS同等配置,并视情况动态调整搬迁计画。相较于纯人工转换所需的几个礼拜,Q Devloper几个小时就能完成。

第三个新功能锁定大型主机现代化。这是一个让许多企业头痛的大麻烦,Matt Garman直言,大型主机是目前为止最难搬迁上云的複杂系统,甚至,当他与客户企业讨论时,「光是分析、记录和规画大型主机现代化,就要耗费大量精力,很多人因此放弃。」

于是,AWS看準这个痛点,推出Q Developer大型主机现代化转换功能,来将老旧的大型主机COBOL程序码转换为Java,加速原本人工吃重的工作。首先,Q Developer的AI代理会自动分析程序码,接着规画现代化流程,将庞大的单体架构拆解为较小的业务领域,并重写为Java程序码。在这个过程中,AI代理还会针对COBOL程序码,产出文件记录,让使用者知道程序码的作用,有助于应用程序现代化的决策。

「很多企业客户都认为,大型主机转换至少要3到5年,」Matt Garman话锋一转:「根据早期客户和内部测试,我们认为Q可以将多年的大型主机现代化工作,减少为多季度的工作,将转换时间减少50%以上。」这是个非常可观的加速。

另一项Amazon Q助理的新亮点是IT现代化,能自动分析大型主机程序码,还能自动产出文件纪录、生成转换计画并执行。根据AWS早期测试,可将数年的IT现代化工作缩短为几个季度。摄影/王若朴

这些IT现代化功能,目前皆为预览版。

除了协助IT现代化,AWS今年也替Q Developer增添其他功能,比如正式上线的3款AI代理功能,分别能自动产生和套用单元测试、产出準确的程序码文件,以及自动进行程序码检查。又或是可自动侦测AWS环境问题的预览版功能,使用者不必在不同的AWS监测工具中来回切换了。

?GAI助理亮点2? 整合更多资料和自动化

有别于程序开发,Amazon Q Business是一套企业知识管理GAI助理,能整合企业内部各类系统、AWS系统和第三方系统等40多个资料来源,来执行日常任务和资料查找等任务,也能像是商业智慧(BI)工具般,分析业务表现。就连Amazon自己的销售团队,也用Q Business来进行10万多个帐号摘要。

在这个基础上,为让使用者更方便进行BI分析,AWS这次将自家BI工具Amazon QuickSight和Q Business助理整合,就算使用者用的是Q Business建立的应用程序,也能查看BI工具提供的视觉化图表等内容。

不只是资料内容的整合,AWS还进一步扩大整合的资料来源範围,使用者可授权独立第三方厂商(ISV)的应用程序,透过API取用Amazon Q建立的索引(Index),来存取既有的其他应用程序资料,强化ISV应用程序的GAI体验。

再来,Q Business本身就有一些可执行的「动作」(Action),来让使用者在日常应用程序中採取,来简化工作流程,比如在Jira中建立问题。现在,AWS扩大这个动作库,新添了50多个动作,来简化使用者操作第三方生产力应用程序的工作流程,比如可以自动化操作Google Workspace、微软365、Smartsheet等程序。

甚至更进一步,AWS还为Q Business助理,新添了自动化执行複杂工作流程的功能,由AI代理分工执行,像是发票处理、管理用户票证和新员工入职手续等工作。

?SageMaker亮点1? 更贴切的运算资源管理

另一方面,AWS发展多年的传统AI平台工具Amazon SageMaker,在今年大会中也有重大更新,首先是模型训练的运算资源控管。受生成式AI影响,模型将越来越大,模型训练的运算资源也需要更细緻的管控,因此AWS在全託管的AI开发部署和维运平台Amazon SageMaker AI中,推出几款新功能。

第一款是在其下的运算资源管理工具SageMaker HyperPod中,新添30款精心调整过的开源模型供存取。如此一来,使用者可在几分钟内快速使用Llama3.2 90B、Llama 3.1 405B和 Mistral 8x22B等热门模型,降低入门门槛,不必耗费几周的时间,来自己迭代测试、优化模型训练效能。

另一款新功能是自动化弹性支援模型训练的计画功能(SageMaker Hyperpod Flexible Training Plans),能自动设置模型训练所需的基础设施和运算丛集,而且符合使用者预期的训练时间和成本。

还有一款是任务治理新功能(SageMaker Hyperpod Task Governance),使用者能定义自己的优先任务,来最大化运用加速器运算资源,降低模型训练、微调和推论的成本。

不只如此,AWS这次还进一步扩大SageMaker生态系,只要是AWS合作伙伴的AI应用程序,比如Comet、Deepchecks、Fiddler和Lakera Guard等,都能直接供使用者在SageMaker中直接使用这些程序,不必再将资料移出安全的 AWS环境,减少在不同介面间来回切换的时间成本。

?SageMaker亮点2? 整合工具新定位

AWS今年给予旗下AI开发部署平台Amazon SageMaker新定位,集结AWS各种资料处理工具、分析工具和AI工具,成为一套统一的AI平台。摄影/王若朴

另一方面,AWS发展多年的传统AI平台工具Amazon SageMaker,在今年年会中有了新定位,成为一套集结资料处理、分析应用和AI工具的统一大平台。

Matt Garman点出,这个设计,是为了使用者能更好地打造AI分析应用,在单一平台就能找到所需工具,不必在不同工具间来回切换。

在这个新定位下,首先亮相的新功能是Unified Studio统一工作室预览版,整合了AWS自家多种工具,包括SQL分析(Amazon Redshift)、资料处理(Amazon EMR、AWS Glue和Amazon Athena)、机器学习(Amazon SageMakerAI)、串流(Amazon MSK、Amazon Kinesis)和商业智慧(Amazon QuickSight)等,甚至连主力的生成式AI平台Amazon Bedrock,也纳入其中,使用者在单一平台就能存取,用来打造AI分析应用。

AWS对SageMaker的统一策略还不只这一个。他们还针对AI分析必不可缺的资料,进行整合,推出Amazon SageMaker Lakehouse资料湖仓,也就是一套能存取散落在各处的资料的统一平台。

使用者可在平台上,存取跨Amazon S3储存服务、Amazon Redshift资料仓储服务或其他来自上述Unified Studio平台的资料。尤其,这个Amazon SageMaker Lakehouse还与Iceberg开源资料表格式相容,可打破数据孤岛、让资料更容易用于AI或ML分析。

当然,集结了这么多资料来源和工具,也需要相对应的存取权限管理工具,来把关资料安全。因此,Matt Garman也在年会上揭露一款治理工具Amazon SageMaker Catalog,管理者可用来设定细緻的资料、模型等存取权限。

?Amazon Nova六款基础模型亮相?

Amazon执行长Andy Jassy在今年度AWS re:Invent大会中,不仅揭露6款Nova系列模型,还透露明年要推出语音到语音、多模态到多模态等更强大的Nova模型。图片来源/AWS

在今年度AWS re:Invent大会中,Amazon执行长Andy Jassy亲自登场,揭露了6款自行研发的Nova系列基础模型,包括Nova Micro、Nova Lite、Nova Pro、Nova Premier,以及用来生成高品质图像的Nova Canvas和生成高品质影片的Nova Reel。

进一步来说,Nova Micro是一款只处理文字的模型,能以极低的延迟和成本给出回答。Andy Jassy说明,这款模型在11项基準测试中,表现媲美Meta的Llama 3.1 8B甚至更好。Nova Micro不只支援128K Token的输入长度,每秒还可输出210个Token,非常快速,适合需要迅速回应的应用场景。

再来,Nova Lite是一款多模态模型,主打快速处理图像、影片和文字输入。与OpenAI的GPT-4o mini相比,它在19项文字基準测试中,有17项表现持平或更好。

Nova Pro则是功能更强大的多模态模型,兼顾準确性、速度和成本,适合处理多种任务。至于Nova Premier,则是Amazon所谓的顶级多模态模型,专为複杂推论任务而生。

特别的是,Nova Micro、Lite和Pro等模型支援200多种语言,其中Nova Lite和Pro还支援300K Token的上下文长度,影片处理时长更能达到30分钟。Andy Jassy预计,2025年初,Amazon将支援超过200万Token的上下文长度。

目前,Nova Micro、Nova Lite和Nova Pro已在生成式AI平台Amazon Bedrock上正式可用,Nova Premier预计在2025年第一季上架。

这些模型除了效能好,还很划算。AWS说明,Nova Micro、Lite和Pro在各自的类别中,使用成本比Amazon Bedrock中表现最佳的模型至少便宜75%,同时也是Amazon Bedrock中对应类别中,速度最快的模型。甚至,使用者还能客製化微调,或是使用蒸馏方法,来将大模型的知识快速转移到小模型上,亦能採用RAG,来优化模型表现。

另一方面,Nova Canvas这款模型不只能根据输入文字或图像,产出高品质视觉内容,还提供编辑功能,使用者利用文字输入,就能快速调整图像、控制颜色组合和排版等。这款模型也提供浮水印功能,可追溯每张图像的来源,还会审核内容,以防有害内容出现。

而Nova Reel除了可以文字生成高品质影片,一样也能透过文字输入,来控制视觉风格和节奏,像是镜头移动、旋转和缩放等。

最后,Andy Jassy还透露重磅消息,Amazon预计在明年第一季推出Nova语音到语音模型,也就是能即时根据语音输入,解释语言和非语言讯号(如语调和节奏),来提供接近真人的即时语音互动。

再来,Amazon还在开发Nova多模态到多模态模型,也就是能接受文本、图像、音讯和影片作为输入,并以任意模态生成输出,预计2025年中旬问世。他们认为,这种模型将能简化应用程序开发,光靠同一模型就能执行多种任务,像是内容模态转换、内容编辑,或是驱动能理解和生成所有模态的AI代理。

?相关报导?