NVIDIA在GTC 24春季场发表了具有6大创新的Blackwell架构GPU,不但提供更强悍的效能,更降低25倍总体拥有成本,还能透过先进管理功能缩短伺服器停机时间。

裸晶尺寸达到现今光罩极限

Blackwell是专为资料中心处理生成式AI而设计GPU,它採用TSMC(台积电)4NP製程节点,由2.08兆个电晶体构成,是目前世界上最大型的GPU。其晶片由2组裸晶(Die)所构成,每组裸晶的尺寸达到现今半导体製程中光罩的极限,并透过频宽高达10 TB/s的NV-HBI(NVIDIA High-Bandwidth Interface)晶片对晶片互连(Chip-to-Chip Interconnection)相连,让2组裸晶成为单一晶片并确保记忆体一致性(Coherent),能够共享容量高达192 GB的HBM3e高频宽记忆体。

延伸阅读:GTC 24:Blackwell架构详解(上),全新架构带来5倍效能表现(本文)GTC 24:Blackwell架构详解(下),看懂B100、B200、GB200、GB200 NVL72成员的纠结瓜葛GTC 2024春季场系列报导目录Blackwell在Tensor核心(硬体层面)与TensorRT-LLM、Nemo运算框架(软体层面)协同运作之下支援第2代Transformer引擎,能够加速大型语言模型与混合专家(Mixture-of-Experts)AI模型在训练与推论时的运算效能,并且能够支援包含由社群定义的FP4与FP6资料类型的浮点运算,以及由社群定义的微扩充格式(Microscaling Formats),能够提供高準确度与高吞吐量的运算成效。

全新的Micro-Tensor Scaling技术能够支援动态範围管理演算法(Dynamic Range Management Algorithm)、精细粒度扩充(Fine-Grain Scaling),并支援FP4资料类型运算,且最佳化运算效能与精準度,让Blackwell的FP4 Tensor核心Core能够达到双倍记忆体参数频宽,并让GPU能够容纳双倍尺度的AI模型。

?

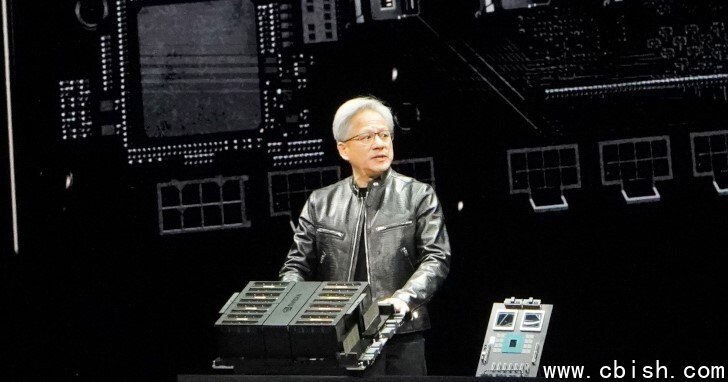

▲ NVIDIA创办人暨执行长黄仁勋在GTC 2024春季场开幕演说中展示Blackwell GPU(左)以及前代Hopper架构的H100,可以明显看出2者的尺寸差异。

▲ NVIDIA创办人暨执行长黄仁勋在GTC 2024春季场开幕演说中展示Blackwell GPU(左)以及前代Hopper架构的H100,可以明显看出2者的尺寸差异。

▲ Blackwell GPU本体由提供多种2.08兆个电晶体构成,是目前世界上最大型的GPU并提供多种先进平台功能。

▲ Blackwell GPU本体由提供多种2.08兆个电晶体构成,是目前世界上最大型的GPU并提供多种先进平台功能。

▲ GB200 Superchip上具有2组Blackwell GPU,可以看到Blackwell GPU晶片是由2组裸晶构成。

▲ GB200 Superchip上具有2组Blackwell GPU,可以看到Blackwell GPU晶片是由2组裸晶构成。

▲ Blackwell GPU在FP8资料类型的运算效能为Hopper的2.5倍,若改用新的FP4资料类型则可达到5倍运算效能。

▲ Blackwell GPU在FP8资料类型的运算效能为Hopper的2.5倍,若改用新的FP4资料类型则可达到5倍运算效能。

▲ 与先前Pascal架构相比,Blackwell在8年内达到超1,000倍的效能提升。

▲ 与先前Pascal架构相比,Blackwell在8年内达到超1,000倍的效能提升。

▲ 根据NVIDIA提供的数据,Blackwell架构的GB200 NVL72能带来30倍于前代HGX H100的大型语言Token输出效能。

▲ 根据NVIDIA提供的数据,Blackwell架构的GB200 NVL72能带来30倍于前代HGX H100的大型语言Token输出效能。

▲ 在1.8T GPT MoE模型的训练部分,GB200 NVL72具有4倍于HGX H100的表现。

▲ 在1.8T GPT MoE模型的训练部分,GB200 NVL72具有4倍于HGX H100的表现。

强化伺服器竞争力

Blackwell GPU也加入了许多专为企业与资料中心应用设计的功能,例如RAS引擎(Reliability, Availability,and Serviceability Engine,可靠性、可用性和可维护性引擎)会透过完整的自我检查机制搭配由AI驱动的大数据分析,预测系统中可能会出状况的检查点(Chickpoint),让维护团队可以即早处理,或是在非不得以需要关机时,也可以安排在冲击最小的时间简进行维护,大幅缩短伺服器的停机时间(Downtime)。

NVIDIA也将机密运算(Confidential Computing)功能由CPU推广至GPU,扩大可信任执行环境(Trusted Execution Environment,TEE)的範围,让Blackwell 成为首款支援TEE-I/O的GPU,能够提供更快、更安全、可证明(Evidence-Based Attestable)的资安保护,并且提供几乎等同于未加密模式的资料吞吐效能,让客户能够确保AI智慧财产权,并确保机密AI训练、推论理与联邦学习(Federated Learning)的安全性。

为了提高资料传输的效率,NVIDIA也一改传统资料分析和资料库运算负载透过CPU处理资料缓慢又繁琐的流程,让Blackwell GPU加速支援包括Apache Spark在内的资料库框架,并内建解压缩效能高达800 GB/s的解压缩引擎,并支援LZ4、Snappy、Deflate等最新压缩格式,全面加速资料库查询(Database Query)管线效能。

Blackwell GPU搭配频宽高达8 TB/s的HBM3e高频宽记忆体以及透过NVLink-C2C互连技术连接至Grace CPU,可以提供18倍于传统CPU或6倍于前代H100 GPU的查询效能测试(Query Benchmark),达成资料分析和资料科学(Data Science)的最高运算效能。

上述的效能、运算密度、电力效率、RAS改善,对伺服器的成本都有正面帮助,另一方面NVIDIA也在Blackwell世代积极推动从空冷转换到水冷的散热方案,透过散热工作液体循环于机架内的CPU、GPU等高温元件以及外部散热器(Radiator,功能等同于个人电脑水冷系统的散热排),进一步降低机房空调的能源消耗。

整体而言,在执行万亿组参数的AI模型条件下,採用水冷方案的GB200能较採用空冷的H100降低25倍总体拥有成本(Total Cost of Ownership,TCO),对于资料中心来说相当有吸引力。

▲ GB200 NVL72在TCO与电力消耗部分的表现优于HGX H100约25倍。

▲ GB200 NVL72在TCO与电力消耗部分的表现优于HGX H100约25倍。

▲ 受益于特化架构与解压缩引擎的优势,GB200 NVL72在资料库查询的效率校传统x86架构系统高出18倍。

▲ 受益于特化架构与解压缩引擎的优势,GB200 NVL72在资料库查询的效率校传统x86架构系统高出18倍。

Blackwell GPU不但是目前最强的AI加速运算单元,而且还可透过串接多组GPU方式进行水平式扩充(Scale Out),大幅强化总体效能与吞吐量,笔者将于下篇文章进行详细说明。

(回到GTC 2024春季场系列报导目录)