40B参数碾压百倍大模型?中国团队凭“小模型”杀出AI代码赛道

当全球科技巨头还在比拼参数规模、算力堆叠时,一支来自中国的低调团队,用一个只有400亿参数的代码模型,硬生生在多个权威编程基准测试中击败了Claude Sonnet 4.5、GPT-5.1等百倍于它的“巨无霸”模型。

这不是科幻小说,而是真实发生的行业震荡。发布者是Quest Research——背后站着中国头部量化对冲基金九坤投资(UBIQUANT)。他们没有选择跟随主流的“越大越好”路线,而是用一套近乎偏执的工程优化和训练策略,重新定义了“高效AI编程助手”的标准。

数据说话:小模型,大爆发

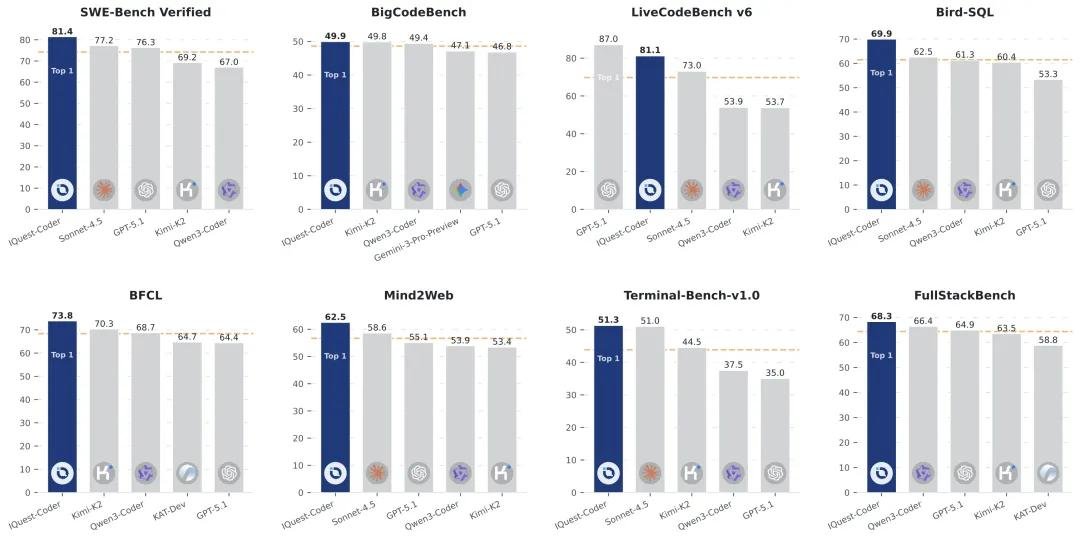

IQuest-Coder 在三个被业界广泛认可的硬核基准中表现惊人:

- SWE-Bench Verified:81.4% —— 比Claude Sonnet 4.5高出近5个百分点,意味着它能更稳定地解决真实开源项目中的复杂Bug修复任务;

- BigCodeBench:49.9% —— 在涵盖多种编程语言和复杂逻辑的综合编码测试中,超越了GPT-4o和Gemini 1.5 Pro;

- LiveCodeBench v6:81.1% —— 在实时竞技编程场景中,表现接近人类顶尖选手水平,远超同规模模型。

这些不是实验室的“水军数据”,而是公开可复现的评估结果。更令人震惊的是,IQuest-Coder 40B 的参数量,仅为Claude Sonnet 4.5(约500B)的1/12,GPT-5.1(传闻超800B)的1/20。它没有靠“烧钱”取胜,而是靠“聪明地设计”。

双轨制设计:一个模型,两种用法

IQuest-Coder 并非“一刀切”的通用模型,而是精心设计了两种形态,适配不同使用场景:

Thinking 模型:专为复杂系统开发打造。它不急于输出代码,而是像资深工程师一样,先拆解问题、分析依赖、评估风险,再逐步生成解决方案。输出虽然长,但每一步都可追溯、可验证。在GitHub上处理跨文件重构、API迁移这类任务时,它的“思考过程”甚至被开发者称为“像在和一个懂行的同事对线”。

Instruct 模型:面向日常开发效率。响应速度提升40%,上下文利用率更高,能快速完成函数补全、注释生成、单元测试编写等高频任务。很多团队已将其接入VS Code插件,作为“24小时在线的Senior Dev”使用。

原生支持128K上下文:不靠“魔改”,直接打通长代码脉络

当前主流模型要支持长上下文,往往需要RoPE插值、FlashAttention优化、外挂记忆模块等“补丁式”技术,不仅复杂,还容易出现注意力坍塌、信息丢失。

IQuest-Coder 的团队选择了一条更难的路:从底层架构开始,重新设计注意力机制与位置编码。结果是——原生支持128K tokens,无需任何额外调整。

这意味着什么?你可以直接把一个完整的Python项目(含100+文件)拖进去,让它理解整个工程结构、模块调用关系、历史提交记录,然后精准定位问题根源。这对企业级代码审查、遗留系统重构、多服务协同调试,是革命性的提升。

Loop变体:用循环推理,把部署成本砍掉一半

最让开发者眼前一亮的,是他们推出的“Loop”版本。

传统模型每一步推理都重新计算,消耗巨大。Loop模型则引入了“共享参数的循环推理”机制——在处理复杂任务时,模型会像人一样“反复推敲”,但不是每次都从头算,而是复用中间状态,用更少的计算资源完成更高质量的输出。

实测显示,在保持推理质量不变的前提下,Loop版本的推理延迟降低52%,显存占用减少48%。这意味着,即使你只有1-2张A100,也能流畅运行40B级模型,做生产级部署不再是“土豪游戏”。

开源全家桶,即刻可用

Quest Research 没有藏着掖着。IQuest-Coder 全系列已在 Hugging Face 开源,包含:

- 三个规模:7B / 14B / 40B

- 四种版本:Base / Instruct / Thinking / Loop

所有模型均支持 Apache 2.0 协议,可商用、可修改、可部署。开发者无需申请权限,直接下载即可。

更贴心的是,团队提供了完整的 vLLM 部署脚本,一键启动 OpenAI 兼容的 API 服务,你甚至可以把它当成 GPT-4 的平替,接入你的内部工具链、CI/CD 流水线或客服机器人。

项目地址:https://github.com/IQuestLab/IQuest-Coder-V1

为什么这次不一样?

过去几年,AI编程模型赛道被OpenAI、Anthropic、Meta牢牢掌控,人们默认“只有大厂能做出好模型”。但IQuest-Coder证明了一件事:在AI工程化时代,**算法创新 + 领域深耕 + 工程极致**,足以打破巨头垄断。

九坤投资的背景不是偶然。作为中国最顶尖的量化基金之一,他们每天处理PB级金融数据、运行数万条交易策略,对“效率”“稳定”“低延迟”有着近乎病态的追求。这种基因,被完整移植到了AI模型设计中。

这不是一场“逆袭”,而是一次“降维打击”——用金融工程的思维,做AI模型的精密优化。

如果你是开发者、技术负责人、AI产品经理,或者只是想看看“中国团队还能不能做出真正硬核的东西”,现在,是时候亲自试试 IQuest-Coder 了。