Kling 正式发布 Video o1:一个输入框,搞定整个视频创作

你是否曾为剪辑一段视频而打开五六个软件?先用AI生成画面,再用PR抠图,接着用After Effects调光效,最后还得手动对齐关键帧……繁琐到想放弃?Kling 正式推出“统一视频创作引擎”Video o1,彻底打破这一传统链条——你不再需要切换工具、学习复杂操作,只需在输入框里打几行字,就能从一个念头,直接生成一条完整、连贯、高质量的视频。

不靠鼠标,靠语言:像聊天一样剪视频

Video o1 的核心,是“语义理解 + 一致生成”。它不是简单的“文字转视频”,而是真正理解你说了什么,并能精准执行。

比如:

- 输入“去掉路人,把白天改成黄昏,衣服换成红色风衣”,系统会自动识别画面中的人流、光影变化和服装结构,一次性完成三重修改,无需手动遮罩或帧对帧调整。

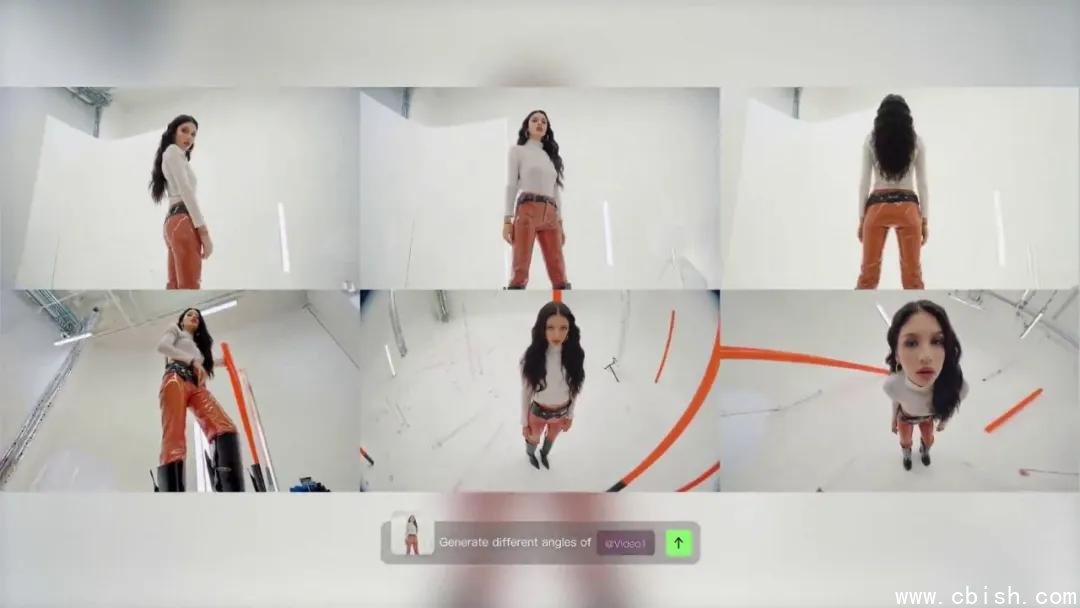

- 上传一张角色照片,说“让他转身走路,背景换成东京雨夜”,Video o1 不仅能生成自然的动作,还能保持角色面部特征、体型比例在全段视频中高度一致——哪怕镜头拉远、光线变暗,也不会“变脸”或“变形”。

- 你给一段10秒的开场镜头,说“按这个节奏续写3秒,结尾加个烟花”,它会分析镜头运动、节奏、色彩情绪,自动生成衔接自然的后续内容,像专业剪辑师一样“懂氛围”。

这些操作,过去需要专业团队数小时完成,现在只需30秒输入。没有时间轴,没有图层,没有插件——一切都在一个输入框里解决。

不止是改画面,还能“导演”整部短片

Video o1 的突破,不止于局部修改,更在于它能理解“叙事逻辑”。

你可以:

- 用参考图控制多个角色:上传三张不同角色的头像,要求“三人并肩走过街道,镜头从左扫到右”,系统能同时识别并稳定保持三人外貌、服装、动作关系,哪怕镜头旋转或变焦。

- 一键改变场面调度:说“把俯拍改成低角度跟拍”,它会重新生成符合物理规律的镜头运动,连影子方向都自动修正。

- 用开头/结尾帧控制叙事:你提供一张“清晨空荡街道”的起始帧和一张“夜晚霓虹闪烁”的结束帧,系统会自动生成中间的过渡剧情——人物出现、车辆驶过、天气变化,全部符合时间逻辑。

- 文本直接生成画面:输入“一个女孩在图书馆翻书,窗外雷雨交加,书页被风吹起”,Video o1 不仅生成画面,连风的动态、雨滴的轨迹、纸张的飘动都符合物理常识。

这不是“AI画画”,这是“AI导演”。它记住的不是单张图,而是角色、道具、环境之间的关系网络。哪怕你中途改了三次背景、换了两次服装,它依然能保持所有元素的连贯性——这正是目前其他模型最薄弱的环节。

性能实测:比Veo 3.1更稳,比Aleph更懂细节

根据Kling内部测试数据(2025年1月):

- 在“图像参考一致性”任务中,Video o1 在角色保持、道具稳定、光影连贯三项指标上,平均领先 Google Veo 3.1 27.3%。

- 在“复杂内容变换”任务中(如多目标同步修改、风格迁移+镜头运动叠加),对战 Runway Aleph,Video o1 成功率高出31.6%,且出错率更低。

这些数据来自真实创作者测试集,涵盖人像、建筑、动态道具、多角色互动等高难度场景。尤其在“多人物同时变更”和“长时序一致性”上,Video o1 显著优于当前主流模型。

3秒到10秒,精准控制每一帧

Video o1 当前支持生成 3~10 秒的高质量视频,专为短视频平台、广告创意、社交媒体内容打造。无论是0.5秒的爆款转场,还是8秒的完整故事闭环,都能按需生成。

未来版本将开放“开头+结尾帧控制”功能,允许你用两张静态图定义完整叙事起止,系统自动填充中间过程——这意味着,你甚至可以只画两张草图,就让AI帮你完成一部微电影。

现在就能免费体验

无需等待内测,无需申请权限。打开可灵App,或访问官网 https://app.klingai.com/cn/,选择“Video o1”模型,上传图片或输入文字,立刻生成你的第一段AI视频。

对创作者来说,这不仅是效率的提升,更是创作自由的解放——不再被工具限制,不再被技术门槛劝退。你只需要一个想法,剩下的,交给Video o1。

下一个爆款视频,也许就从你今天的一条输入开始。