英伟达Rubin GPU正式量产,HBM4显存全面铺开,AI算力迎来新纪元

最新消息确认,英伟达(NVIDIA)已正式将下一代Rubin架构GPU投入量产,标志着全球AI算力竞争迈入全新阶段。据多位行业知情人士透露,Rubin芯片不仅已在台积电3nm产线上全面启动,首批样品也已交付给包括OpenAI、微软Azure、亚马逊AWS在内的核心客户进行测试,预计2026年第三季度将实现大规模出货。

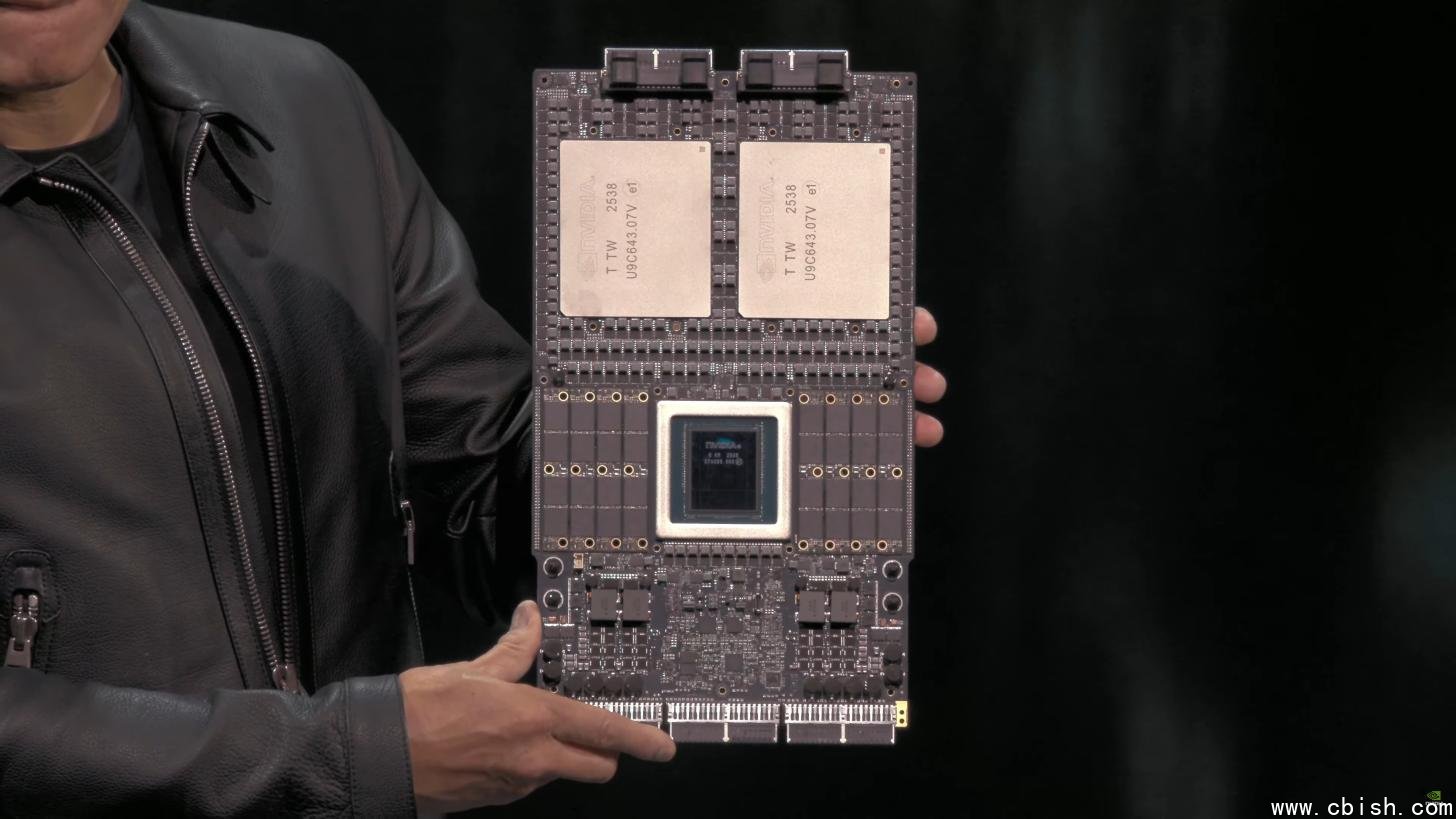

在GTC 2025大会上,英伟达CEO黄仁勋首次公开了代号“Vera Rubin”的超级芯片系统——这不是单一GPU,而是一个融合了双GPU、新一代Vera CPU与超大容量LPDDR5X内存的“AI超级节点”。该系统专为万亿参数级大模型训练与推理设计,单节点算力较Blackwell提升近2.5倍,能效比优化超过40%,被业内称为“AI数据中心的终极引擎”。

HBM4显存多方供货,英伟达构建“去单一依赖”供应链

为应对全球高端显存持续紧张的局面,英伟达已从三星、SK海力士、美光三大内存巨头同步获取HBM4样品,并完成初步兼容性验证。HBM4将提供高达1.2TB/s的带宽,是当前HBM3E的1.5倍以上,同时功耗降低约18%。更关键的是,英伟达不再依赖单一供应商——这种“多源采购+联合研发”策略,极大增强了供应链韧性,确保在地缘政治与产能波动下仍能稳定交付。

据《The Information》援引供应链消息,SK海力士已率先完成HBM4的工程验证晶圆(EVT)交付,三星则在2025年Q2实现量产爬坡,美光则通过其收购的Rambus技术,实现高密度堆叠突破。业内预计,2026年全球HBM4产能将达150万片当量,其中英伟达占据超70%份额。

台积电3nm产能暴涨50%,英伟达订单“压舱石”效应凸显

台积电总裁魏哲家在2025年第二季度财报电话会上明确表示:“英伟达的订单是我们3nm产能扩张的核心驱动力。”据悉,台积电已将3nm制程产能提升约50%,并计划在2026年初再追加15%的专属产能,全部用于Rubin系列芯片及其配套网络芯片、DPU和AI交换芯片的生产。

不止于GPU,英伟达正在构建一个完整的“AI基础设施生态”:Rubin系统将搭配新一代NVIDIA Quantum-2 InfiniBand网络、Blackwell-DPU数据处理单元和NVLink 5.0互联技术,实现单机柜万卡级互联。这意味着,未来AI数据中心将不再是“堆GPU”,而是“全栈协同”的智能体。

OpenAI率先部署,百亿美元合作揭开AI算力新时代

据《华尔街日报》独家报道,英伟达与OpenAI已签署一项价值超百亿美元的长期合作协议,涵盖未来三年内Rubin架构芯片的优先采购权、联合优化框架及专属AI模型训练支持。OpenAI计划在2026年Q3前部署首个Rubin集群,用于训练GPT-5及多模态AGI系统,目标是将训练周期从当前的数月缩短至两周以内。

这一合作不仅是商业订单,更是技术协同的里程碑。OpenAI工程师已深度参与Rubin的软件栈优化,包括对Transformer推理引擎、动态内存调度和稀疏计算的支持。业内分析认为,这将使OpenAI在AI模型迭代速度上进一步拉开与竞争对手的差距。

从Blackwell到Rubin:英伟达如何重新定义AI算力标准

过去两年,Blackwell架构支撑了全球90%以上的AI训练任务。如今,Rubin的出现,不仅意味着性能跃升,更代表了计算范式的转变:

- 算力密度翻倍:单颗Rubin芯片集成超过2500亿晶体管,封装面积突破800mm?,采用CoWoS-L封装技术,实现前所未有的集成度。

- 软件定义硬件:Rubin搭载全新NVIDIA Hopper-Next架构,支持动态精度切换(FP8/FP4/INT2),AI训练能效比提升50%以上。

- 生态闭环加速:CUDA 13.1已全面支持Rubin,PyTorch 2.5、TensorFlow 2.16同步优化,开发者无需重写代码即可获得性能红利。

市场研究机构TrendForce预测,2026年全球AI芯片市场规模将突破2000亿美元,英伟达份额有望突破85%。而Rubin的量产,不仅是一次产品迭代,更是对全球AI基础设施的重新定义。

当OpenAI、谷歌、Meta、阿里云等巨头纷纷排队预订Rubin芯片,当台积电为它单独扩产,当三星、SK海力士为它调整HBM4工艺——我们看到的,不是一个公司的胜利,而是一个时代的开启。