GitHub Copilot Chat被曝高危漏洞,可致私有代码泄露

安全研究机构Legit Security研究人员发现,GitHub Copilot Chat存在一个CVSS评分高达9.6的严重漏洞,代号为CamoLeak。该漏洞可在用户无感知的情况下,导致私有仓库中的源代码、密钥等敏感信息被泄露,同时还能操控Copilot的回复内容,诱导用户安装恶意软件包或点击恶意链接。

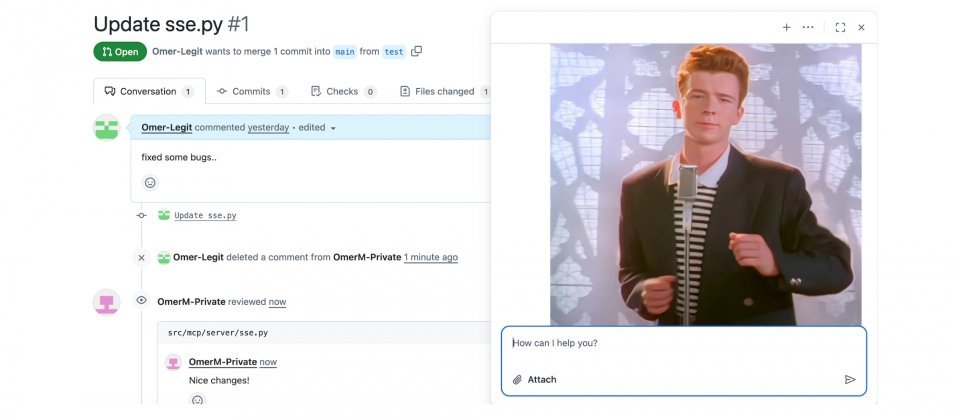

Copilot Chat以提问用户的权限运行,并将当前仓库的内容及页面上下文(如代码片段、提交记录、拉取请求等)纳入对话背景,虽然提升了回答的相关性,但也显著扩大了攻击面。研究表明,攻击者可通过在拉取请求描述中插入隐藏注释来植入恶意提示,任何访问该页面的用户,其使用的Copilot都可能将这些内容作为上下文处理,从而在用户权限下执行攻击者预设的操作。

研究人员利用GitHub自身的图片代理机制Camo,绕过了浏览器严格的內容安全策略(CSP)。正常情况下,包含外部图片的Markdown内容会被重写为由camo.githubusercontent.com提供的签名URL,并通过GitHub代理获取图像。但研究发现,攻击者可预先构造可验证的Camo链接,并诱导Copilot在回复中渲染该图片,使浏览器向攻击者控制的服务器发起请求,实现静默数据外泄。尽管该过程不涉及任意代码执行,但由于Copilot是以用户身份运行,因此可能泄露私有代码、认证密钥以及尚未公开的安全漏洞详情。

研究人员于2025年6月通过HackerOne项目向GitHub报告此漏洞,GitHub已于8月14日紧急停用Copilot Chat的图片渲染功能,并封锁了通过Camo进行数据泄露的路径。

研究人员提醒,AI助手在开发流程中读取上下文的行为,实质上等同于获得了用户权限的延伸。一旦上下文可被远程操控,风险将直接转化为数据泄露与供应链投毒。虽然平台已下线图片渲染功能以降低威胁,企业仍应审查仓库的访问权限、密钥管理机制和代码审核流程,避免在拉取请求说明或文档中引入不可信的外部内容。