谷歌Gemini遭遇史上最大“蒸馏攻击”,10万次提问只为偷走AI大脑

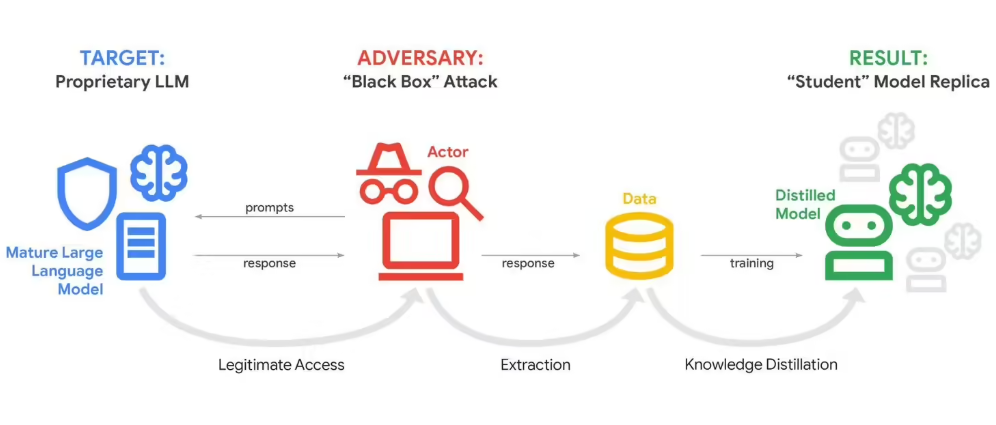

当地时间2月12日,谷歌正式披露,旗下AI聊天机器人Gemini正遭受一场前所未有的系统性攻击。攻击者通过自动化工具,在极短时间内向Gemini发送超过10万条高度重复、精心设计的提问,目的不是搞垮系统,而是想“掏空”它的思考方式——这种手法被称为“模型蒸馏攻击”。

简单来说,攻击者就像一个窃贼,不撬保险柜,而是天天问你:“你早上几点起床?”“你吃早餐吃什么?”“你遇到堵车怎么选路?”问上几万遍,就能把你一天的生活习惯摸得一清二楚,甚至能模仿你说话的语气和决策逻辑。现在,他们用同样的手段,试图复制Gemini的“思维模式”。

谁在背后操作?不是黑客,是竞争对手

谷歌安全团队确认,这次攻击并非普通网络犯罪,而是有组织、有商业目的的行动。幕后黑手很可能是几家正在追赶谷歌的AI初创公司,或是想快速提升自家大模型能力的科技企业。他们不花钱买算力、不雇研究员训练模型,而是直接“抄作业”——用Gemini的回答反向推导出它的训练逻辑、权重结构和推理路径。

攻击源遍布全球,从美国硅谷到东欧的技术实验室,再到亚洲的AI创业公司,都有疑似参与痕迹。但谷歌没有点名任何实体,只表示“涉及多个司法管辖区”,显然顾忌国际关系与法律风险。

谷歌威胁情报主管约翰·霍特奎斯特直言:“这就像煤矿里的金丝雀。我们被盯上了,但下一个被偷的,可能是你公司用的客服AI。”

你的企业AI,也可能正在被“偷”

过去,人们以为大模型的安全问题只关乎巨头。但这次攻击暴露了一个更现实的危机:越来越多中小企业正在用定制化AI处理客户数据、内部流程、销售策略甚至财务分析。这些模型虽然规模小,但藏着公司最核心的“商业智慧”。

一旦被蒸馏攻击得手,一个训练了半年、投入百万成本的客户响应模型,可能在几周内被对手“克隆”出来——连你公司特有的语气、回复节奏、对敏感问题的回避方式,都能被精准复刻。

有安全研究员指出,已有多个中小企业的AI客服系统出现异常:回答越来越“像”某大厂产品,逻辑更流畅,但少了原本的“人味”和个性化。这可能不是升级,而是被悄悄“借鉴”了。

为什么防不住?开放,就是最大的漏洞

谷歌已经部署了多种检测机制,比如限制单用户提问频率、识别异常模式、过滤可疑请求。但问题在于:Gemini是公开服务。你不能因为有人可能偷东西,就不让客户用。

这就像一家餐厅,明明发现有人天天来点菜,记下每道菜的做法,最后回家开了一家一模一样的店——你不能不让他进门,也不能不让他点菜。你只能干着急。

更棘手的是,蒸馏攻击不需要高深技术。一个懂Python的工程师,花几天时间写个脚本,就能自动发起数万次请求。成本低、隐蔽性强、法律灰色地带大——目前全球尚无明确法律禁止“通过公开接口逆向推导AI模型”。

这不是科幻,是正在发生的商业战争

谷歌为训练Gemini投入了数十亿美元,包括海量数据、顶尖人才和数月的算力消耗。而攻击者,可能只花了不到10万美元,就拿到了接近同等能力的“影子模型”。

业内已经开始讨论:未来,AI模型会不会像软件一样,需要“许可证”才能调用?会不会出现“模型水印”技术,让被复制的AI留下不可删除的痕迹?一些公司已经在测试“噪声注入”——故意在回答中加入微小错误,让盗版模型变得不可靠。

但对普通用户和企业来说,最现实的提醒是:别以为你的AI很安全。如果你的企业正在用第三方AI处理客户资料、合同分析或市场策略,问问你的供应商——你们的模型,有没有防“蒸馏”措施?还是说,它正坐在一个敞开的金库前,等着别人来抄作业?