腾讯混元发布2Bit极小模型,手机端也能跑大模型

今天,腾讯混元正式推出一款专为手机、耳机、智能手表等消费级设备打造的超小模型——HY-1.8B-2Bit。别看名字里还有“1.8B”,它实际占用的内存不到600MB,比微信小程序还轻,安装后几乎不占空间。更惊人的是,它在数学推理、代码生成和科学问答这些硬核任务上的表现,和传统4Bit模型基本持平。

过去,大家觉得把模型压缩到2Bit几乎是不可能的事——精度掉得太狠,连基本对话都卡顿。但腾讯混元这次没走老路,没用常见的“训练完再压缩”方法,而是从一开始就用“量化感知训练”,让模型在学习过程中就适应低精度环境。再加上一套自研的数据优化和动态量化策略,硬是把精度损失压到了最低。

不是噱头,实测速度翻倍

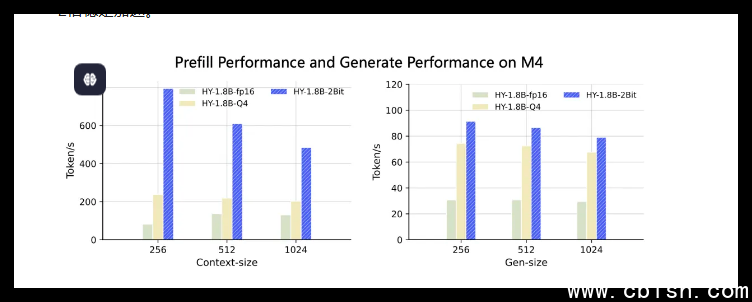

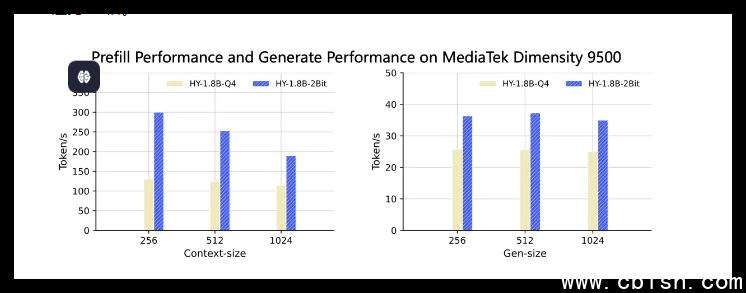

光说“小”没用,关键是跑得快。我们在真实设备上测试了这款模型:

- 在搭载M4芯片的MacBook上,输入1024个字符后,第一个字的响应时间快了3到8倍,整体生成速度稳定提升2倍以上。

- 在天玑9500手机芯片上,相比常见的Q4格式模型,首字延迟缩短近一半,生成速度提升约1.5倍,日常聊天、写短信、做笔记几乎无延迟。

这不是实验室数据,是真机跑出来的结果。而且它不挑设备,安卓、iOS、ARM架构的智能硬件都能跑,连老款中端手机也能流畅使用。

不联网,也能写代码、算数学

最让普通用户心动的,是它完全离线运行。你的聊天记录、私人笔记、工作草稿,全留在本地,不用上传云端。医生能用它快速整理病历要点,学生能在没网的自习室里解题,设计师可以边画图边让模型帮你润色文案——所有操作,零延迟、零隐私风险。

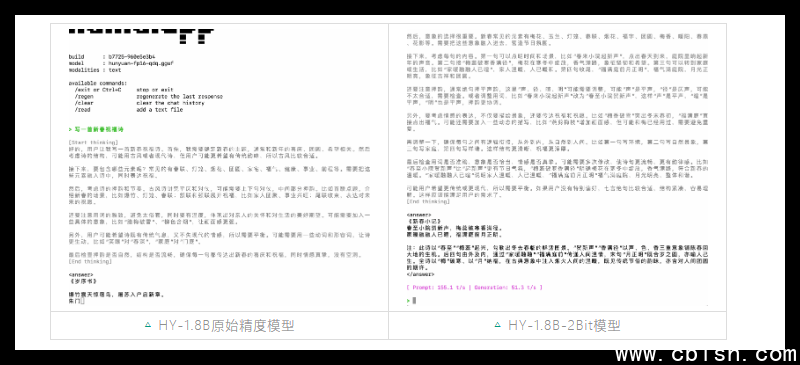

它继承了Hunyuan-1.8B-Instruct的“长思维链”能力,不是只会答简单问题。你问它:“帮我写个Python脚本,自动整理手机相册里去年的照片,按月份分类”,它能一步步拆解,给出完整代码,哪怕你只给了一句话。

现在就能用,未来会更聪明

目前,模型已开放GGUF-int2格式的权重,开发者可以直接下载,在手机App、智能耳机、车载系统里集成。Arm最新SME2指令集也已适配,效率再提一成。

腾讯混元团队透露,下一步会结合强化学习和模型蒸馏,继续提升低比特模型的理解力。未来,你可能不再需要“云AI”——你的手机、手表、耳机,本身就藏着一个能思考、会推理、懂隐私的本地助手。

这不是未来科技,是现在就能装进你口袋里的真实改变。