LongCat-Flash-Lite:更轻、更快、更懂你的代码和命令

过去几年,大模型越做越大,专家数量堆到上千,结果却是推理变慢、成本飙升,效果却没明显提升。美团 LongCat 团队没跟风堆参数,而是回头重新思考:我们真的需要那么多“专家”吗?

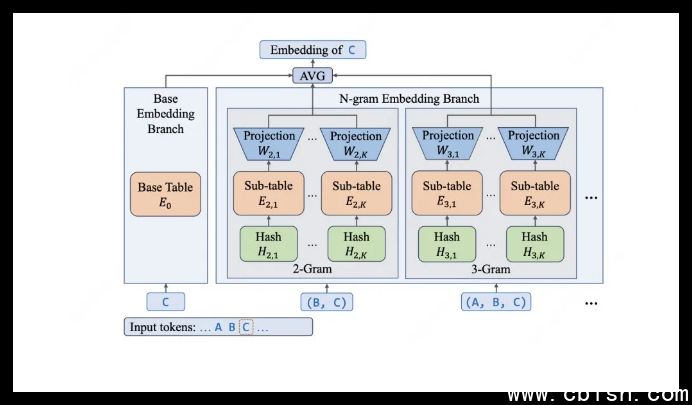

他们找到了一个更聪明的路子——不靠增加专家,而是把语言的“骨架”变得更细密。他们用 N-gram 嵌入层,把常见的短语、命令片段、代码结构提前“记”进模型的底层结构里。就像你学编程时,不会一个字母一个字母地猜,而是直接记住 `git commit -m`、`pip install` 这种高频组合。LongCat-Flash-Lite 就是这么干的。

不是参数越多越好,而是用对地方

这个模型总参数有 685 亿,听起来不小,但每次运行时,真正被激活的只有 29 亿到 45 亿。其余 300 多亿参数,全用在了“嵌入层”——也就是模型的“词典”和“短语库”里。这些参数不参与复杂计算,只做快速查找:一看到 “kubectl get pods”,立刻知道你大概想干什么,不用再一层层推理。

这带来的变化很直接:在处理编程、运维、终端命令这类任务时,模型的准确率和响应速度都上了一个台阶。不是因为它“更聪明”,而是因为它“更熟悉”你日常用的那些词。

从模型到系统,每一环都为速度优化

光有想法不够,还得跑得快。LongCat 团队在系统层面做了三件很实在的事:

- 参数按需加载:嵌入层占了模型总参数的 46%,但查找速度是 O(1),像查字典一样快,不随规模变慢。

- 定制内核 + N-gram 缓存:他们自己写了 CUDA 内核,把多个计算步骤合并,减少内存来回搬运;还搞了个类似 KV Cache 的“N-gram Cache”,把常用命令片段缓存起来,下次直接用。

- 推测解码,提前猜:模型会先用一个轻量版本快速生成一个“草案”,再用主模型精修,相当于先写个草稿再润色,省下大量等待时间。

结果是:在输入 4K、输出 1K 的典型场景下,API 生成速度稳定在 500–700 token/秒。你打完一个命令,它几乎立刻就给出结果。支持最长 256K 上下文,适合处理长日志、复杂脚本或整份代码库。

真刀真枪的测试:代码、终端、智能体,全拿第一

他们没只吹指标,而是拿真实场景测试:

- 代码能力:在 SWE-Bench(真实 GitHub 问题修复)中准确率 54.4%,远超同尺寸模型;在 TerminalBench(执行真实 Linux 命令)中拿到 33.75 分,是同类模型里最高的。

- 智能体任务:在电信、零售、航空三大行业场景的 $tau^2$-Bench 中,全部拿下第一名,能准确理解“帮我查一下这个订单的物流状态”或“重置用户密码并通知”这类复杂指令。

- 通用能力:MMLU 得分 85.52,和 Gemini 2.5 Flash-Lite 差不多,数学题(AIME24)也能稳稳拿分,不是只会写代码的“偏科生”。

开源了,免费用,开发者直接上手

最让人惊喜的是,美团没藏着掖着。模型权重、完整技术报告、推理引擎 SGLang-FluentLLM,全部开源。你可以在 GitHub 上直接下载,本地跑起来。

如果你不想自己部署,也可以通过 LongCat API 开放平台 申请试用。每天免费送 5000 万 tokens,够你跑几百次代码生成、日志分析或自动化脚本任务。对开发者、运维、AI 工程师来说,这几乎是目前性价比最高的高性能小模型入口。

这不是又一个“参数堆砌”的模型。它更像是一个专为开发者和系统工程师打造的“效率工具”——不追求炫技,只解决真实问题。