苹果联手特拉维夫大学,让AI说话更快、更自然

你有没有遇到过这样的情况:手机语音助手卡顿半秒才回应,或者智能音箱念一句“明天天气晴”像在念说明书?不是设备慢,是背后的语音合成技术一直在“较真”。

最近,苹果联合以色列特拉维夫大学公布了一项低调却实用的突破:他们改写了AI生成语音的“思维方式”,让语音合成速度提升了近40%,而你听上去,根本没差别。这项技术叫“原则性粗粒度”(PCG),听起来像学术术语,其实说白了就是——别那么较真。

为什么AI说话总像在“背课文”?

目前主流的语音合成系统,像Siri、Google Assistant这些,背后用的都是“自回归模型”——也就是一个字一个字、一个音节一个音节地往前推。听起来像串珠子,但问题来了:只要某个音节的波形和训练数据差了0.001秒,系统就会觉得“不对劲”,强行重算,甚至重生成整个片段。

这就像你让一个钢琴手弹一首曲子,他每弹错一个音符,哪怕听众根本听不出来,他也必须停下来,从头再来一遍。结果呢?延迟高、耗电大、手机发烫。

“差不多就行”——人类听觉的智慧被AI学会了

苹果和特拉维夫大学的研究团队观察到一个简单却常被忽略的事实:人耳对声音的感知,远没有机器那么“精确”。

举个例子:你听朋友说“今天吃啥”,他声音稍微低一点、快一点、尾音拖半拍,你还是能听懂,还觉得是他。但AI不行,它会因为频率偏了2Hz,就判定“这不是我学过的音”。

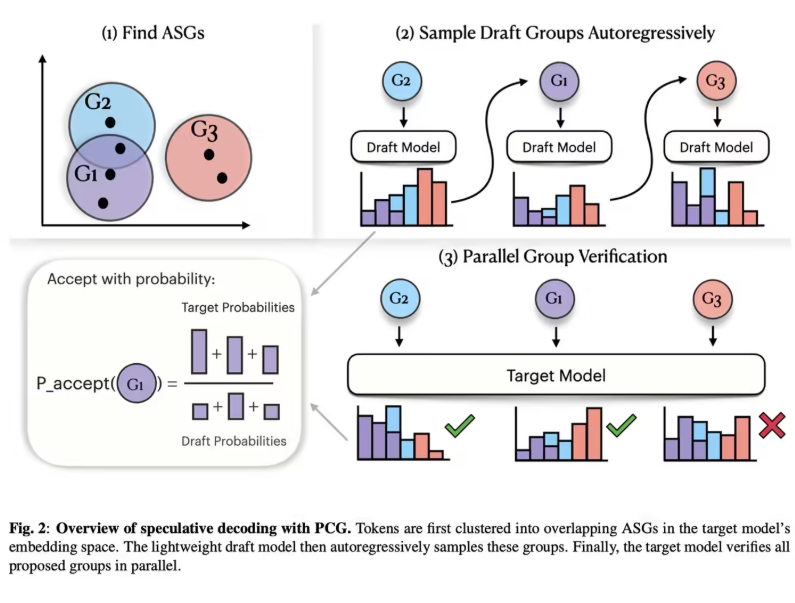

PCG技术的核心,就是让AI学会“放过”这些人类根本不在意的细节。他们把成千上万个相似的音段归类成“声学组”——比如“啊”这个音,有20种微小变体,但听感几乎一样。只要生成的音落在这个“合理区间”,系统就直接通过,不再死磕。

测试结果令人惊讶:在91.4%的语音片段中,AI用“近似音”替代了原始数据,普通用户完全听不出区别。在自然度评分(1~5分)中,系统拿到了4.09分——和顶级模型几乎持平。

不用重训、不占内存,现有手机马上能用

最打动人的地方,不是技术多炫,而是它太“接地气”了。

不需要重新训练Siri的语音模型,不需要更新iOS系统底层,甚至不需要你下载新应用——只要设备支持当前的语音合成服务,就能在后台悄悄启用PCG优化。额外内存占用仅37MB,相当于多存一张照片的大小。

这意味着,iPhone 14、iPad、Apple Watch,甚至未来可能搭载的AirPods Pro 3,都能在不增加功耗的前提下,说话更快、响应更顺。在开车时问导航、在健身时听语音提醒、在开会时用实时字幕——延迟从500毫秒降到300毫秒,体验差的不是技术,是“等得不耐烦”。

不只是苹果的事,未来语音交互将更“像人”

这项技术的意义,远不止于苹果自家产品。它为整个行业提供了一个新思路:AI语音不必追求“完美复刻”,而应追求“自然听感”。

国外已有语音平台如ElevenLabs、Resemble AI开始关注类似思路,而国内科大讯飞、腾讯AI Lab也在探索“感知驱动”的语音优化方向。PCG不是颠覆,而是回归——回归人类真实听觉的宽容性。

下次你听到手机语音更流畅了,别以为是系统升级了。可能是AI终于学会:不是每个音都得对得毫厘不差,只要听起来像你认识的人,就够了。