LingBot-VLA 开源:让机器人真正“看得懂、做得对”

继昨日开源高精度深度感知模型 LingBot-Depth 后,蚂蚁集团旗下灵波科技今日正式开源具身大模型 LingBot-VLA。这不是又一个实验室里的“演示模型”,而是一个能直接装进真实机器人、在复杂环境中稳定干活的“大脑”。它不挑机器人型号,不挑任务类型,也不怕环境突然变乱——你给它一套新设备、一个新任务,它能快速上手,不用从头训练。

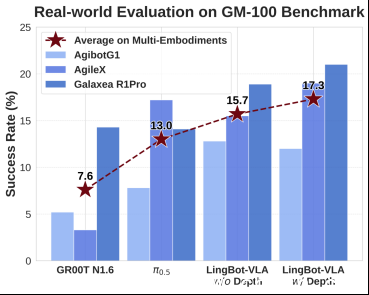

在由上海交大发布的 GM-100 真机评测中,LingBot-VLA 在三个完全不同结构的机器人上(包括 AgileX、Galaxea R1Pro、AgiBot G1)完成了100项真实操作任务。没有深度信息时,它的平均成功率是15.7%,比目前主流的 Pi0.5(13.0%)高出近21%。一旦接入 LingBot-Depth 提供的深度图,成功率直接冲到17.3%,创下当前真机测试的最高纪录。这不是模拟环境里的“纸上谈兵”,是实打实的机械臂抓杯子、开门、插插头、搬箱子的失败与成功统计。

(图说:在 GM-100 真机评测中,LingBot-VLA 跨本体泛化性能超越 Pi0.5)

仿真环境也扛得住,乱七八糟的环境它照样干

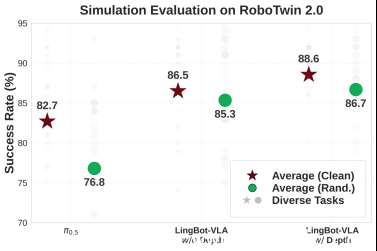

在 RoboTwin2.0 仿真平台,测试条件更“刁钻”:灯光忽明忽暗、桌上堆满杂物、桌面高度随机变化,连机器人自己的关节噪声都被加了干扰。大多数模型在这种环境下会“崩溃”,但 LingBot-VLA 凭借一套自研的“可学习查询对齐机制”,把深度信息和视觉信号深度融合,操作成功率比 Pi0.5 高出近10%。这意味着,它不仅能处理实验室里的干净场景,更能应对仓库、工厂、家庭这些真实世界里“一团乱麻”的环境。

(图说:在 RoboTwin2.0 仿真评测中,LingBot-VLA 跨任务泛化性能超越 Pi0.5)

为什么它能“一脑多机”?因为数据够硬

过去,想让一个机器人学会开门,你得为它录几百条视频、标注动作、调参数、再训练——换一台新机器人?重来一遍。成本高、周期长,根本没法规模化。

LingBot-VLA 的突破,来自20000+小时的真实机器人操作数据。这些数据不是拍出来的,是真机在实验室、工厂、仓库里日复一日干出来的。它见过9种主流双臂机器人:从 AgileX 到 Galaxea R1Lite,从 AgiBot G1 到松灵、星海图的设备,它都“摸”过。你给它一台新机器人,它不用重新学走路,它知道“这个手臂和之前那个差不多,动作逻辑能复用”。

配合 LingBot-Depth,它不仅能“看到”物体形状,还能“感知”距离、深度、遮挡关系。一个杯子在桌上,它知道是平放还是倒了;一个抽屉半开,它知道该往哪边拉、用多大力。这不是靠规则写出来的,是模型自己从海量数据里“悟”出来的。

你只需要80条演示,就能让它学会新任务

以前,想让机器人学会“给咖啡机加水”,你可能要录500条视频,花几周训练。现在,LingBot-VLA 只需要你录80条演示——你用手动遥控器带着机器人做一遍,它就能学会。这背后是模型强大的迁移能力,不是靠“记住动作”,而是理解“目标是什么、路径怎么规划、力道怎么控制”。

训练效率也快得惊人。相比 StarVLA、OpenPI 等主流框架,它的训练速度提升1.5到2.8倍。这意味着,你用同样的显卡,能跑更多实验;花同样的钱,能训练更多任务。对中小企业、高校实验室、机器人创业公司来说,这直接把落地门槛降了下来。

不只是模型,是一整套工具链

这次开源,不只给权重。你拿到的是完整的代码库:数据怎么处理、怎么微调、怎么自动评估、怎么部署到机器人上——全都有。连评估脚本都给你配好了,跑完自动出报告,告诉你成功率、失败原因、哪些动作不稳定。这不再是“黑箱模型”,而是你能动手改、能调试、能优化的工具。

我们和几家机器人厂商已经跑通了落地流程:星海图、松灵、乐聚的机器人,现在都能直接加载 LingBot-VLA,无需大改硬件或系统。这意味着,你买一台他们的机器人,未来可能直接通过软件升级,让它“变聪明”。

这不是终点,是起点

“我们不想做炫技的模型。”蚂蚁灵波科技CEO朱兴说,“我们想做的是,让机器人能真正用起来,而且用得起。”

过去,具身智能被看作是大厂的专利——数据、算力、团队缺一不可。LingBot-VLA 的开源,正在打破这个局面。一个学生团队,可以用一台二手机械臂+一台消费级GPU,跑通复杂任务;一个创业公司,不用从零造轮子,直接基于这个基座开发仓储分拣、家庭陪护、零售服务等场景应用。

这次开源,是蚂蚁“InclusionAI”计划的重要一步。他们不是在做技术秀,而是在搭建一个开放的生态:基础模型、多模态感知、推理架构、具身智能——全都在开源。他们希望,未来三年,中国能有上千个团队,基于这些开源模型,做出真正落地的产品。

如果你是机器人开发者、AI工程师、硬件创业者,或者只是对“机器人能干什么”感兴趣——现在,你可以亲自试试。LingBot-VLA 的代码、权重、文档,已经全部开放在 GitHub。你不需要等别人给你答案,你只需要动手,去让它学会一个新任务。