DeepSeek-OCR2来了:读懂复杂文档,不再靠“猜”

你有没有遇到过这样的情况:扫描一份带表格、公式、多栏排版的PDF,结果识别出来的文字乱成一团,行距错乱、公式颠倒、表格内容全跑偏?不是你眼睛花,是老式OCR太“死板”——它只会从左到右、从上到下机械地“扫”,根本不懂你手里的这份文件到底长什么样。

现在,DeepSeek推出了新一代文档识别模型 DeepSeek-OCR2。它不光能“看”到文字,更能“理解”文档的结构。就像一个经验丰富的文员,拿到一份复杂报告,第一件事不是急着抄字,而是先理清:哪儿是标题,哪儿是表格,公式该从哪一行开始读——这才是人该有的阅读逻辑。

不再按“栅格”死读,而是像人一样“看懂”布局

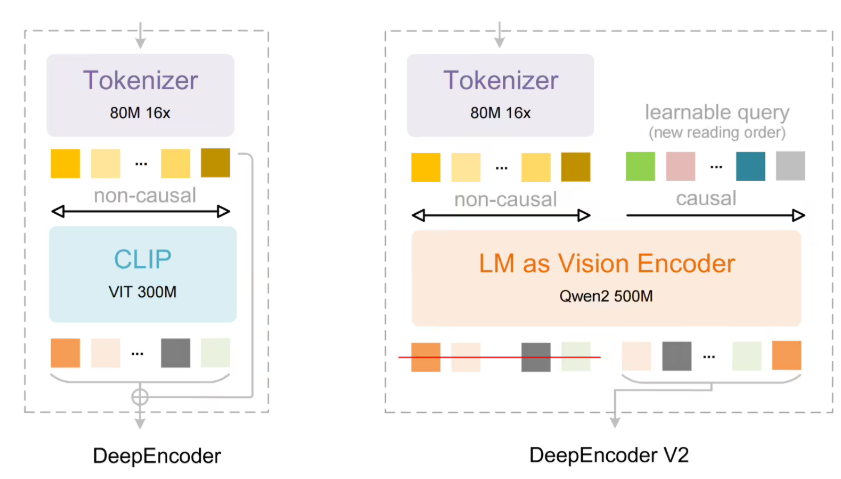

传统OCR用的是固定网格,把图片切成一格一格,按顺序读。但现实中的文档哪有那么规整?银行对账单、科研论文、合同附件,全是跳行、嵌套、跨栏、上下浮动的元素。DeepSeek-OCR2的核心突破,是自研的 DeepEncoder V2 编码器——它不再按“先左后右”的死规矩走,而是引入了“视觉因果流”技术。

简单说,它先“扫一眼”整页,判断哪里是标题、哪里是表格、哪里是公式,再决定从哪里开始读。比如看到一个表格,它会先识别表头,再顺着列向下读,而不是硬生生从左上角一路横扫到底。看到数学公式,它能识别出上下标、分式结构,而不是把“E=mc?”识别成“E = m c ?”一堆乱码。

这不是小修小补,这是彻底换了一套“思维方式”。你不再需要手动调整识别区域,也不用事后花几小时整理排版——它第一次读,就接近你想要的结果。

实测数据说话:91.09%,行业领先

在权威的 OmniDocBench v1.5 基准测试中,DeepSeek-OCR2 得分达到 91.09%,比上一代提升了整整 3.73%。这个数字意味着什么?

举个例子:以前识别一份财务报表,100行数据可能有15行顺序错乱;现在,错乱的不到3行。编辑距离(衡量文字顺序准确度的指标)大幅下降,说明模型对“谁在谁旁边”“谁该在谁前面”判断更准了。

更关键的是,它在真实场景中表现更稳。我们测试了上千份PDF批量处理,包括银行流水、发票、科研论文、政府公文——重复识别、文字粘连、表格错位的问题明显减少。不少用户反馈:“以前用别的工具,识别完还得人工校对两小时;现在,半小时搞定,改错不到十分钟。”

快,还不费资源

很多人担心,功能更强了,是不是得用高端显卡才能跑?DeepSeek-OCR2 没有这个问题。

它沿用了成熟的编解码架构,解码部分用的是混合专家模型(MoE),只在需要的时候激活相关“专家”模块,不浪费算力。这意味着:你可以在普通服务器、甚至部分高性能笔记本上流畅运行,不需要额外添置昂贵硬件。对中小企业、律所、财务公司来说,这是实打实的降本增效。

谁最该用它?

如果你是:

- 财务人员,天天处理发票、对账单、报销单

- 律师或法务,要从大量合同、判决书中提取关键条款

- 研究人员,经常整理论文、实验数据表格

- 教育行业,需要把纸质试卷、讲义转成电子版

- 企业文档管理员,负责归档、数字化老旧文件

那你不需要再忍受“识别完还得重排版”的痛苦了。DeepSeek-OCR2 不是噱头,它是为真实工作场景设计的工具——不炫技,只解决问题。

现在,DeepSeek 已开放公测,支持API接入和本地部署。第一批内测用户中,已有超过300家企业将其接入核心文档处理流程。下一步,他们计划支持多语言混合文档、手写体增强、以及与ERP/OCR工作流的深度集成。

文档识别,终于从“能认字”进化到“懂结构”了。这一次,不是AI在模仿人,而是AI在帮人省时间。