D4RT:让AI真正“看见”世界

过去几十年,摄像头成了机器的“眼睛”,但它们看到的,只是一个个静止的画面——像翻动的幻灯片,没有重量,没有惯性,也没有过去和未来。我们能用AI识别一只猫、一辆车,却无法让它理解:那辆车为什么突然刹车?那个行人为什么拐进小巷?物体在镜头外去了哪里?

今天,Google DeepMind 发布的 D4RT(Dynamic 4D Reconstruction and Tracking),第一次让机器不再“看画面”,而是“理解世界”。

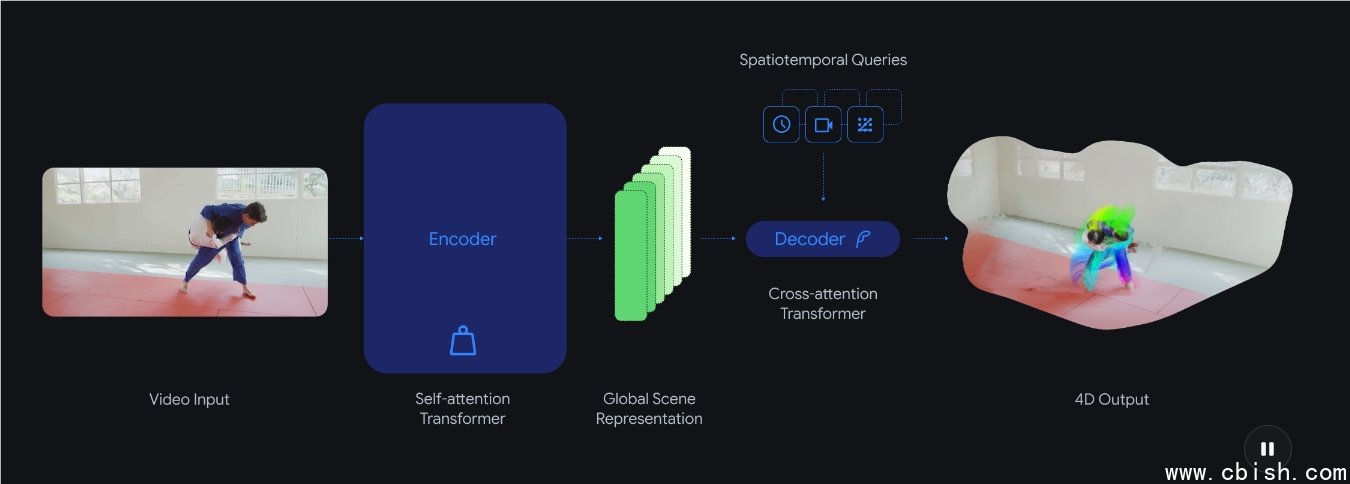

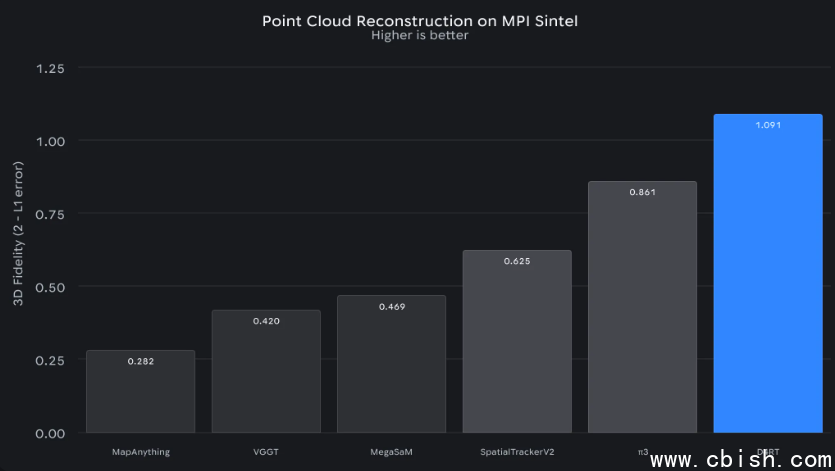

不再拼图,而是建模

以前的系统,像是一个由十几个工程师各自负责一块拼图的团队:有人算深度,有人跟踪运动,有人还原相机轨迹。每一块都得单独训练、单独运行,最后拼起来还经常对不上。一段30秒的视频,可能要花十几分钟,用上好几台高性能服务器才能处理完。

D4RT 的突破,是把这一切压缩成一个统一的模型。它不关心“你是谁”,也不关心“你从哪来”,它只问一个问题:

“这个像素,在这个时间点,从这个角度,到底在三维空间的哪个位置?”

听起来简单,但背后是它自己“脑补”出了整个世界。你给它一段手机拍的街景视频,它不仅能还原出每个物体的立体形状,还能推算出被遮挡的汽车在1.2秒前的轨迹,甚至能重建出拍摄者走路时的微小晃动路径——全靠它自己构建的“世界模型”。

快到不可思议

速度是它最直观的震撼。

过去,处理一段1分钟的视频,需要专业服务器跑10分钟。D4RT 做同样的事,只要5秒——在普通笔记本电脑上就能跑。

这不是“优化了算法”,而是彻底换了一种思路。它不再依赖层层叠加的模块,而是像人一样——瞥一眼,心里就有了整个场景。这种效率,让实时应用成为可能。

举个例子:如果你戴着AR眼镜走在街头,过去系统要等0.5秒以上才能把虚拟广告贴到真实路面上,结果你一动,它就“漂移”。D4RT 能把延迟压缩到20毫秒以内——快到你根本察觉不到延迟,虚拟物体就像真的长在现实里。

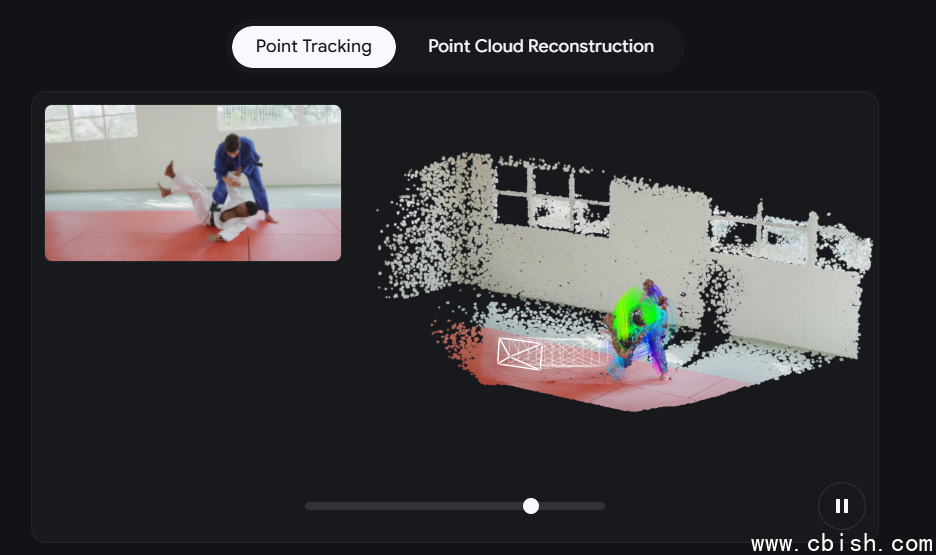

看不见的,它也能“猜”出来

人看世界,不是只靠眼睛。你看到一个人转身走进便利店,你立刻知道他可能在找饮料,哪怕你没看见他进去之后的动作。D4RT 也有这种“常识”。

- 全时空追踪:哪怕一个人在镜头里消失了3秒,被树挡住、拐进巷子,它依然能准确预测他接下来出现在哪个位置。

- 瞬时建模:不用反复迭代、不用等渲染,它能直接从一段视频里“弹出”整个场景的3D结构,连地面的坡度、窗户的反光都还原得清清楚楚。

- 自动还原相机运动:你用手机边走边拍,它能精确还原你走路的轨迹、抬头的幅度、甚至镜头轻微的抖动——不需要任何传感器。

这些能力,不是靠“大数据训练”堆出来的,而是模型自己学会了“理解物理”——物体有质量、有惯性、会遮挡、会反射光。它不是在认图,它在模拟现实。

落地场景:不只是技术演示

这项技术不是实验室里的玩具。它已经在几个关键领域开始发挥作用:

- 机器人导航:亚马逊和波士顿动力的内部测试显示,搭载D4RT的机器人能在杂乱仓库中,提前2秒预判搬运工的移动路径,避障成功率提升近40%。不再靠激光雷达,只用普通摄像头,成本直降70%。

- AR/VR:Meta 和 Snap 已在内测中用 D4RT 替换原有AR定位系统,手机拍下客厅,AR家具能“稳稳”放在地板上,不会漂移、不会穿模。连你蹲下来看沙发底下,虚拟物品也会跟着视角自然变化。

- 自动驾驶:特斯拉和小鹏的团队正在评估将其用于高精地图更新。过去靠专业测绘车跑半年才能完成的城市建模,现在用普通网约车的行车记录仪,一周就能完成。

- 影视与游戏:好莱坞已开始用 D4RT 从手机视频中自动生成演员的3D动作数据,省去动捕服和几十万的设备成本。独立游戏团队也能用手机拍一段街景,直接导入引擎做背景。

它不是让AI“更聪明”,而是让它“更像人”——看一眼,就知道世界怎么动,知道东西在哪,知道接下来会发生什么。

真正的未来,是看得懂世界的机器

我们不需要AI能下棋、能写诗。我们需要的是——它能看懂你递过来的一杯水,知道你手在抖,知道杯子会洒,知道该伸手接住。

D4RT 的意义,不是多快、多准,而是它第一次让机器拥有了“时间感”和“空间感”。它不再处理视频,它在理解生活。

这不是AI的进化,是机器终于开始“看见”我们生活的世界了。

了解更多:https://deepmind.google/blog/d4rt-teaching-ai-to-see-the-world-in-four-dimensions/