微软新机器人模型 Rho-alpha:让机器人听懂人话,用手做事

你有没有想过,未来家里的机器人不用编程、不用遥控,你随口说一句“把茶杯拿过来”,它就能准确找到、稳稳抓起、轻轻放到你手边?微软研究院最近推出的 Rho-alpha 模型,正在让这个场景变得真实可触。

不同于过去那些只能在固定车间里重复单一动作的工业机器人,Rho-alpha 的目标很简单:让机器人走进真实世界——杂乱的客厅、不整齐的厨房、突然被孩子碰倒的玩具堆。它不靠预设程序,而是靠“看”“摸”“听”来判断该怎么做。

一句话,机器人就懂你要什么

过去,让机器人完成一个双手配合的动作,比如拧开瓶盖、同时扶住杯子不洒水,需要工程师写几十行代码,调试好几天。现在,Rho-alpha 只要听懂你说:“帮我把桌上的水杯和开瓶器一起拿过来,先开盖再放回原位。”它就能自己拆解步骤、协调双手、判断重心,一气呵成。

这不是靠硬编码的脚本,而是模型在大量真实视频和人类操作数据中“看”出来的。微软团队公开表示,训练数据包含超过 10 万段人类完成日常任务的视频,涵盖不同角度、光照、物品摆放方式——哪怕你把杯子放在一摞书旁边,它也能认出来。

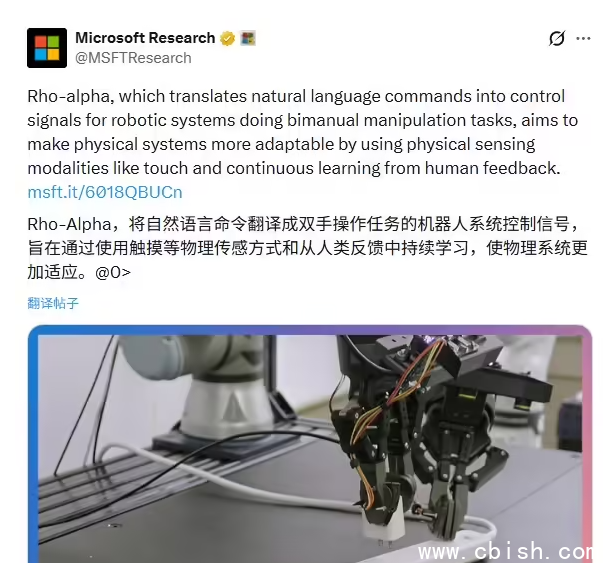

不只是眼睛,它还“有手感”

很多机器人能“看见”物体,但一碰就碎、一抓就滑。Rho-alpha 的突破在于,它第一次把触觉传感器和视觉系统深度打通了。

当你让它拿一个玻璃杯,它不是靠预设的“抓取力度”去硬抓,而是通过指尖的传感器实时感知压力变化:太轻?杯子会滑;太重?可能捏裂。它会像人一样,一点点调整手指角度和力度,直到稳稳拿住。

据微软工程师透露,下一步还将接入力反馈系统,让机器人能“感觉”到物体的重量和弹性——比如区分一个空塑料瓶和装满水的瓶子,或者轻轻托住一个刚烤好的蛋糕而不压扁它。

你纠正它,它就学得更快

没人指望机器人第一次就完美执行指令。Rho-alpha 的聪明之处,在于它愿意“听你讲”。

如果你发现它拿错了东西,或者动作太猛,你不需要写代码,也不用打开控制面板。只要戴上一个普通的 3D 操作手柄(类似游戏手柄),手动帮它纠正一次动作,系统就会自动记录:“原来主人不喜欢这样拿,下次要更轻一点。”

这套反馈机制已经在北京和西雅图的实验室里实测:经过五次人工干预后,机器人在类似任务中的成功率提升了近 70%。更重要的是,这些学习不只发生在一台机器人身上——所有真实操作数据都会匿名上传到 Azure 云平台,经过脱敏处理后,反哺给全球其他 Rho-alpha 系统,让整个群体越用越聪明。

不是科幻,是正在发生的改变

Rho-alpha 不是概念演示,也不是实验室里的“炫技”。微软已与几家家电厂商和养老护理机构展开试点合作,测试它在家庭辅助、老人照护场景中的表现。一位参与测试的老人说:“它能听懂我说‘把药盒从床头柜第二层拿给我’,还知道要轻轻放在我手上,不磕不碰——这比遥控器好用多了。”

未来一年,微软计划开放部分 API 给开发者,让更多人能基于 Rho-alpha 开发自己的机器人应用——从帮残障人士取物,到超市理货、仓库分拣,甚至宠物喂食。它的潜力不在“多厉害”,而在“多好用”。

真正的智能,不是会算多少数据,而是能读懂你没说出口的那句话:“别太急,慢一点。”