谷歌澄清:LLMs.txt 不是官方标准,别当真

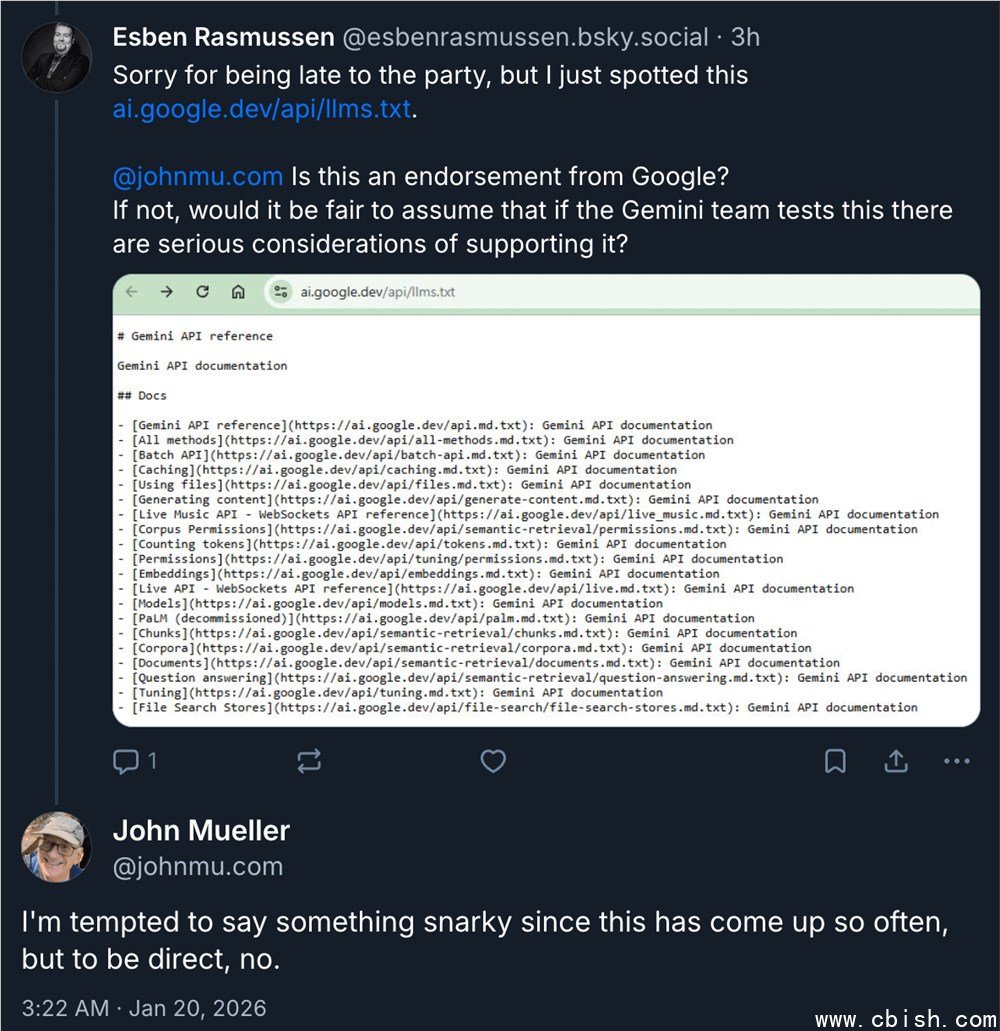

最近,一则关于谷歌是否“认可”LLMs.txt 文件的讨论在开发者圈里传开了。起因是有人在 Bluesky 上发现,谷歌的开发者文档里曾出现过这个文件,于是问:这是不是意味着谷歌支持用 LLMs.txt 来控制大模型爬虫?

谷歌搜索团队的资深工程师约翰·穆勒(John Mueller)直接在 Bluesky 上回应了:不是,完全不是。他明确表示,谷歌搜索团队**从不使用、也不推荐** LLMs.txt。这个文件的存在,只是因为内部某个团队在 CMS 系统里不小心加了进去,后来被搜索团队发现后立刻撤了——但没撤干净,留下了一些痕迹。

LLMs.txt 到底是个啥?为什么有人在用?

LLMs.txt 是一个非官方的文件,灵感来自 robots.txt。它的设想是:网站可以通过这个文件,告诉像 ChatGPT、Claude、Gemini 这类大模型的爬虫,“别抓我的内容”。比如:

User-agent: GPTBot Disallow: /private/ User-agent: CCBot Disallow: /

听起来很合理,对吧?但现实是,**目前主流大模型厂商几乎都不认这个文件**。OpenAI 的 GPTBot 有自己独立的 robots.txt 支持,Google 的 Gemini 爬虫也只认 robots.txt,Meta、Anthropic 等公司也没有公开表示会遵守 LLMs.txt。

换句话说,你写了 LLMs.txt,大概率是写给空气听的。它不会阻止任何主流模型抓取你的内容,反而可能让搜索引擎觉得你“在搞小动作”——毕竟,谷歌搜索团队都说了,这文件“可能是无用的”。

谷歌的态度:别折腾,老老实实用 robots.txt

穆勒的建议很直接:如果你真想控制大模型爬虫,**用 robots.txt 就够了**。GPTBot、Claude、Gemini 的爬虫都识别 robots.txt,而且谷歌自己也一直这么干。

他甚至建议:如果你已经写了 LLMs.txt,**最好加个 noindex 标签,别让它被搜索引擎抓到**。原因很简单——别让别人误以为你在“支持”这个非标准协议,更别让搜索引擎觉得你网站结构混乱。

现在网上有不少工具和插件,打着“一键优化 AI 爬虫控制”的旗号,自动生成 LLMs.txt。别信。这些工具要么是蹭热点,要么是把开发者当小白鼠做实验。真正靠谱的优化,还是看谷歌、OpenAI 官方文档。

开发者该怎么做?一句话总结

如果你是网站运营者、SEO 或内容平台管理员:

- ? 用 robots.txt 控制大模型爬虫(GPTBot、CohereBot、Google-Extended 等都有官方说明)

- ? 别写 LLMs.txt,除非你纯粹为了“心理安慰”

- ?? 如果已经写了,记得加 <meta name="robots" content="noindex">,别让它被搜到

- ???? 关注官方渠道:Google Search Central、OpenAI 的机器人页面,别看自媒体“解读”

谷歌不是反对技术进步,它只是不想让开发者被一堆“伪标准”带偏节奏。AI 爬虫还在早期阶段,规则还没定,这时候跟风搞非标准文件,只会给自己添麻烦。

别信“谷歌认可 LLMs.txt”,它没认。别信“不写就怕被爬”,你早该用 robots.txt 了。真正该关注的,是谷歌搜索团队接下来会怎么更新他们的爬虫规则——而不是去研究一个连谷歌自己都懒得用的文件。