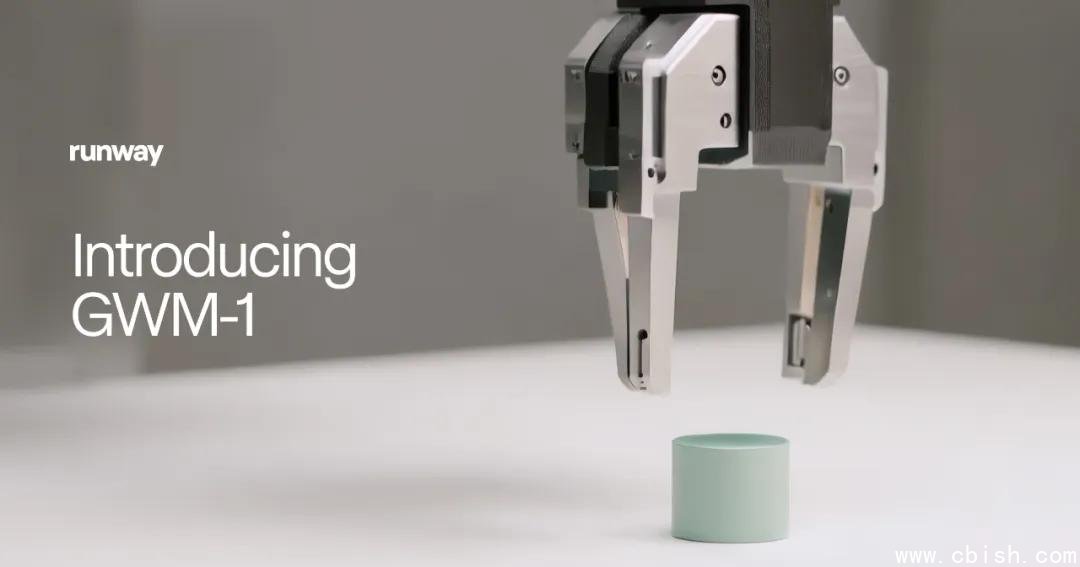

Runway发布全球首个通用世界模型GWM-1,重新定义AI对现实的模拟能力

就在今天,AI视频生成领域的领军者Runway正式推出其首个世界模型——GWM-1(Genetic World Model 1),正式进军被誉为“AI未来基石”的世界模型赛道。与传统仅能生成图像或短视频的模型不同,GWM-1能够像人类一样“理解”物理世界:它能预测物体如何运动、光影如何变化、碰撞如何发生,甚至能模拟雨雪天气对机器人行动的影响——这一切,无需任何真实世界的传感器数据。

Runway首席技术官Anastasis Germanidis表示:“我们不是在训练AI‘看’视频,而是在教它‘活’在世界里。直接预测像素,是让AI真正理解因果关系的唯一路径。当模型看到一个球从高处落下,它必须知道为什么它会加速、为什么地面会反弹它——而不是简单地复制过去帧的像素。”这一理念,让GWM-1在技术路线上与谷歌Genie-3、Meta的RT-2等模型形成鲜明区隔:它不依赖强化学习或人类标注,而是通过海量无标注视频数据,自主学习物理规律。

三大子模型首发:从虚拟世界到机器人训练,全面落地

GWM-1并非单一模型,而是由三个高度专业化子系统组成,分别瞄准内容创作、工业机器人和虚拟人三大高价值场景:

- GWM-Worlds:只需输入一段文字(如“黄昏时分,森林小径上有狐狸奔跑,落叶随风飘动”)或一张参考图,它就能生成一个完整、可交互的3D虚拟世界。支持24fps、720p实时渲染,光照、材质、碰撞检测全由模型自主推演。游戏开发者已开始用它快速搭建原型场景,而AI研究团队则用它训练导航代理——无需真实机器人,就能让AI在虚拟城市中学会避障、拐弯、等待红灯。

- GWM-Robotics:这是首个面向工业级机器人训练的世界模型。它能模拟极端环境:暴雨中的工厂地面湿滑、强光下的摄像头失焦、突然掉落的零件——这些现实中难以复现的危险场景,GWM-Robotics能在几秒内生成数千种变体。目前该模块已通过SDK开放给多家机器人企业,包括波士顿动力的合作伙伴与国内头部AGV厂商,用于提前发现算法漏洞,降低实机测试成本高达70%。

- GWM-Avatars:不再是僵硬的动画角色。GWM-Avatars能模拟人类细微动作:走路时手臂的自然摆动、被推搡时的平衡反应、甚至眼神跟随对话对象的微小转动。在虚拟主播、元宇宙社交、影视预演等领域,它已能生成媲美真人演员的自然行为,大幅减少动捕成本。

尽管目前三个子模型独立运行,但Runway透露,未来将整合为统一的“通用世界引擎”,实现跨场景迁移——比如让GWM-Avatars中的人物走进GWM-Worlds生成的虚拟城市,并与GWM-Robotics控制的机械臂互动。

Gen 4.5同步升级:AI视频进入“有声有戏”时代

在发布GWM-1的同时,Runway也更新了其爆款视频生成模型Gen 4.5,新增两大杀手级功能:

- 原生音频生成:首次实现视频与音频同步生成。你输入“一位爵士歌手在雨夜酒吧演唱《Feeling Good》,背景有雨滴敲窗和低沉钢琴”,模型不仅能生成画面,还能自动生成真实人声、环境音效,无需后期配音。

- 长时多镜头叙事:现在可生成长达60秒、包含3–5个镜头切换的连贯视频,角色服装、表情、动作保持高度一致,打破以往“每5秒重置”的碎片化困局。已有影视工作室用它制作分镜脚本,效率提升5倍。

据最新Video Arena排行榜数据,Gen 4.5已超越Google Veo与OpenAI Sora,成为全球生成质量最高的视频模型。而GWM-1更被业内专家称为“首个真正通用的世界模型”——它不局限于特定任务,而是像人类大脑一样,构建对世界运行的内在表征。

未来已来:世界模型,正在重塑AI的“常识”

世界模型的崛起,意味着AI正从“模仿者”转向“推理者”。当一个AI能预测“打翻水杯后地板会湿”,它就拥有了常识——而常识,是通向通用人工智能(AGI)的关键门槛。

目前,GWM-Robotics已启动企业内测,首批合作方包括特斯拉Autopilot团队、大疆创新与国内AI机器人新锐宇树科技。Runway也宣布,将在2025年Q2开放GWM-Worlds的开发者API,允许创作者在Unity、Unreal Engine中直接调用其物理引擎。

这不是又一个“更逼真的视频生成器”。这是AI第一次真正开始“理解”它所处的世界。而Runway,正站在这场革命的中心。