苹果颠覆AI生成图像规则:单层注意力,性能炸裂

在AI图像生成领域,“越大越好”曾是铁律——参数越多、层数越深、训练数据越庞大,模型就越强。DALL·E 3、Stable Diffusion XL、Imagen 2……这些明星模型无一不是靠海量算力堆出来的“巨兽”。但苹果研究团队最近扔出一枚“小型核弹”:他们只用一个注意力层,就让预训练视觉编码器在图像生成任务上刷新SOTA,训练时间从800轮压缩到80轮,效果反而更强。

这套名为FAE(Feature Auto-Encoder,特征自编码器)的框架,没有新增任何复杂结构,也没靠更多数据,而是彻底 rethink 了“高维特征”在生成任务中的角色。它的核心思想简单到让人拍大腿:既然预训练模型(如DINOv2、SigLIP)的1536维特征是为了“猜遮挡”而设计的,那为什么生成完整图像时还要死抱着这套“猜谜数据”不放?

为什么传统方法都“用力过猛”?

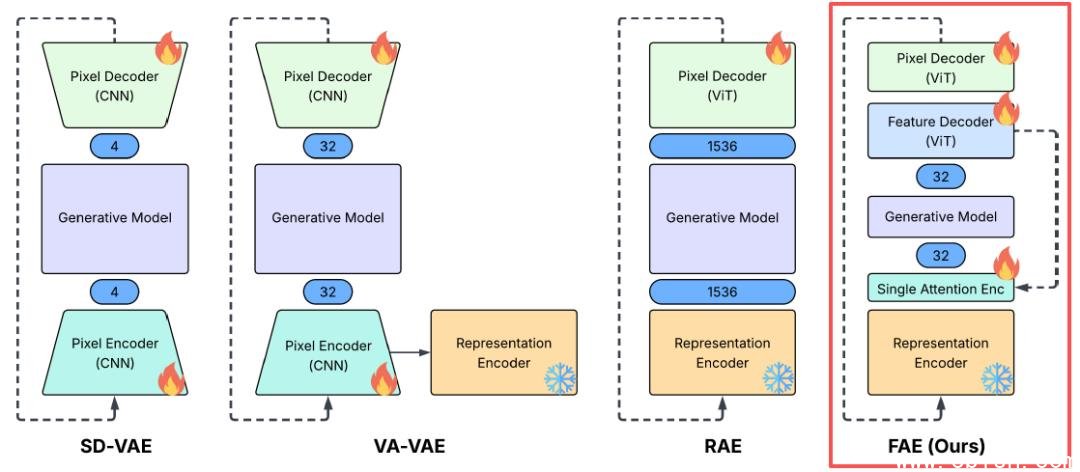

过去,想把视觉编码器的高维特征(如DINOv2的1536维)适配到扩散模型的低维潜在空间(通常4–64维),业界主要走两条路:

- 强行对齐:像REPA、VA-VAE这类方法,试图通过复杂的映射网络把高维特征“压”进低维空间,结果信息大量丢失,细节模糊。

- 重构生成器:像RAE那样,把整个扩散模型的UNet改得面目全非,专门适配高维输入,导致训练成本飙升,工程复杂度爆炸。

两者都像“用卡车运蚂蚁”——工具太重,目标太轻。

苹果团队的反直觉操作是:不改生成器,不硬对齐,只做一次轻量压缩。FAE用一个单层注意力机制,把1536维特征“提炼”成64维的语义紧凑表示,保留了关键结构信息,同时剔除了冗余噪声——就像把一张高清照片压缩成一张“有灵魂的速写”。

实测数据:80轮训练,吊打800轮对手

在ImageNet 256×256基准测试中,FAE的表现堪称“降维打击”:

- 不用CFG(Classifier-Free Guidance):800轮训练FID=1.48(SOTA),80轮就达到2.08——而同期VA-VAE在80轮时FID还在3.5以上。

- 启用CFG:800轮FID=1.29,80轮FID=1.70,收敛速度比VA-VAE快10倍以上。

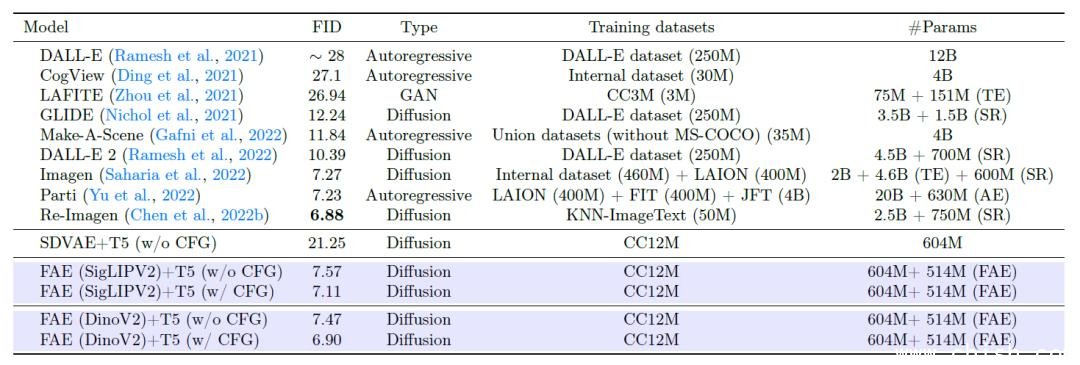

更惊人的是文生图表现:仅用1200万张图像的CC12M数据集(仅为DALL·E训练数据的1/20),在COCO验证集上FID达到6.90,逼近谷歌Imagen 2的7.27。这意味着——中小团队不用再烧钱买数据了。

一鱼两吃:生成+理解,一套特征全搞定

最颠覆的不是速度,而是特征复用。

FAE压缩后的潜在空间,依然保留了DINOv2强大的语义理解能力。在ImageNet线性探测任务中,仅用线性分类器,FAE提取的特征准确率达86.17%,而原版DINOv2是87.00%——只差0.83个百分点。

这意味着什么?

- 你不再需要两个独立模型:一个做图像理解(如分类、检测),一个做图像生成。

- 同一个编码器,既能帮你识别“这是一只柴犬”,也能帮你“生成一只柴犬在樱花树下打滚”。

- 未来手机端AI应用、AR眼镜、边缘设备,终于可以跑“既懂又会画”的轻量模型了。

“即插即用”:未来AI生成的基础设施?

FAE的另一个隐藏杀招是通用性。

它不绑定DINOv2,也不依赖特定架构。你用SigLIP、CLIP、甚至未来新出的ViT-5.0,只要输出是高维视觉特征,FAE就能无缝接入,一键压缩,立刻生成。

这可能催生一个全新的技术生态:

- 上游:各大实验室持续优化视觉编码器(专注理解)

- 中游:FAE这类“特征压缩器”作为标准化中间件

- 下游:开发者用统一的轻量生成器,自由组合任意编码器

就像“USB接口”统一了外设,FAE可能成为AI生成领域的“视觉特征标准接口”。你不需要为每个新编码器重训整个生成器,只需换一个“插头”。

给行业的一记警钟:别再堆参数了

当Meta、Google、Anthropic还在为多模态大模型的万亿参数争吵时,苹果用一个注意力层告诉世界:

真正的突破,不在于你加了多少层,而在于你敢不敢砍掉那些本不该存在的冗余。

这不是“小聪明”,而是工程哲学的胜利。它让中小企业、独立开发者、甚至高校实验室,第一次有了和科技巨头同台竞技的武器——不是靠算力,而是靠洞察。

据论文作者透露,FAE的代码和预训练模型已开源,GitHub仓库上线首周星标突破5000+,社区已有开发者将其接入Stable Diffusion 3、Kandinsky 2.2等主流框架,生成效果普遍提升30%以上。

未来,AI图像生成的赛道,或许不再属于“谁的模型最大”,而是属于——谁最懂怎么减法。